Introduksjon til enkel lineær regresjon

Fra ordbok : En retur til en tidligere eller mindre utviklet tilstand.

I statistikk: Et mål på forholdet mellom middelverdien til en variabel og tilsvarende verdier for de andre variablene.

Regresjonen, der forholdet mellom inngangsvariabelen (uavhengig variabel) og målvariabelen (avhengig variabel) regnes som lineær, kalles Lineær regresjon. Enkel lineær regresjon er en type lineær regresjon der vi bare har en uavhengig variabel for å forutsi den avhengige variabelen. Enkel lineær regresjon er en av maskinlæringsalgoritmer. Enkel lineær regresjon tilhører familien Supervised Learning. Regresjon brukes for å forutsi kontinuerlige verdier.

Modell for enkel lineær regresjon

La oss gjøre det enkelt. Hvordan det hele startet?

Det hele startet i 1800 med Francis Galton. Han studerte høydeforholdet mellom fedre og deres sønner. Han observerte et mønster: Enten sønnens høyde ville være like høy som farens høyde eller sønnens høyde vil ha en tendens til å være nærmere den gjennomsnittlige gjennomsnittshøyden for alle mennesker. Dette fenomenet er ikke annet enn regresjon.

For eksempel er Shaq O'Neal en veldig kjent NBA-spiller og er 2, 16 meter høy. Hans sønner Shaqir og Shareef O'neal er henholdsvis 1, 96 meter og 2, 06 meter høye. Den gjennomsnittlige befolkningshøyden er 1, 76 meter. Sønnens høyde regresserer (driver mot) middelhøyden.

Hvordan gjør vi regresjon?

Beregne en regresjon med bare to datapunkter:

Alt vi vil gjøre for å finne den beste regresjonen er å tegne en linje som er så nær hver prikk som mulig. Når det gjelder to datapunkter er det enkelt å tegne en linje, bare bli med dem.

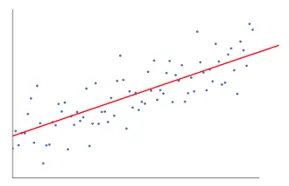

Hvis vi nå har et antall datapunkter, hvordan tegner du linjen som er så nær som mulig hvert eneste datapunkt.

I dette tilfellet er vårt mål å minimere den vertikale avstanden mellom linjen og alle datapunktene. På denne måten spår vi den beste linjen for vår lineære regresjonsmodell.

Hva enkel lineær regresjon gjør er?

Nedenfor er detaljforklaringen av Simple Linear Regression:

- Den tegner mange mulige linjer og gjør deretter noe av denne analysen.

- Summen av kvadratiske feil.

- Summen av absolutte feil.

- minst kvadratmetode… osv

- For vår analyse vil vi bruke den minst firkantede metoden.

- Vi vil utgjøre en forskjell på alle poeng og beregne kvadratet på summen av alle poengene. Uansett hvilken linje som gir minimumssummen vil være vår beste linje.

For eksempel: Ved å gjøre dette kunne vi ta flere menn og sønnens høyde og gjøre ting som å fortelle en mann hvor høy sønnen hans kunne være. før han til og med ble født.

Google-bilde

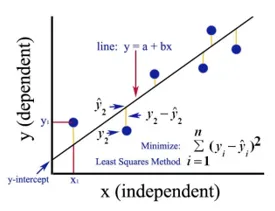

Figuren over viser en enkel lineær regresjon. Linjen representerer regresjonslinjen. Gitt av: y = a + b * x

Hvor y er den avhengige variabelen (DV): For for eksempel hvordan lønnen til en person endres avhengig av antall års erfaring den ansatte har. Så her vil lønnen til en ansatt eller person være din avhengige variabel.

Den avhengige variabelen er målvariabelen vår, den vi ønsker å forutsi ved bruk av lineær regresjon.

x er vår uavhengige variabel (IV): Den avhengige variabelen er årsaken til den uavhengige variabelen. I eksemplet ovenfor er antall års erfaring den avhengige variabelen vår, fordi antall års erfaring medfører endring i lønn til den ansatte.

- b er koeffisientvariabelen for vår uavhengige variabel x. Denne koeffisienten spiller en avgjørende rolle. Den sier hvordan en enhetsendring i x (IV) kommer til å påvirke y (DV). Det er også referert til som koeffisient for proporsjoner. Når det gjelder matematikk, er det opp til deg at du er skråningen på linjen, eller du kan si bratt av linjen.

- I vårt eksempel, hvis helling (b) er mindre, betyr det at antall år vil gi mindre lønnsøkning på den annen side hvis helningen (b) er mer, vil gi en høy lønnsøkning med en økning i antall År med erfaring.

- a er en konstant verdi. Det blir også referert til som avskjæring, det er der linjen krysser y-aksen eller DV-aksen. På en annen måte kan vi si at når en ansatt har null års erfaring (x), vil lønnen (y) for den ansatte være konstant (a).

Hvordan fungerer Least Square?

Nedenfor er poengene for minst kvadratisk arbeid:

- Det tegner en vilkårlig linje i henhold til datatrendene.

- Den tar datapunkter og tegner vertikale linjer. Den vurderer vertikal avstand som en parameter.

- Disse vertikale linjene vil kutte regresjonslinjen og gir det tilsvarende punktet for datapunkter.

- Den vil da finne den vertikale forskjellen mellom hvert datapunkt og det tilhørende datapunktet på regresjonslinjen.

- Den vil beregne feilen som er kvadrat av forskjellen.

- Den beregner deretter summen av feil.

- Så vil det igjen trekke en linje og gjenta prosedyren ovenfor igjen.

- Den tegner et antall linjer på denne måten, og linjen som gir minst feilfeil blir valgt som den beste linjen.

- Denne beste linjen er vår enkle lineære regresjonslinje.

Bruk av enkel lineær regresjon

Regresjonsanalyse utføres for å forutsi den kontinuerlige variabelen. Regresjonsanalysen har et bredt utvalg av applikasjoner. Noen eksempler er som følger:

- Predictive Analytics

- Effektiviteten av markedsføring,

- prissetting av eventuell oppføring

- promoteringsprediksjon for et produkt.

Her skal vi diskutere én anvendelse av lineær regresjon for prediktiv analyse. Vi skal gjøre modellering ved hjelp av python.

Trinnene vi skal følge for å bygge vår modell er som følger:

- Vi importerer bibliotekene og datasettene.

- Vi vil forhåndsbehandle dataene.

- Vi vil dele inn dataene i testsettet og treningssettet.

- Vi vil lage en modell som vil prøve å forutsi målvariabelen basert på treningssettet vårt

- Vi vil forutsi målvariabelen for testsettet.

- Vi vil analysere resultatene som er spådd av modellen

For vår analyse skal vi bruke et lønnsdatasett med dataene til 30 ansatte.

# Importere bibliotekene

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

# Importere datasettet (Eksempel på data vises i tabellen)

dataset = pd.read_csv('Salary_Data.csv')

| År med erfaring | Lønn |

| 1.5 | 37731 |

| 1.1 | 39343 |

| 2.2 | 39891 |

| 2 | 43525 |

| 1.3 | 46205 |

| 3.2 | 54445 |

| 4 | 55749 |

# Forhåndsbehandler datasettet, her vil vi dele datasettet i den avhengige variabelen og uavhengige variabelen. x som uavhengig og y som avhengig eller målvariabel

X = dataset.iloc(:, :-1).values

y = dataset.iloc(:, 1).values

# Del datasettet i treningssettet og testsettet:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size = 1/3, random_state = 0)

Her viser teststørrelse 1/3 at fra totale data er 2/3 del til trening av modellen og hvile 1/3 brukes til å teste modellen.

# La oss passe vår enkle lineære regresjonsmodell til treningssettet

from sklearn.linear_model import LinearRegression

regressor = LinearRegression()

regressor.fit(X_train, y_train)

Lineær regresjonsmodell er trent nå. Denne modellen vil bli brukt til å forutsi den avhengige variabelen.

# Å forutsi testsettets resultater

y_pred = regressor.predict(X_test)

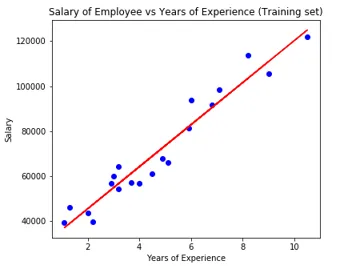

# Visualisere testsettets resultater

plt.scatter(X_test, y_test, color = 'blue')

plt.plot(X_train, regressor.predict(X_train), color = 'red')

plt.title('Salary of Employee vs Experience (Test set)')

plt.xlabel('Years of Experience')

plt.ylabel('Salary')

plt.show()

# Parameter av modell

print(regressor.intercept_)

print(regressor.coef_)

26816.19224403119

(9345.94244312)

Så interceptor-verdien (a) er 26816. Som tyder på at en hvilken som helst friskere (null erfaring) vil komme rundt 26816 beløp som lønn.

Koeffisienten for vår modell kom ut som 9345, 94. Det antyder at ved å holde alle de andre parametrene konstante, vil endringen i en enhet av den uavhengige variabelen (år med eksp.) Gi en endring på 9345 enheter i lønn.

Regresjonsevalueringsmetoder

Det er i utgangspunktet tre viktige evalueringsmetriksmetoder som er tilgjengelige for regresjonsanalyse:

- Gjennomsnittlig absolutt feil (MAE): Den viser gjennomsnittet av de absolutte feilene, som er forskjellen mellom forutsagt og faktisk.

- Gjennomsnittlig kvadratfeil (MSE): Den viser middelverdien av kvadratiske feil.

- Root Mean Squared Error (RMSE): Den viser kvadratroten til gjennomsnittet av de kvadratiske feilene.

Vi kan sammenligne ovenstående metoder:

- MAE: Den viser den gjennomsnittlige feilen og den enkleste av alle tre metodene.

- MSE: Denne er mer populær enn MAE fordi den forbedrer de større feilene, som i resultat viser mer innsikt.

- RMSE: Denne er bedre enn MSE fordi vi kan tolke feilen i form av y.

Disse tre er ikke annet enn tapsfunksjonene.

# Evaluering av modell

from sklearn import metrics

print('MAE:', metrics.mean_absolute_error(y_test, y_pred))

print('MSE:', metrics.mean_squared_error(y_test, y_pred))

print('RMSE:', np.sqrt(metrics.mean_squared_error(y_test, y_pred)))

MAE: 3426.4269374307123

MSE: 21026037.329511296

RMSE: 4585.4157204675885

Konklusjon

Lineær regresjonsanalyse er et kraftig verktøy for maskinlæringsalgoritmer, som brukes til å forutsi kontinuerlige variabler som lønn, salg, ytelse osv. Lineær regresjon vurderer det lineære forholdet mellom uavhengige og avhengige variabler. Enkel lineær regresjon har bare en uavhengig variabel basert på hvilken modellen spår målvariabelen. Vi har diskutert modellen og anvendelsen av lineær regresjon med et eksempel på prediktiv analyse for å forutsi lønnen til ansatte.

Anbefalte artikler

Dette er en guide til Simple Linear Regression. Her diskuterer vi modellen og anvendelsen av lineær regresjon, ved å bruke et prediktivt analyseeksempel for å forutsi ansattes lønn. Du kan også gå gjennom andre relaterte artikler for å lære mer-

- Lineær regresjonsanalyse

- Lineær regresjon i R

- Lineær regresjonsmodellering

- Verktøy for regresjonstesting

- Matplotlib In Python | Topp 14 tomter i Matplotlib

- Ordbok i Python | Metoder og eksempler

- Eksempler på Square Root i PHP

- Linear Regression vs Logistic Regression | Topp forskjeller