Introduksjoner til Data Science Algoritms

En beskrivelse på høyt nivå av de essensielle algoritmene som brukes i Data Science. Som du allerede vet, er datavitenskap et studieretning der beslutninger tas basert på den innsikten vi får fra dataene i stedet for klassiske regelbaserte deterministiske tilnærminger. Vanligvis kan vi dele en maskinlæringsoppgave i tre deler

- Innhenting av data og kartlegging av virksomhetsproblemet,

- Bruke maskinlæringsteknikker og observere ytelsesmetrikken

- Testing og distribusjon av modellen

I hele denne livssyklusen bruker vi forskjellige data science algoritmer for å løse oppgaven. I denne artikkelen vil vi dele opp de mest brukte algoritmene basert på læringstypene deres og vil ha en diskusjon på høyt nivå om disse.

Typer datavitenskap algoritmer

Basert på læringsmetodologiene kan vi ganske enkelt dele maskinlæring eller data science algoritmer i følgende typer

- Overvåkte algoritmer

- Uovervåkte algoritmer

1. Overvåkte algoritmer

Som navnet antyder overvåkte algoritmer er en klasse for maskinlæringsalgoritmer der modellen er opplært med de merkede dataene. Basert på de historiske dataene vil du for eksempel forutsi at en kunde vil misligholde et lån eller ikke. Etter forprosessering og funksjonsteknikk av de merkede dataene, trenes overvåkte algoritmer over strukturerte data og testes over et nytt datapunkt eller i dette tilfellet for å forutsi en misligholdelse av lån. La oss dykke inn i de mest populære veiledte maskinlæringsalgoritmene.

- K Nærmeste naboer

K nærmeste naboer (KNN) er en av de enkleste, men likevel kraftige maskinlæringsalgoritmene. Det er en overvåket algoritme der klassifiseringen gjøres basert på k nærmeste datapunkter. Tanken bak KNN er at lignende punkter er gruppert sammen, ved å måle egenskapene til nærmeste datapunkter kan vi klassifisere et testdatapunkt. For eksempel løser vi et standard klassifiseringsproblem der vi vil forutsi et datapunkt tilhører klasse A eller klasse B. La k = 3, nå tester vi 3 nærmeste datapunkt for testdatapunktet, hvis to av dem tilhører klassen A vi vil erklære testdatapunktet som klasse A ellers klasse B. Riktig verdi på K finnes gjennom kryssvalidering. Den har en lineær tidskompleksitet, og kan derfor ikke brukes til applikasjoner med lav latens.

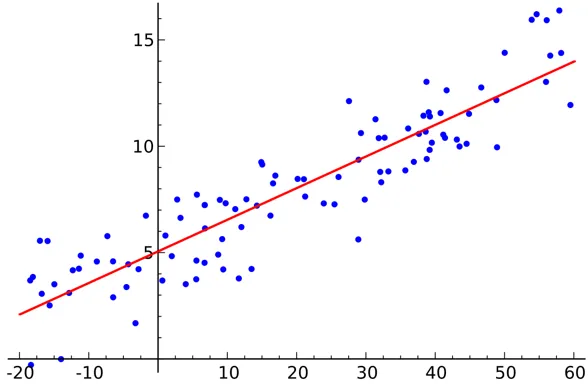

- Lineær regresjon

Lineær regresjon er en overvåket datavitenskapelig algoritme.

Produksjon:

Variabel er kontinuerlig. Tanken er å finne et hyperplan der det maksimale antall poeng ligger i hyperplanet. For eksempel er å forutsi regnmengden et standard regresjonsproblem der lineær regresjon kan brukes. Lineær regresjon forutsetter at forholdet mellom de uavhengige og avhengige variablene er lineært og at det er svært liten eller ingen multikollinearitet.

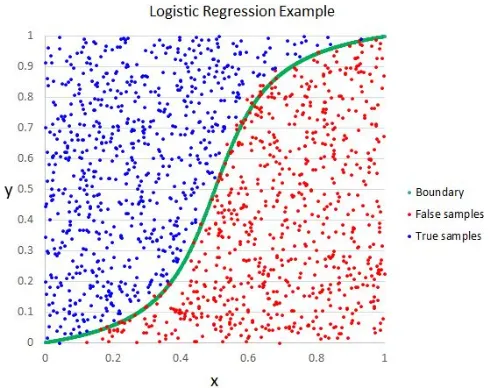

- Logistisk regresjon

Selv om navnet sier regresjon, er logistisk regresjon en overvåket klassifiseringsalgoritme.

Produksjon:

Den geometriske intuisjonen er at vi kan skille forskjellige klassemerker ved å bruke en lineær beslutningsgrense. Utgangsvariabelen for logistisk regresjon er kategorisk. Vær oppmerksom på at vi ikke kan bruke gjennomsnittlig kvadratfeil som en kostnadsfunksjon for logistisk regresjon, da den er ikke-konveks for logistisk regresjon.

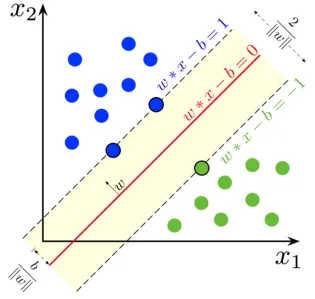

- Støtt vektormaskin

I logistisk regresjon var vårt viktigste motto å finne en skille lineær overflate.

Produksjon:

Vi kan betrakte støttevektormaskinen som en forlengelse av denne ideen der vi trenger å finne et hyperplan som maksimerer margen. Men hva er en margin? For en vektor W (beslutningsflaten vi trenger å komme opp med) tegner vi to parallelle linjer på begge sider. Avstanden mellom disse to linjene kalles margen. SVM antar at dataene kan skilles lineært. Selv om vi kan bruke SVM til ikke-lineære data, bruker vi også Kernel-trikset.

- Beslutningstre

Decision Tree er en nestet, hvis-annen-basert klassifiserer, som bruker en tre-lignende grafstruktur for å ta avgjørelsen. Beslutningstrær er veldig populære og en av de mest brukte veiledte maskinlæringsalgoritmer innen hele datavitenskapen. Det gir bedre stabilitet og nøyaktighet i de fleste tilfeller sammenlignet med andre overvåkte algoritmer og robust overfor utleggere. Utgangsvariabelen til beslutnings-treet er vanligvis kategorisk, men den kan også brukes til å løse regresjonsproblemer.

- ensembler

Ensembler er en populær kategori av datavitenskapelige algoritmer der flere modeller brukes sammen for å få bedre ytelse. Hvis du er kjent med Kaggle (en Google-plattform for å trene og konkurrere i data science utfordringer), vil du finne at de fleste vinnerløsningene bruker noen form for ensembler.

Vi kan grovt dele opp ensembler i følgende kategorier

- bagging

- Styrking

- Stacking

- Cascading

Random Forest, Gradient Boosting Decision Trees er eksempler på noen populære ensemble-algoritmer.

2. Uovervåkte algoritmer

Usikkerhetsalgoritmer brukes til oppgavene der dataene ikke er merket. Det mest populære brukssaken til algoritmer som ikke er overvåket er klynger. Clustering er oppgaven med å gruppere lignende datapunkter uten manuell intervensjon. La oss diskutere noen av de populære maskinlæringsalgoritmene uten tilsyn her

- K betyr

K Means er en randomisert, ikke-overvåket algoritme som brukes til gruppering. K Means følger trinnene nedenfor

1.Initialiser K-poeng tilfeldig (c1, c2..ck)

2. For hvert punkt (Xi) i datasettet

Velg nærmeste Ci (i = 1, 2, 3..k)

Legg Xi til Ci

3. Beregn centroid ved hjelp av riktige beregninger (dvs. intracluster avstand)

4, Gjenta trinn (2) (3) til konvergerer

- K betyr ++

Initialiseringstrinnet i K betyr er rent tilfeldig og basert på initialiseringen endres grupperingene drastisk. K betyr at ++ løser dette problemet ved å initialisere k på en sannsynlig måte i stedet for ren randomisering. K betyr at ++ er mer stabilt enn klassisk K betyr.

- K Medoids:

K-medoider er også en klyngealgoritme basert på K-midler. Hovedforskjellen mellom de to er centroids av K betyr ikke nødvendigvis eksisterer i datasettet, noe som ikke er tilfelle for K medoider. K-medoider gir bedre tolkbarhet av klynger. K betyr minimerer den totale kvadratiske feilen mens K medoider minimerer forskjellen mellom punktene.

Konklusjon

I denne artikkelen diskuterte vi de mest populære maskinlæringsalgoritmene som brukes innen datavitenskap. Etter alt dette kan det hende at et spørsmål dukker opp om at ' Hvilken algoritme er den beste? ' Det er klart det ikke er noen vinner her. Det avhenger bare av oppgaven og forretningsbehov. Som en god praksis starter alltid med den enkleste algoritmen og øker kompleksiteten gradvis.

Anbefalte artikler

Dette har vært en guide til Data Science Algorithms. Her har vi diskutert en oversikt over data science algoritmer og to typer data science algoritmer. Du kan også gå gjennom artiklene våre for å lære mer-

- Data Science-plattformen

- Datavitenskapelig språk

- Klassifiseringsalgoritmer

- Data mining algoritmer

- Mest brukte teknikker for læring av ensemble

- Enkle måter å lage beslutningstreet på

- Komplett guide til datavitenskapens livssyklus