Oversikt over Decision Tree i R

Et beslutnings tre i r er en form for veiledet læring som brukes til å rette opp klassifiserings- og regresjonsproblemene. De er en sterk maskinlæringsalgoritme for å jobbe med veldig komplekse datasett. Kjernekonseptet bak beslutningstreet er å dele opp det gitte datasettet. For å gå gjennom denne artikkelen foreslås det å ha grunnleggende læringskonsepter på beslutnings-tre-algoritmen.

Avgjørelsestre i R

For å jobbe med et beslutnings-tre i R eller i lekmannsbetingelser er det nødvendig å jobbe med store datasett og direkte bruk av innebygde R-pakker gjør arbeidet enklere. Et beslutnings tre er ikke-lineær antagelsesmodell som bruker en trestruktur for å klassifisere forholdene. Beslutnings-treet i R bruker to typer variabler: kategorisk variabel (Ja eller Nei) og kontinuerlige variabler. Terminologiene til Decision Tree som består av rotnoden (danner en klassemerke), beslutningsnoder (undernoder), terminalnode (deles ikke videre). Det unike konseptet bak denne tilnærmingen til maskinlæring er at de klassifiserer de gitte dataene i klasser som danner ja eller nei flyt (hvis-ellers tilnærming) og representerer resultatene i en trestruktur. Algoritmen som brukes i Decision Tree i R er Gini-indeksen, informasjonsgevinst, Entropy. Det er forskjellige pakker tilgjengelig for å bygge et beslutnings tre i R: rpart (rekursivt), parti, tilfeldig skog, CART (klassifisering og regresjon). Det er ganske enkelt å implementere et Decision Tree i R.

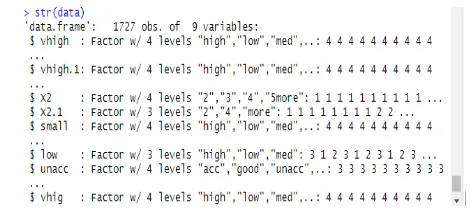

For tydelig analyse er treet delt inn i grupper: et treningssett og et testsett. Følgende implementering bruker et bildatasett. Dette datasettet inneholder 1727 obs og 9 variabler, som klassifiseringstreet er bygget med. I denne artikkelen kan tre en "fest" -pakke. Funksjonen oppretter () gir betingede trær med plottfunksjonen.

Implementering ved bruk av R

Målet er å studere et bildatasett for å forutsi om en bilverdi er høy / lav og middels.

i) Utarbeide data

Installere pakkene og laste inn biblioteker

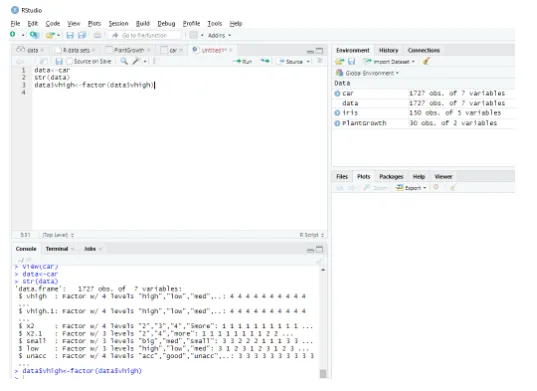

Denne modulen leser datasettet som en komplett dataramme, og strukturen til dataene er gitt som følger:

data<-car // Reading the data as a data frame

str(data) // Displaying the structure and the result shows the predictor values.

Produksjon:

Determining Factordata$vhigh View(car)

> data<-car

ii) Partisjonere en data

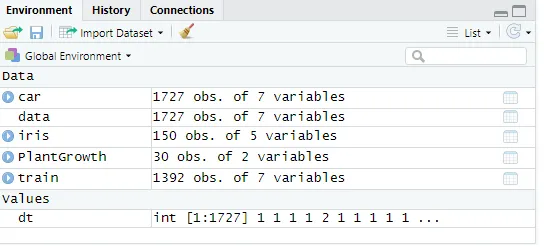

Del opp dataene ved å bruke treningsdatasett. Et beslutnings tre er delt inn i undernoder for å ha god nøyaktighet. Kompleksiteten bestemmes av størrelsen på treet og feilraten. Her å gjøre reproduktivitet og generere en rekke rader.

set. Seed (1234)

dt<-sample (2, nrow(data), replace = TRUE, prob=c (0.8, 0.2))

validate<-data(dt==2, )

Fig : Viser dataverdier

Deretter gjør dataverdien til 2

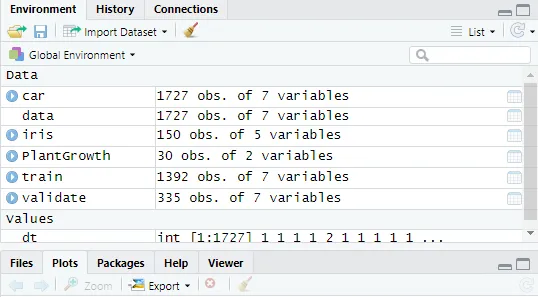

validate<-data(dt==2, )

Fig : Viser R-konsoll i R Studio

Opprette et beslutningstre i R med pakkefesten

- Klikk på pakke-> installer -> fest. Her har vi tatt de tre første innspillene fra utvalget av 1727 observasjoner på datasett. Lage en modell for å forutsi høyt, lavt, middels blant innspillene.

Gjennomføring:

library(party)

tree<-ctree(v~vhigh+vhigh.1+X2, data = train)

tree

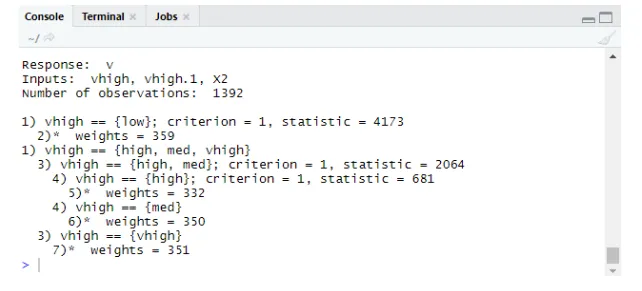

Produksjon:

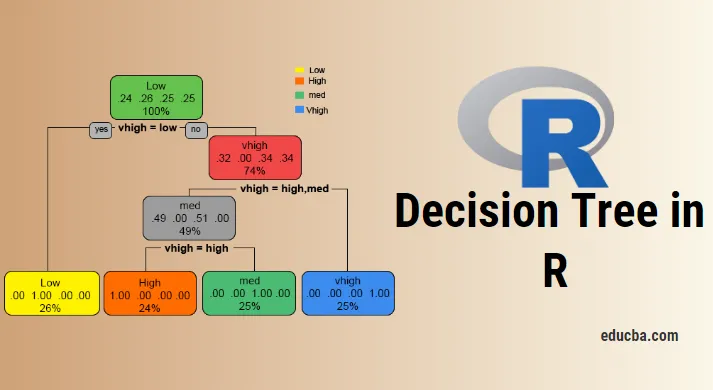

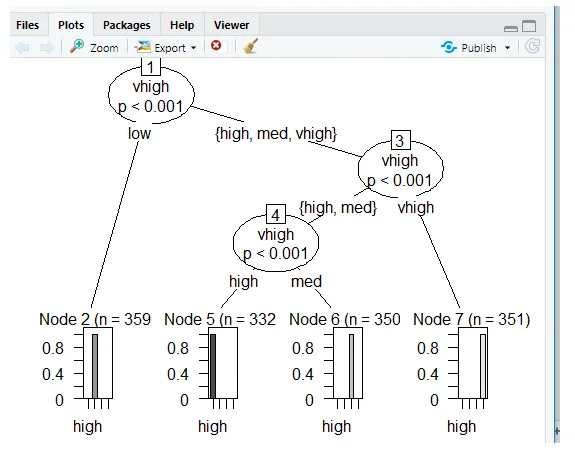

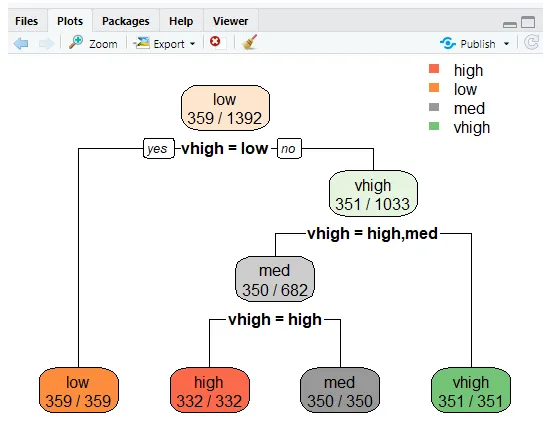

Tomter ved bruk av Ctree

Prediksjon:

Prob genererer sannsynlighet for scoring,

Gjennomføring:

predict(tree, validate, type="prob")

predict(tree, validate)

Nivåer: høyt lavt med høy

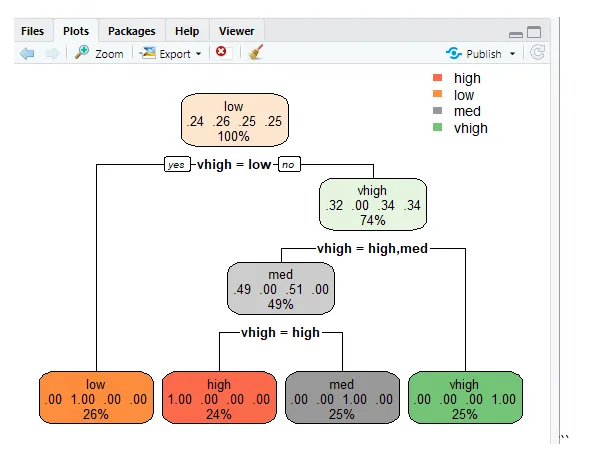

Avgjørelses tre ved bruk av rpart

For å forutsi klassen ved å bruke rpart () -funksjonen for klassemetoden. rpart () bruker Gini-indeksmålet for å dele noder.

library(rpart)

tr<-rpart (v~vhigh+vhigh.1+X2, train)

library (rpart. plot)

rpart. plot(tr)

“

“

rpart.plot(tr, extra=2)

Denne linjen plotter treet og for å vise sannsynligheten for å gjøre ekstra funksjoner til sett 2, og resultatet produsert er gitt nedenfor.

Feil ved feilklassifisering

Feilfrekvensen forhindrer overmontering.

tbl<-table(predict(tree), train $v)

print(tbl)

tepre<-predict(tree, new=validate)

Produksjon:

ut (TBL)

høy lav med vhigh

høy 332 0 0 0

lav 0 359 0 0

med 0 0 350 0

høy 0 0 0 351

Konklusjon

Avgjørelsestreet er en viktig utfordring i R, og styrken til treet er at de er enkle å forstå og lese når de sammenlignes med andre modeller. De blir populært brukt i datavitenskapelige problemer. Dette er verktøyet som produserer hierarkiet av beslutninger implementert i statistisk analyse. Det kreves statistisk kunnskap for å forstå de logiske tolkningene av beslutningstreet. Som vi har sett, er avgjørelsestreet enkelt å forstå, og resultatene er effektive når det har færre klassetiketter, og den andre ulempen med dem er når det er flere klassetikettberegninger som blir komplekse. Dette innlegget gjør at man blir dyktig til å bygge prediktive og trebaserte læringsmodeller.

Anbefalte artikler

Dette er en guide til Decision Tree i R. Her diskuterer vi introduksjonen, hvordan du bruker og implementerer R. Du kan også gå gjennom andre foreslåtte artikler for å lære mer -

- Hva er et binærtre i Java?

- R Programmeringsspråk

- Hva er Visual Studio Code?

- Introduksjon til linjediagram i R

- Guide to Binomial Distribution in R