Introduksjon til kjernemetoder i maskinlæring

Algoritmen brukt for mønsteranalyse kalles Kernel Method in Machine Learning. Generelt sett blir analyse gjort for å finne relasjoner i datasett. Disse forholdene kan være klynger, klassifisering, hovedkomponenter, korrelasjon, etc. De fleste av disse algoritmene som løser disse oppgavene med å analysere mønsteret, trenger dataene i rårepresentant, for å eksplisitt bli transformert til en funksjonsvektorrepresentasjon. Denne transformasjonen kan gjøres via et brukerspesifisert funksjonskart. Så det kan tas at bare den brukerspesifiserte kjernen kreves av kjernemetoden.

Terminologien Kernal Method kommer fra det faktum at de bruker kjernefunksjon, som gjør at de kan utføre operasjonen i høydimensjonalt, implisitt funksjonsrom uten behov for å beregne koordinatene til dataene i det rommet. I stedet beregner de bare det indre produktet mellom bildene av alle datapar på funksjonsområdet.

Denne typen operasjoner er beregningsmessig billigere mesteparten av tiden sammenlignet med eksplisitt beregning av koordinatene. Denne teknikken blir betegnet som 'kjernetriks'. Enhver lineær modell kan konverteres til en ikke-lineær modell ved å bruke kjernetriks på modellen.

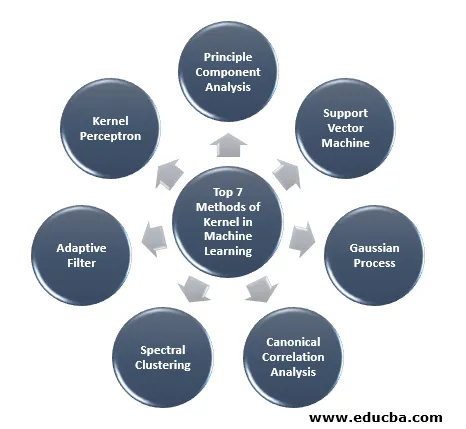

Kernemetode som er tilgjengelig i maskinlæring er hovedkomponentanalyse (PCA), spektralklynging, støttevektormaskiner (SVM), kanonisk korrelasjonsanalyse, kjernepersceptron, Gaussiske prosesser, ryggregresjon, lineære adaptive filtre og mange andre. La oss ha høy forståelse av noen av disse kjernemetodene.

Topp 7 metoder for kjerne i maskinlæring

Her er metodene til Kernel in Machine Learning nevnt nedenfor:

1. Prinsippkomponentanalyse

Principal component analysis (PCA) er en teknikk for å trekke ut struktur fra muligens høydimensjonale datasett. Det utføres enkelt ved å bruke iterative algoritmer som estimerer hovedkomponenter eller ved å løse et egenverdiproblem. PCA er en ortogonal transformasjon av koordinatsystemet der vi beskriver dataene våre. Det nye koordinatsystemet er oppnådd ved projeksjon på de viktigste aksene til dataene. Et lite antall hovedkomponenter er ofte tilstrekkelig til å redegjøre for det meste av strukturen i dataene. En av dens viktigste applikasjoner er å utføre undersøkende dataanalyse for å lage en prediktiv modell. Det ble mest brukt til å visualisere sammenhengen mellom populasjoner og genetisk avstand.

2. Støtt vektormaskin

SVM kan defineres som en klassifiserer for å skille hyperplan der hyperplan er underområdet til en dimensjon mindre enn omgivelsesområdet. Dimensjonen til dette matematiske rommet er definert som minimum antall koordinater som kreves for å spesifisere et hvilket som helst punkt mens omgivelsesområdet er det rommet som omgir det matematiske objektet. Nå kan matematisk objekt forstås som et abstrakt objekt som ikke eksisterer på noe tidspunkt eller sted, men som eksisterer som en type ting.

3. Gaussisk prosess

Den Gaussiske prosessen ble oppkalt etter Cark Friedrich Gauss fordi den bruker notasjonen om Gaussisk distribusjon (normalfordeling). Det er en stokastisk prosess som betyr en samling tilfeldige variabler indeksert av tid eller rom. I Gaussian Process har tilfeldige variabler en multivariat normalfordeling, dvs. at alle de endelige lineære kombinasjonene av den er normalt fordelt. Den Gaussiske prosessen bruker egenskapene som er arvet fra en normal distribusjon og er derfor nyttige i statistisk modellering. Maskinlæringsalgoritme som involverer denne kjernemetoden bruker mål på lat læring og likheten mellom poeng for å forutsi verdien av usett poeng fra treningsdata. Denne prediksjonen er ikke bare estimatet, men usikkerheten på det tidspunktet.

4. Kanonisk korrelasjonsanalyse

Kanonisk korrelasjonsanalyse er en måte å trekke ut informasjon fra matriser på tvers av samvariasjoner. Det er også kjent som kanonisk variasjonsanalyse. Anta at vi har to vektor X, Y av tilfeldig variabel sier to vektorer X = (X1, …, Xn) og vektor Y = (Y1, …, Ym), og variabelen har korrelasjon, så vil CCA beregne en lineær kombinasjon av X og Y som har den maksimale korrelasjonen mellom hverandre.

5. Spektralklusering

Ved bruk av bildesegmentering er spektralklusering kjent som segmenteringsbasert objektskategorisering. I Spectral Clustering blir dimensjonalitetsreduksjon utført før clustering i færre dimensjoner, dette gjøres ved å bruke egenverdien til likhetsmatrisen til dataene. Det har sine røtter i grafteori, der denne tilnærmingen brukes til å identifisere fellesskap av noder i en graf som er basert på kantene som forbinder dem. Denne metoden er fleksibel nok og gjør at vi også kan klynge data fra ikke-graf.

6. Adaptivt filter

Det adaptive filteret bruker et lineært filter som omfatter en overføringsfunksjon, som styres av variable parametere og metodene, som vil bli brukt for å finpusse disse parametrene i henhold til optimaliseringsalgoritmen. Kompleksiteten i denne optimaliseringsalgoritmen er grunnen til at alt adaptivt filter er et digitalt filter. Et adaptivt filter er nødvendig i de applikasjonene der det ikke er forhåndsinformasjon om ønsket prosesseringsoperasjon på forhånd eller de endrer seg.

Kostnadsfunksjonen brukes i det lukkede tilpasningsfilteret, ettersom det er nødvendig for optimal ytelse av filteret. Den bestemmer hvordan du skal endre filteroverføringsfunksjonen for å redusere kostnadene for neste iterasjon. En av de vanligste funksjonene er den midlere kvadratfeilen til feilsignalet.

7. Kernel Perceptron

I maskinlæring er kjernen perceptron en type av den populære læringsalgoritmen perceptron som kan lære kjernemaskiner, for eksempel ikke-lineære klassifiserere som bruker en kjernefunksjon for å beregne likheten til de prøvene som er usett til treningsprøver. Denne algoritmen ble oppfunnet i 1964, og gjorde den til den første kjernen klassifiseringseleven.

De fleste av de diskuterte kjernealgoritmene er basert på konveks optimalisering eller egenproblemer og er statistisk godt begrunnet. Deres statistiske egenskaper blir analysert ved bruk av statistisk læringsteori.

Når vi snakker om applikasjonsområdene for kjernemetoder, er det mangfoldig og inkluderer geostatistikk, kriging, invers avstandsvekt, 3D-rekonstruksjon, bioinformatikk, kjemoinformatikk, informasjonsutvinning og håndskriftgjenkjenning.

Konklusjon

Jeg har oppsummert noen av terminologiene og typene kjernemetoder i Machine Learning. På grunn av mangel på plass er denne artikkelen på ingen måte omfattende og er bare ment å gi deg en forståelse av hva kjernemetoden er og en kort oppsummering av deres typer. Imidlertid vil du dekke denne artikkelen få deg til å ta det første trinnet innen maskinlæring.

Anbefalte artikler

Dette er en guide til Kernel Method in Machine Learning. Her diskuterer vi de 7 typene kjernemetoder i maskinlæring. Du kan også se på den følgende artikkelen.

- Monolitisk kjerne

- Clustering in Machine Learning

- Data Science Machine Learning

- Uovervåket maskinlæring

- PHP-filtre | Hvordan validerer brukerinndata ved hjelp av forskjellige filtre?

- Komplett guide til maskinlæring livssyklus