Forskjell mellom Små data og big data

Små data er ikke annet enn dataene som er små nok omfattende for mennesker i et volum og også for formatering, som gjør dem tilgjengelige, informative og handlingsrike. Den tradisjonelle databehandlingen kan ikke omhandle store eller komplekse data, disse dataene betegnes som Big Data. Når datavolumet vokser utover en viss grense, er tradisjonelle systemer og metoder ikke nok til å behandle data eller transformere data til et nyttig format. Dette er grunnen til at data generelt kategoriseres i to - Small Data vs Big Data

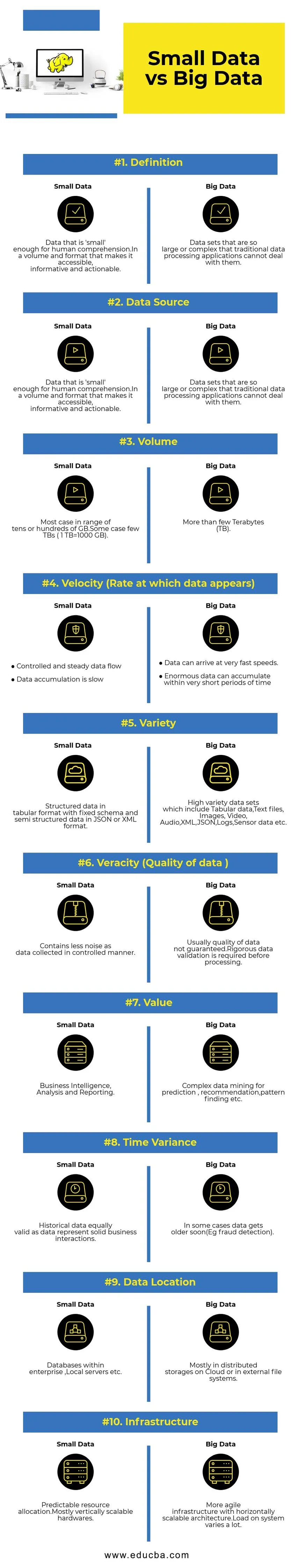

Sammenligning fra topp til hodet mellom smådata og bigdata (Infografikk)

Nedenfor er topp 10 forskjellen mellom smådata og bigdata

Viktige forskjeller mellom smådata vs bigdata

- Datainnsamling - Vanligvis er Small Data en del av OLTP-systemer og samlet på en mer kontrollert måte og deretter satt inn i hurtigbufringslaget eller databasen. Databaser vil ha lest replikker for å støtte umiddelbare analysesøk om nødvendig. Big Data-innsamlingsrørledningen vil ha køer som AWS Kinesis eller Google Pub / Sub for å balansere data med høy hastighet. Nedstrøms vil ha strømningsrørledninger for sanntidsanalyse og batchjobber for kald databehandling.

- Databehandling - Som det meste av små data generert gjennom transaksjonssystemet, vil analyser på toppen av det være batchorientert mesteparten av tiden. I noen sjeldne tilfeller kjøres analytiske spørsmål direkte på transaksjonssystemer. Big Data-miljøer vil ha både batch- og stream-prosesseringsledninger. En strøm brukes til sanntidsanalyser som gjenkjenning av kredittkortsvindel eller prediksjon av aksjekurs. Batchbehandling brukt til å implementere kompleks forretningslogikk med data og avanserte algoritmer.

- Skalerbarhet - Små datasystemer skaleres vanligvis vertikalt. Vertikal skalering øker systemkapasiteten ved å legge til flere ressurser til den samme maskinen. Vertikal skalering er kostbar, men mindre kompleks å administrere. Big Data-systemer er stort sett avhengig av horisontalt skalerbar arkitektur som gir mer smidighet til en lavere pris. Forhindrende virtuelle maskiner tilgjengelig i skyen gjør horisontalt skalerbare systemer enda rimeligere.

- Datamodellering - Smådata generert fra transaksjonssystemer vil være i normalisert form.ETL (Extract Transform Load) datapipelinjer konverterer dem til stjerne- eller snøfnuggskjema i et datavarehus. Her blir skjema alltid håndhevet mens du skriver data som er relativt enkelt ettersom data er mer strukturert. Som nevnt ovenfor, er tabeldata bare en brøkdel av Big Data. Her blir data kopiert mye mer av forskjellige grunner som overlevering av feil eller på grunn av en viss begrensning av den underliggende databasemotoren (for eksempel støtter noen database bare en sekundærindeks per datasett). Et skjema håndheves ikke når du skriver. I stedet valideres et skjema mens du leser data.

- Storage & Computation Coupling - I tradisjonelle databaser som for det meste håndterer Small Data, er lagring og databehandling koblet tett. Innføring og henting av data til og fra databasen bare mulig gjennom det gitte grensesnittet. Data kan ikke settes direkte i databasefilsystemet, eller eksisterende data kan ikke spørres ved hjelp av andre DB-motorer. Egentlig bidrar denne arkitekturen til å sikre dataintegritet. Big Data-systemer har veldig løs kobling mellom lagring og beregning. Vanligvis lagres data i et distribuert datalagringssystem som HDFS, AWS S3 eller Google GCS og beregner motoren til spørringsdata eller gjør ETL valgt på et senere tidspunkt. For eksempel kan interaktive spørringer utføres ved å bruke Presto (Link) og ETL ved å bruke Apache Hive på de samme dataene.

- Data Science - Maskinlæringsalgoritmer krever inndata i et godt strukturert og riktig kodet format, og mesteparten av tiden vil inndatadata komme fra både transaksjonssystemer som et datavarehus og Big Data-lagring som en datasjø. Læringsalgoritmer til maskiner som kjører utelukkende på Small Data vil være enkle ettersom dataforberedelsesstadiet er smalt. Forberedelse og berikelse av data i Big Data-miljøet tar mye mer tid. Big Data gir mange alternativer for datavitenskapelig eksperimentering på grunn av det store volumet og mangfoldigheten av data.

- Datasikkerhet - Sikkerhetspraksis for små data som er bosatt på bedriftens datavarehus eller transaksjonssystemer levert av tilsvarende databaseleverandører som kan inkludere brukerrettigheter, datakryptering, hashing, etc. Å sikre Big Data-systemer er mye mer kompliserte og utfordrende. Beste praksis for sikkerhet inkluderer kryptering av data ved hvile og transitt, isolere klyngenettverk, sterke adgangskontrollregler, etc.

Small Data vs Big Data Comparison Table

| Grunnlag for sammenligning | Små data | Stor Data |

| Definisjon | Data som er 'små' nok for menneskelig forståelse. I et volum og et format som gjør det tilgjengelig, informativt og handlingsbart | Datasett som er så store eller komplekse at tradisjonelle databehandlingsapplikasjoner ikke kan håndtere dem |

| Datakilde | ● Data fra tradisjonelle bedriftssystemer som ○ Enterprise ressursplanlegging Management Styring av kundeforhold (CRM) ● Finansielle data som hovedbokdata ● Data om betalingstransaksjon fra nettstedet | ● Kjøp data fra salgsstedet ● Clickstream-data fra nettsteder ● GPS-strømdata - Mobilitetsdata sendt til en server ● Sosiale medier - facebook, twitter |

| Volum | De fleste tilfeller i en rekke titalls eller hundrevis av GB. Noen få tilfeller av TB (1 TB = 1000 GB) | Mer enn noen få terabyte (TB) |

| Hastighet (hastighet som data vises) | ● Kontrollert og jevn dataflyt ● Databehandling er langsom | ● Data kan komme i veldig høye hastigheter. ● Enorme data kan samles i løpet av veldig korte tidsperioder |

| Variasjon | Strukturerte data i tabellformat med fast skjema og semistrukturerte data i JSON- eller XML-format | Datasett med stor variasjon som inkluderer tabelldata, tekstfiler, bilder, video, lyd, XML, JSON, logger, sensordata etc. |

| Veracity (kvalitet på data) | Inneholder mindre støy som data samlet på en kontrollert måte. | Vanligvis er ikke kvaliteten på data garantert. Det kreves streng datavalidering før behandling. |

| Verdi | Business Intelligence, analyse og rapportering | Kompleks data mining for prediksjon, anbefaling, mønster funn, etc. |

| Tidsvarians | Historiske data som er like gyldige som data representerer solide forretningsinteraksjoner | I noen tilfeller blir data snart eldre (f.eks. Svindeloppdagelse). |

| Dataplassering | Databaser i en bedrift, lokale servere, etc. | Mest i distribuerte lagre på Cloud eller i eksterne filsystemer. |

| infrastruktur | Forutsigbar ressursallokering. Mest vertikal skalerbar maskinvare | Mer smidig infrastruktur med en horisontalt skalerbar arkitektur. Belastningen på systemet varierer mye. |

Konklusjon - Small Data vs Big Data

Det endelige målet for dataanalyse å få rettidig innsikt for å støtte beslutninger. Å kategorisere data i små og store er med på å takle utfordringer med å analysere data fra hver verden separat med riktige verktøy. Linjen mellom to kategorier varierer med nye avanserte databehandlingssystemer, noe som gjør selv big data-spørring mye raskere og mindre komplisert.

Anbefalte artikler:

Dette har vært en guide til Small Data vs Big Data, deres betydning, sammenligning mellom hodet og hodet, viktige forskjeller, sammenligningstabell og konklusjon. denne artikkelen inneholder alle viktige forskjeller mellom smådata og bigdata. Du kan også se på følgende artikler for å lære mer -

- Big Data vs Data Science - Hvordan er de forskjellige?

- Big Data: Viktig for sammenflytning av teknologi og forretningsanalyse

- Topp 5 big data trender som selskaper vil måtte mestre

- 16 interessante tips for å gjøre Big data til stor suksess