Hva er Apache Hadoop Ecosystem?

Apache Hadoop Ecosystem er et rammeverk eller en open source dataplattform som er tildelt for å lagre og undersøke de enorme datasamlingene ustrukturerte. Over hele verden er det massevis av data som blir fremdrevet fra en rekke digitale plattformer med den ledende innovative teknologien for big data. Dessuten var Apache Hadoop den første som fikk denne strømmen av innovasjon.

Hva består av Hadoop Data-arkitektur / økosystem?

Hadoop Ecosystem er ikke et programmeringsspråk eller en tjeneste, det er et rammeverk eller plattform som tar seg av big data-problemer. Du kan identifisere den som en pakke som omslutter forskjellige tjenester som lagring, svelging, vedlikehold og analyse inne i den. Så undersøk og få en kortfattet tanke om hvordan tjenestene fungerer eksklusivt og i samarbeid. Apache Hadoop-arkitekturen består av forskjellige innovasjoner og Hadoop-elementer der til og med de kompliserte informasjonsproblemene kan løses effektivt.

Følgende er skildringen av hver del: -

1) Namenode: Det guider prosessen med informasjon

2) Datanode: Den komponerer informasjonen til lokal lagring. Å lagre all informasjon på et entall sted foreslås ikke kontinuerlig, da det kan føre til tap av informasjon i tilfelle strømbrudd.

3) Oppgave tracker: De mottar oppgaver tildelt slaveknuten

4) Kart: Det tar informasjon fra en strøm, og hver linje blir håndtert delt for å dele den inn i forskjellige felt

5) Minsk: Her blir feltene, anskaffet gjennom Map samlet eller koblet sammen

Apache Hadoop Ecosystem - trinn for trinn

Hvert element i Hadoop-økosystemet, som spesifikke aspekter er åpenbare. Det omfattende perspektivet på Hadoop-strukturen gir oppmerksomhet til Hadoop Distribuerte filsystemer (HDFS), Hadoop YARN, Hadoop MapReduce og Hadoop MapReduce fra Hados økosystem. Hadoop gir til og med hvert Java-bibliotek, betydelige Java-poster, refleksjon av operativsystemnivå, fordeler og skript for å betjene Hadoop. Hadoop YARN er en metode for virksomhetsoversikt og ressursstyring. I Hadoop-konfigurasjon gir HDFS høy gjennomstrømning til applikasjonsinformasjon, og Hadoop MapReduce gir YARN-basert parallell forberedelse av omfattende datasortiment.

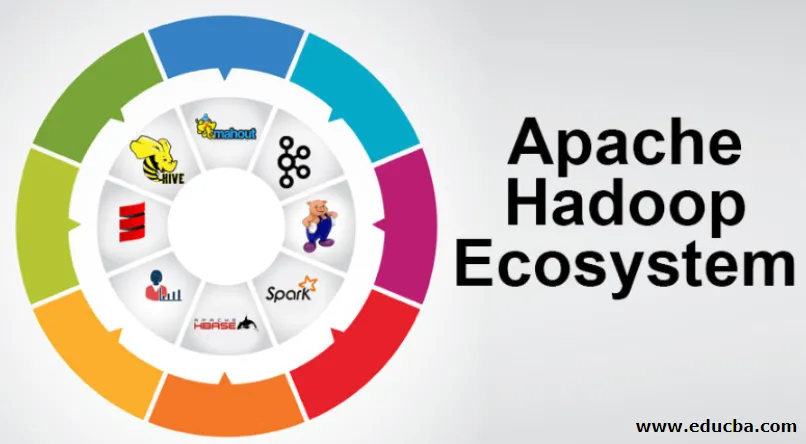

Apache Hadoop økosystemoversikt

Det er et grunnleggende tema du må forstå før du begynner å jobbe med Hadoop Ecosystem. Nedenfor er de viktige komponentene:

- HDFS: Dette er den sentrale delen av Hadoop økosystem og det kan spare en enorm mengde ustrukturert, strukturert og semistrukturert informasjon.

- Garn: Det ligner tankene til Hadoop-økosystemet, og all håndtering foregår direkte her, som kan inkludere aktivaallokering, planleggingsjobb og forberedelse av tiltak.

- MapReduce: Det er en blanding av to prosesser, beskrevet som Map and Reduce og består av essensiell forberedelse av deler som komponerer enorme informasjonssamlinger som bruker parallelle og spredte algoritmer i Hadoop-økosystemet.

- Apache Pig: Det er et språk i prosedyren, som brukes til parallellhåndtering av applikasjoner for å behandle enorme informasjonssamlinger i Hadoop-tilstand, og dette språket er et alternativ for Java-programmering.

- HBase: Det er en åpen kildekode og en ikke-tilknyttet database eller NoSQL-database. Det styrker alle informasjonstyper og kan dermed håndtere alle typer informasjon innenfor et Hadoop-rammeverk.

- Mahout, Spark MLib: Mahout brukes til maskinlæring og gir natur til å lage applikasjoner for maskinlæring.

- Zookeeper: For å takle gruppene kan man bruke Zookeeper, det kalles ellers koordineringsherren, som kan gi pålitelige, raske og sorterte driftsadministrasjoner for Hadoop-gruppene.

- Oozie: Apache Oozie driver arbeidsplanlegging og fungerer som en varsling og klokke-tjenester i Hadoop Ecosystem.

- Ambari: Det er et selskap av Apache Software Foundation og det kan utføre Hadoop-økosystemet gradvis fleksibelt.

Hadoop YARN:

Tenk på YARN som tankene til ditt Hadoop-økosystem. Den spiller ut hele behandlingsoperasjonene dine ved å tildele eiendeler og planleggingsoppgaver.

Den har to bemerkelsesverdige segmenter som er ResourceManager og NodeManager.

- ResourceManager: - Det er igjen en viktig node i driftsdivisjonen. Det blir de forberedende henvendelsene, og deretter overføres alle henvendelsene til henholdsvis NodeManagers, der den ekte håndteringen skjer.

- NodeManagers: - Disse er installert på hver DataNode. Det er ansvarlig for utførelsen av en oppgave på hver eneste DataNode.

Hvordan fungerer Apache Hadoop?

- Det er ment å stige opp fra individuelle servere til en enorm mengde maskiner, som hver gir lokal beregning og kapasitet. I stedet for å avhenge av utstyret for å formidle høy tilgjengelighet, er selve biblioteket ment å skille og takle skuffelser ved applikasjonssjiktet, så å formidle en overordentlig tilgjengelig tjeneste over en haug med PC-er, som alle kan være tilbøyelige til skuffelser.

- Se imidlertid lenger, og det er betydelig økende sjarm på jobben. Hadoop er helt modulbasert, noe som innebærer at du kan bytte ut praktisk talt alle segmentene for et alternativt programvareverktøy. Det gjør arkitekturen fantastisk tilpasningsdyktig, like kraftig og effektiv.

Apache Hadoop Spark:

- Apache Spark er et system for sanntidsinformasjonsanalyse i en spredt databehandlingsinnstilling. Den implementerer beregninger i minnet for å bygge hastigheten på informasjonshåndtering.

- Det er raskere å håndtere informasjon i stor skala, da den bruker beregninger i minnet og forskjellige forbedringer. Langs disse linjene krever det høy prosessorkraft.

Hvordan fungerer Apache Pig?

- Apache Pig er et gunstig system Yahoo ble utviklet for å undersøke enorme informasjonsposisjoner effektivt og smidig. Det gir litt informasjonsstrøm på språket Pig Latin som er forbedret, utvidbar og enkel å bruke.

- Den eksepsjonelle komponenten i griseprogrammer der deres sammensetning er tilgjengelig for betydelig parallellisering, noe som gjør dette enkelt mot å ta vare på betydelige informasjonssamlinger.

Pig Use Case:

- Den private helsetjenesterinformasjonen til en person er privat og burde ikke utleveres til andre mennesker. Disse dataene bør skjules for å opprettholde hemmelighold, men informasjonen om legetjenester er enorm til det punktet at erkjennelse og eksklusjon av individuell helseinformasjon er viktig. Apache Pig kan brukes under slike forhold til å gjenkjenne helsedata.

Konklusjon:

- Det er skissert å stige opp fra bare en server til en enorm mengde maskiner, som alle gir beregning og kapasitet i nærheten. Se imidlertid lenger, og det er mye stadig mer fortryllelse på jobb.

- Hadoop er helt modulbasert, noe som betyr at du praktisk talt kan bytte ut noen av delene for et alternativt programvareverktøy. Det gjør strukturen fantastisk tilpasningsdyktig, like kraftig og effektiv.

Anbefalte artikler

Dette har vært en guide til Apache Hadoop Ecosystem. Her har vi diskutert hva som er Apache Hadoop Ecosystem? oversikt over Hadoop-arkitektur og virkningen av Hadoop-økosystemet. Du kan også gå gjennom andre foreslåtte artikler for å lære mer -

- Hadoop økosystemkomponenter

- Slik installerer du Apache

- Apache gnisttrening

- Karriere i Hadoop