Introduksjon til Hadoop Framework

Før vi dypdykker oss inn i det tekniske rammeverket til Hadoop, vil vi starte med et enkelt eksempel.

Det er en gård som høster tomater og lagrer dem i et enkelt lagerområde, nå med den økende etterspørselen etter grønnsaker begynte gården å høste poteter, gulrøtter - med økende etterspørsel var det mangel på bønder, så de ansatt flere bønder. Etter en tid innså de at det var mangel i lagerområdet - så de fordelte grønnsakene i forskjellige lagringsområder. Når det gjelder henting av dataene, fungerer alle sammen med sin egen lagringsplass.

Så hvordan denne historien er relatert til big data?

Tidligere hadde vi begrensede data, med den begrensede prosessoren og en lagringsenhet. Men så økte generasjonen av data, noe som førte til stort volum og forskjellige varianter - strukturert, semistrukturert og ustrukturert. Så løsningen var å bruke distribuert lagring for hver prosessor, dette muliggjorde enkel tilgang til lagring og tilgang til data.

Så nå kan vi erstatte grønnsakene som forskjellige typer data og lagringsplass som de distribuerte stedene å lagre dataene og forskjellige arbeidere som er hver prosessor.

Så store data er utfordringen og Hadoop spiller en del av løsningen.

Hadoop

1. Løsning for STORE DATA: da den omhandler kompleksiteter med høyt volum, hastighet og mangfoldighet av data.

2. Sett med åpen kildekode-prosjekt.

3. Lagrer et stort datamengde pålitelig og tillater enorme distribuerte beregninger.

4. Hadoops viktigste attributter er redundans og pålitelighet (absolutt ikke noe tap av data).

5. Fokuserer primært på batchbehandling.

6. Kjører på maskinvare - du trenger ikke kjøpe noe spesielt dyrt maskinvare.

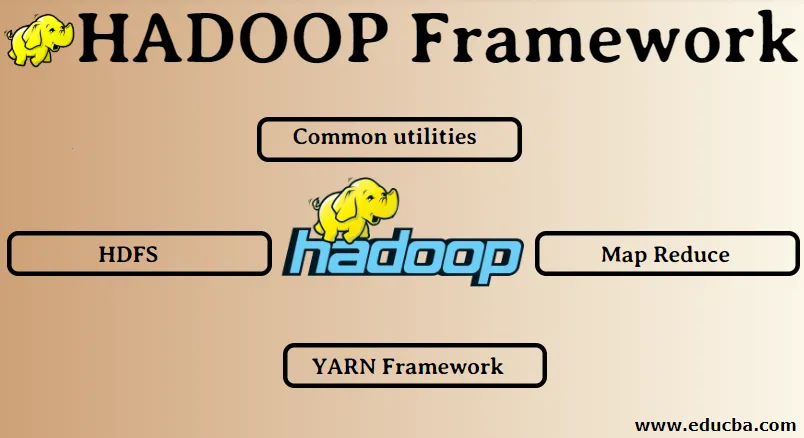

Hadoop Framework:

1. Felles verktøy

2. HDFS

3. Kart reduser

4. YARN Framework

1. Vanlige verktøy:

Også kalt Hadoop-vanlige. Dette er ikke annet enn JAVA-bibliotekene, filer, skript og verktøy som faktisk er påkrevd av de andre Hadoop-komponentene for å utføre.

2. HDFS: Hadoop Distribuert filsystem

Hvorfor Hadoop har valgt å innlemme et distribuert filsystem?

La oss forstå dette med et eksempel: Vi trenger å lese 1 TB data, og vi har en maskin med 4 I / O-kanaler hver kanal har 100 MB / s, det tok 45 minutter å lese hele dataene. Nå blir den samme datamengden lest av 10 maskiner hver med 4 I / O-kanaler hver kanal har 100 MB / s. Gjett hvor lang tid det tok å lese dataene? 4, 3 minutter. HDFS løser problemet med lagring av store data. De to hovedkomponentene til HDFS er NAME NODE og DATA NODE. Navneknute er masteren, vi kan også ha en sekundær navneknute i tilfelle den primære navneknuten slutter å fungere. Den sekundære navneknuten vil fungere som en sikkerhetskopi. Navneknuten vedlikeholder og administrerer i utgangspunktet datanodene ved å lagre metadata. Dataknuten er slaven som i utgangspunktet er den rimelige maskinvaren. Vi kan ha flere datanoder. Datanoden lagrer de faktiske dataene. Denne datanoden støtter replikasjonsfaktoren, antar at hvis den ene datanoden går ned, kan dataene nås av den andre repliserte datanoden, derfor blir tilgjengeligheten til data forbedret og tap av data forhindres.

3. Kart redusere:

Det løser problemet med å behandle big data. La oss forstå begrepet kartreduserer ved å løse dette virkelige problemet. ABC-selskapet ønsker å beregne det totale salget, bymessig. Nå her vil ikke hasjbordkonseptet fungere fordi dataene er i terabyte, så vi vil bruke Map-Reduce-konseptet.

Det er to faser: a) KART. b) REDUSER

a) Kart : Først deler vi dataene opp i mindre biter som kalles kartleggere på grunnlag av nøkkel / verdipar. Så her vil nøkkelen være bynavnet og verdien vil være totalt salg. Hver kartlegger vil få hver måned data som gir et bynavn og tilsvarende salg.

b) Reduser: Det vil få disse bunker med data, og hver redusering vil være ansvarlig for byer i nord / vest / øst / sør. Så arbeidet til reduksjonsutstyret vil samle disse små biter og konvertere til større mengder (ved å legge dem opp) for en bestemt by.

4.YARN Framework: Nok en ressursforhandler.

Den første versjonen av Hadoop hadde bare to komponenter: Map Reduce og HDFS. Senere ble det klar over at Map Reduce ikke kunne løse mange big data-problemer. Tanken var å ta ansvaret for ressursstyring og jobbplanlegging bort fra den gamle kartreduserende motoren og gi den til en ny komponent. Så dette var hvordan YARN kom inn i bildet. Det er mellomlaget mellom HDFS og Map Reduce som er ansvarlig for å håndtere klyngeressurser.

Det har to nøkkelroller å utføre: a) Jobbplanlegging. b) Ressursstyring

a) Jobbplanlegging: Når en stor mengde data gir til behandling, må den distribueres og deles inn i forskjellige oppgaver / jobber. Nå bestemmer JS hvilken jobb som skal prioriteres, tidsintervallet mellom to jobber, avhengighet mellom jobbene, kontrollerer at det ikke er noen overlapp mellom jobbene som kjører.

b) Ressursstyring: For behandling av dataene og for lagring av dataene trenger vi ressurser, ikke sant? Ressurssjefen skaffer, administrerer og vedlikeholder ressursene til å lagre og behandle dataene.

Så nå er vi klare på Hadoop-konseptet og hvordan det løser utfordringene som er skapt av STORE DATA !!!

Anbefalte artikler

Dette har vært en guide til Hadoop Framework. Her har vi også diskutert de 4 beste Hadoop-rammene. Du kan også gå gjennom andre foreslåtte artikler for å lære mer -

- Hadoop-databasen

- Hadoop økosystem

- Bruk av Hadoop

- Hadoop administratorjobber

- Hadoop Administrator | Ferdigheter og karrierevei