Introduksjon til kjernemetoder

Kerner eller kjernemetoder (også kalt Kernelfunksjoner) er sett med forskjellige typer algoritmer som blir brukt til mønsteranalyse. De brukes til å løse et ikke-lineært problem ved å bruke en lineær klassifiserer. Kernemetoder brukes i SVM (Support Vector Machines) som brukes i klassifiserings- og regresjonsproblemer. SVM bruker det som kalles "Kernel Trick" der dataene blir transformert og en optimal grense blir funnet for mulige utganger.

Behovet for kjernemetode og dens arbeid

Før vi begynner å bruke Kernel Methods, er det viktigere å forstå støttevektormaskiner eller SVM-er fordi kjerner implementeres i SVM-modeller. Så, Support Vector Machines er overvåket maskinlæringsalgoritmer som brukes i klassifiserings- og regresjonsproblemer, for eksempel å klassifisere et eple til klasse frukt mens de klassifiserer en løve til klassedyret.

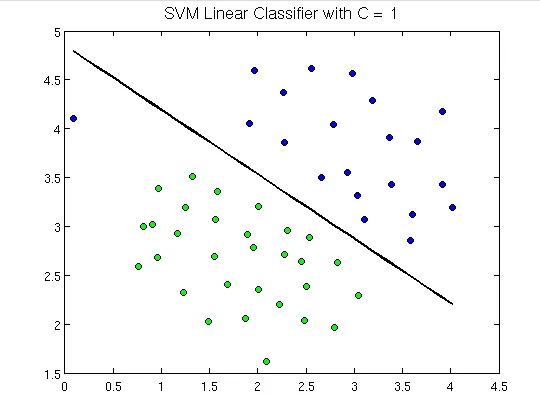

For å demonstrere er følgende hvordan støttevektormaskiner ser ut:

Her kan vi se et hyperplan som skiller grønne prikker fra de blå. Et hyperplan er en dimensjon mindre enn det omgivende plan. F.eks. I figuren over har vi 2 dimensjoner som representerer omgivelsesområdet, men den ensomme som deler eller klassifiserer rommet er en dimensjon mindre enn omgivelsesrommet og kalles hyperplan.

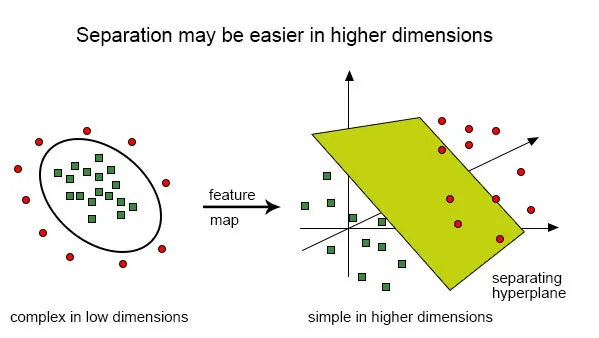

Men hva hvis vi har innspill som dette:

Det er veldig vanskelig å løse denne klassifiseringen ved å bruke en lineær klassifisering, da det ikke er noen god lineær linje som skal kunne klassifisere de røde og de grønne prikkene ettersom punktene er tilfeldig fordelt. Her kommer bruken av kjernefunksjon som tar poengene til høyere dimensjoner, løser problemet der borte og returnerer utdataene. Tenk på dette på denne måten, vi kan se at de grønne prikkene er innelukket i et eller annet omkretsområde mens den røde ligger utenfor den. På samme måte kan det være andre scenarier der grønne prikker kan være fordelt i et trapesformet område.

Så det vi gjør er å konvertere det todimensjonale planet som først ble klassifisert av endimensjonalt hyperplan (“eller en rett linje”) til det tredimensjonale området, og her vil klassifiseringen vår, dvs. hyperplan, ikke være en rett linje, men en to -dimensjonalt plan som vil kutte området.

For å få en matematisk forståelse av kjernen, la oss forstå Lili Jiangs ligning av kjernen som er:

K (x, y) = hvor,

K er kjernefunksjonen,

X og Y er dimensjonale innganger,

f er kartet fra n-dimensjonalt til m-dimensjonalt rom og,

er prikkproduktet.

Illustrasjon ved hjelp av et eksempel.

La oss si at vi har to poeng, x = (2, 3, 4) og y = (3, 4, 5)

Som vi har sett, er K (x, y) =.

La oss først beregne

f (x) = (x1x1, x1x2, x1x3, x2x1, x2x2, x2x3, x3x1, x3x2, x3x3)

f (y) = (y1y1, y1y2, y1y3, y2y1, y2y2, y2y3, y3y1, y3y2, y3y3)

så,

f (2, 3, 4) = (4, 6, 8, 6, 9, 12, 8, 12, 16) og

f (3, 4, 5) = (9, 12, 15, 12, 16, 20, 15, 20, 25)

så prikkproduktet,

f (x). f (y) = f (2, 3, 4). f (3, 4, 5) =

(36 + 72 + 120 + 72 +144 + 240 + 120 + 240 + 400) =

1444

Og,

K (x, y) = (2 * 3 + 3 * 4 + 4 * 5) 2 = (6 + 12 + 20) 2 = 38 * 38 = 1444.

Dette som vi finner ut, f (x) .f (y) og K (x, y) gir oss det samme resultatet, men den tidligere metoden krevde mange beregninger (på grunn av å projisere 3 dimensjoner i 9 dimensjoner) mens vi brukte kjernen, det var mye enklere.

Typer kjerne og metoder i SVM

La oss se noen av kjernefunksjonene eller typene som brukes i SVM:

1. Liner Kernel - La oss si at vi har to vektorer med navn x1 og Y1, da er den lineære kjernen definert av prikkproduktet til disse to vektorene:

K (x1, x2) = x1. x2

2. Polynomisk kjerne - En polynomkjerne er definert av følgende ligning:

K (x1, x2) = (x1. X2 + 1) d,

Hvor,

d er graden av polynomet og x1 og x2 er vektorer

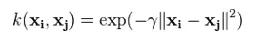

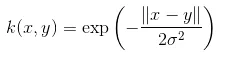

3. Gaussian Kernel - Denne kjernen er et eksempel på en radiell basisfunksjonskjerne. Nedenfor er ligningen for dette:

Den gitte sigmaen spiller en veldig viktig rolle i ytelsen til den Gaussiske kjernen, og bør verken overvurderes og heller ikke undervurderes, den skal være nøye avstemt i henhold til problemet.

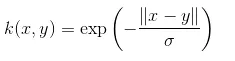

4. Eksponentiell kjerne - Dette er i nær sammenheng med den forrige kjernen, dvs. at den Gaussiske kjernen med den eneste forskjellen er - kvadratet til normen fjernes.

Funksjonen til eksponentiell funksjon er:

Dette er også en kjernefunksjon med radiell basis.

5. Laplacian Kernel - Denne typen kjerner er mindre utsatt for endringer og er helt lik tidligere diskutert eksponentiell funksjonskjerne, ligningen av Laplacian kernel er gitt som:

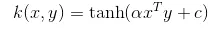

6. Hyperbolic eller Sigmoid Kernel - Denne kjernen brukes i nevrale nettverksområder for maskinlæring. Aktiveringsfunksjonen for sigmoidkjernen er den bipolare sigmoidfunksjonen. Ligningen for den hyperbolske kjernefunksjonen er:

Denne kjernen er veldig mye brukt og populær blant støttevektormaskiner.

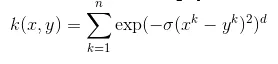

7. Anova radial basis-kjerne - Denne kjernen er kjent for å fungere veldig bra i flerdimensjonale regresjonsproblemer, akkurat som de gaussiske og laplaciske kjernene. Dette kommer også inn under kategorien radiell basiskjerne.

Ligningen for Anova-kjernen er:

Det er mange flere typer kernemetode, og vi har diskutert de mest brukte kjernene. Det avhenger rent av typen problem som vil avgjøre hvilken kjernefunksjon som skal brukes.

Konklusjon

I dette avsnittet har vi sett definisjonen av kjernen og hvordan den fungerer. Vi prøvde å forklare ved hjelp av diagrammer om bruken av kjerner. Vi har da prøvd å gi en enkel illustrasjon ved bruk av matte om kjernefunksjonen. I den siste delen har vi sett forskjellige typer kjernefunksjoner som er mye brukt i dag.

Anbefalte artikler

Dette er en guide til kjernemetoder. Her diskuterer vi en introduksjon, behov, dets arbeid og typer kjernemetoder med passende ligning. Du kan også gå gjennom andre foreslåtte artikler for å lære mer -

- Data mining algoritmer

- K- Betyr Clustering Algorithm

- Brute Force Algoritme

- Decision Tree Algoritm

- Kernemetoder i maskinlæring

- Decision Tree in Machine Learning