Introduksjon til bakover eliminering

Mens mennesker og maskiner banker mot digital evolusjon, er forskjellige teknikkmaskiner regnskapsmessig for å få seg ikke bare trent, men smart opplært til å komme ut med bedre anerkjennelse av gjenstander i den virkelige verden. En slik teknikk introdusert tidligere kalt “Backward Elimination” som hadde til hensikt å favorisere uunnværlige funksjoner mens de utrydder nugatoriske funksjoner for å hengi seg til bedre optimalisering i en maskin. Maskinens ferdighet til objektgjenkjenning står i forhold til hvilke funksjoner den vurderer.

Funksjoner som ikke har noen referanse til den forutsagte utgangen, må tømmes ut fra maskinen, og den avsluttes ved å eliminere bakover. God presisjon og tidskompleksitet for anerkjennelse av et ekte ordobjekt av maskin er avhengig av dets læring. Så bakover eliminere spiller sin stive rolle for valg av funksjoner. Den beregner frekvensen av avhengighet av funksjoner til den avhengige variabelen finner betydningen av dens tilhørighet i modellen. For å godkjenne dette, kontrollerer den den regnede renten med et standard betydningsnivå (si 0, 06) og tar en beslutning for valg av funksjon.

Hvorfor reduserer vi eliminering av bakover ?

Uønskede og overflødige egenskaper driver frem maskinens logikkens kompleksitet. Det sluker tid og modellens ressurser unødvendig. Så den ovennevnte teknikken spiller en kompetent rolle for å smi modellen til enkel. Algoritmen dyrker den beste versjonen av modellen ved å optimalisere ytelsen og avkutte de disponible utnevnte ressursene.

Den begrenser de minst bemerkelsesverdige egenskapene fra modellen som forårsaker støy i å bestemme regresjonslinjen. Irrelevante objekttrekk kan føre til feilklassifisering og prediksjon. Irrelevante trekk ved en enhet kan utgjøre en ubalanse i modellen med hensyn til andre viktige trekk ved andre objekter. Bakover eliminering fremmer passende montering av modellen. Derfor anbefales eliminering av bakover å bruke i en modell.

Hvordan søke bakover eliminering?

Bakover eliminering begynner med alle funksjonsvariabler, og tester den med den avhengige variabelen under en valgt montering av modellkriterium. Det begynner å utrydde de variablene som forverrer passningen av regresjon. Gjenta denne slettingen til modellen får god passform. Nedenfor er trinnene for å utøve den eliminering av bakover:

Trinn 1: Velg riktig nivå av betydning for å ligge i modellen til maskinen. (Ta S = 0, 06)

Trinn 2: Tapp alle tilgjengelige uavhengige variabler til modellen med hensyn til den avhengige variabelen og datamaskin hellingen og avskjær for å tegne en regresjonslinje eller passende linje.

Trinn 3: Gå gjennom alle de uavhengige variablene som har den høyeste verdien (Ta I) en etter en og fortsett med følgende toast: -

a) Hvis I> S, utfør fjerde trinn.

b) Ellers avbryter og modellen er perfekt.

Trinn 4: Fjern den valgte variabelen og øk krysset.

Trinn 5: Smi modellen på nytt og beregne helningen og avskjæringen av monteringslinjen igjen med restvariabler.

De ovennevnte trinn er oppsummert i avvisning av de trekkene som har en signifikanshastighet over den valgte signifikansverdien (0, 06) for å unngå overklassifisering og overutnyttelse av ressurser som ble observert som høy kompleksitet.

Fordeler og forfall ved tilbakestående eliminering

Her er noen fordeler og forfall for eliminering av bakover gitt i detalj:

1. Fordeler

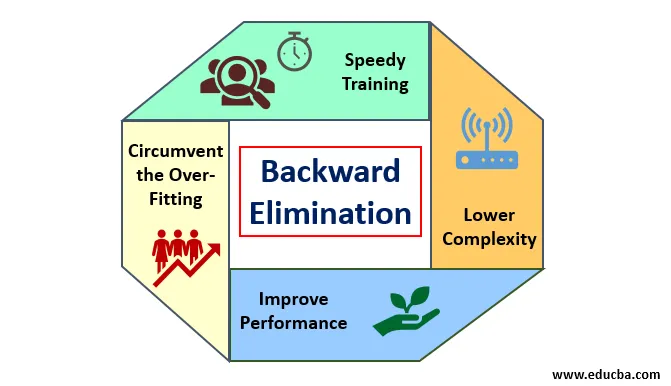

Fordelene med å eliminere bakover er som følger:

- Hurtig trening: Maskinen er trent med et sett tilgjengelige mønsterfunksjoner som gjøres på veldig kort tid hvis uvesentlige funksjoner fjernes fra modellen. Rask opplæring av datasett kommer inn i bildet bare når modellen har å gjøre med viktige funksjoner og ekskluderer alle støyvariablene. Det tegner en enkel kompleksitet for trening. Men modellen skal ikke gjennomgå undermontering som oppstår på grunn av manglende funksjoner eller mangelfulle prøver. Eksempelfunksjonen bør være rikelig i en modell for best klassifisering. Tiden som trengs for å trene modellen skal være mindre, mens klassifiseringsnøyaktigheten opprettholdes og uten variabel underforutsigelse.

- Nedre kompleksitet: Kompleksiteten til modellen blir tilfeldig høy hvis modellen tenker på omfanget av funksjoner, inkludert støy og ikke-relaterte funksjoner. Modellen bruker mye tid og tid på å behandle et slikt spenn av funksjoner. Dette kan øke hastigheten på nøyaktighet for mønstergjenkjenning, men frekvensen kan også inneholde støy. For å kvitte seg med en så høy kompleksitet av modellen, spiller den tilbakevendende eliminasjonsalgoritmen en nødvendig rolle ved å fjerne de uønskede funksjonene fra modellen. Det forenkler prosesseringslogikken til modellen. Bare noen få viktige funksjoner er gode for å få en god passform som tilfredsstiller rimelig nøyaktighet.

- Forbedre ytelsen: Modellytelsen er avhengig av mange aspekter. Modellen gjennomgår optimalisering ved å bruke bakover eliminering. Optimaliseringen av modellen er optimaliseringen av datasettet som brukes til å trene modellen. Modellens ytelse er direkte proporsjonal med optimaliseringshastigheten som er avhengig av frekvensen av betydelige data. Den bakover eliminasjonsprosessen er ikke ment å starte endring fra noen lavfrekvens predikator. Men det starter bare endring fra høyfrekvente data, fordi det meste er modellens kompleksitet avhengig av den delen.

- Omgå overflødig montering: Den altfor passende situasjonen oppstår når modellen fikk for mange datasett og klassifisering eller prediksjon er utført der noen predikatorer fikk støy fra andre klasser. I denne tilpasningen antok modellen å gi uventet høy nøyaktighet. Ved overdreven montering kan det hende at modellen ikke klarer å klassifisere variabelen på grunn av forvirring opprettet i logikk på grunn av for mange forhold. Den bakover elimineringsteknikken begrenser det fremmede trekket for å omgå situasjonen med overdreven montering.

2. Fisjoner

Begrensninger for eliminering av bakover er som følger:

- I den tilbakevendende eliminasjonsmetoden kan man ikke finne ut hvilken predikator som er ansvarlig for avvisning av en annen predikator på grunn av dens rekkevidde til ubetydelighet. For eksempel, hvis predikator X har en viss betydning som var god nok til å oppholde seg i en modell etter å ha lagt Y-predikatoren. Men betydningen av X blir utdatert når en annen predikator Z kommer inn i modellen. Så den tilbakevendende eliminasjonsalgoritmen viser ikke noe om avhengighet mellom to prediktorer som skjer i “Fremovervalgsteknikken”.

- Etter å ha kassert en funksjon fra en modell av en bakover eliminasjonsalgoritme, kan ikke denne funksjonen velges igjen. Kort sagt, eliminering av bakover har ikke en fleksibel tilnærming for å legge til eller fjerne funksjoner / prediktorer.

- Normene for å velge signifikansverdien (0, 06) i modellen er ufleksible. Bakover eliminering har ikke en fleksibel prosedyre for ikke bare å velge, men også endre den ubetydelige verdien som kreves for å hente best mulig passform under et tilstrekkelig datasett.

Konklusjon

Backward elimineringsteknikken ble klar over å forbedre modellens ytelse og optimalisere kompleksiteten. Den brukes levende i flere regresjoner der modellen tar for seg det omfattende datasettet. Det er en enkel og enkel tilnærming sammenlignet med valg av fremover og kryssvalidering der overbelastning av optimalisering oppstod. Den bakover eliminerteknikken initierer eliminering av funksjoner med høyere betydning. Dets grunnleggende mål er å gjøre modellen mindre kompleks og forby altfor passende situasjon.

Anbefalte artikler

Dette er en guide til bakover eliminering. Her diskuterer vi hvordan du kan bruke baklengs eliminering sammen med fordeler og undergang. Du kan også se på følgende artikler for å lære mer-

- Hyperparameter maskinlæring

- Clustering in Machine Learning

- Java Virtual Machine

- Uovervåket maskinlæring