Oversikt over lineær regresjonsmodellering

Når du begynner å lære om maskinlæringsalgoritmer, begynner du å lære om forskjellige måter å ML-algoritmer, dvs. veiledet, uten tilsyn, halvkontroll og forsterkning. I denne artikkelen har vi å gjøre med veiledet læring og en av de grunnleggende, men kraftige algoritmene: Lineær regresjon.

Derfor er veiledet læring læringen der vi trener maskinen til å forstå forholdet mellom inngangs- og utgangsverdiene som er gitt i treningsdatasettet, og deretter bruke den samme modellen til å forutsi utgangsverdiene for testdatasettet. Så hvis vi har utdataene eller merkingen som allerede er gitt i treningsdatasettet vårt, og vi er sikre på at utdataene gir mening som tilsvarer inndataene, bruker vi Supervised Learning. Veiledede læringsalgoritmer er klassifisert i Regresjon og klassifisering.

Regresjonsalgoritmer brukes når du merker at output er en kontinuerlig variabel, mens klassifiseringsalgoritmer brukes når output er delt inn i seksjoner som Pass / Fail, Good / Average / Bad, etc. Vi har forskjellige algoritmer for å utføre regresjonen eller klassifiseringen handlinger med lineær regresjonsalgoritme som den grunnleggende algoritmen i regresjon.

Når jeg kommer til denne regresjonen, før jeg går inn i algoritmen, la meg sette basen for deg. På skolegang håper jeg du husker linjeligningskonseptet. La meg gi en kort beskrivelse av det. Du fikk to poeng på XY-plan, dvs. si (x1, y1) og (x2, y2), der y1 er utgangen til x1 og y2 er utgangen til x2, så er linjelikningen som går gjennom punktene (y- y1) = m (x-x1) hvor m er linjens helning. Etter å ha funnet linjen ligningen, hvis du får et poeng si (x3, y3), ville du lett kunne forutsi om punktet ligger på linjen eller avstanden til punktet fra linjen. Dette var den grunnleggende regresjonen som jeg hadde gjort på skolegangen uten å engang innse at dette ville ha så stor betydning i maskinlæring. Det vi vanligvis gjør i dette er, prøv å identifisere ligningslinjen eller kurven som kan passe inngangen og utgangen til togsdatasettet riktig, og bruk deretter den samme ligningen for å forutsi utgangsverdien til testdatasettet. Dette vil resultere i en kontinuerlig ønsket verdi.

Definisjon av lineær regresjon

Lineær regresjon har faktisk eksistert i veldig lang tid (rundt 200 år). Det er en lineær modell, dvs. at den forutsetter et lineært forhold mellom inngangsvariablene (x) og en enkelt utgangsvariabel (y). Y her beregnes av den lineære kombinasjonen av inngangsvariablene.

Vi har to typer lineær regresjon

Enkel lineær regresjon

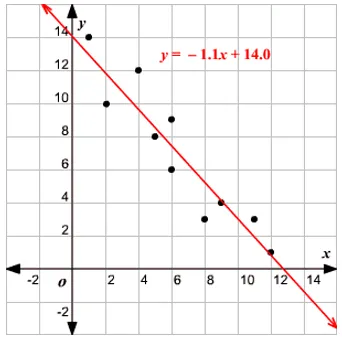

Når det er en enkelt inngangsvariabel, dvs. linje ligning er c

betraktet som y = mx + c, så er det Simple Linear Regression.

Flere lineære regresjoner

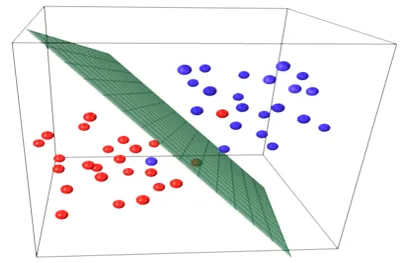

Når det er flere inndatavariabler, dvs. at linjeforligning regnes som y = aks 1 + bx 2 + … nx n, så er det Multiple Lineær regresjon. Ulike teknikker brukes til å forberede eller trene regresjonsligningen fra data, og den vanligste blant dem kalles Ordinary Least Squares. Modellen som er bygd med den nevnte metoden, blir referert til som Ordinary Least Squares Linear Regression eller bare Least Squares Regression. Modell brukes når inngangsverdiene og utgangsverdien som skal bestemmes er numeriske verdier. Når det bare er én inngang og en utgang, er den dannede ligningen en linje ligning, dvs.

y = B0x+B1

hvor koeffisientene for linjen skal bestemmes ved bruk av statistiske metoder.

Enkle lineære regresjonsmodeller er svært sjeldne i ML fordi vi generelt vil ha forskjellige innsatsfaktorer for å bestemme resultatet. Når det er flere inngangsverdier og en utgangsverdi, er ligningen dannet den for et plan eller hyperplan.

y = ax 1 +bx 2 +…nx n

Kjerneideen i regresjonsmodellen er å skaffe en linje ligning som best passer dataene. Den beste passformlinjen er den der den totale prediksjonsfeilen for alle datapunktene anses som liten som mulig. Feilen er avstanden mellom punktet på flyet til regresjonslinjen.

Eksempel

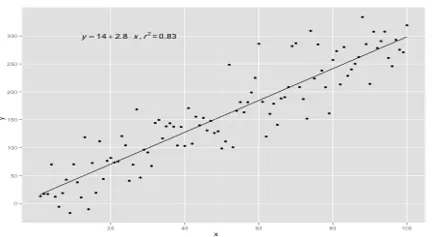

La oss starte med et eksempel på enkel lineær regresjon.

Forholdet mellom høyden og vekten til en person er direkte proporsjonal. En studie er blitt utført på frivillige for å bestemme høyden og idealvekten til personen og verdiene er blitt registrert. Dette vil bli betraktet som vårt treningsdatasett. Ved å bruke treningsdataene beregnes en regresjonslinjeligning som vil gi en minimum feil. Denne lineære ligningen blir deretter brukt til å lage forutsigelser om nye data. Det vil si at hvis vi gir høyden til personen, bør den tilsvarende vekten forutsettes av modellen utviklet av oss med minimum eller null feil.

Y(pred) = b0 + b1*x

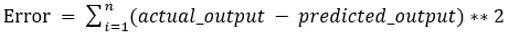

Verdiene b0 og b1 må velges slik at de minimerer feilen. Hvis summen av kvadratisk feil blir tatt som en beregning for å evaluere modellen, er målet å få en linje som best reduserer feilen.

Vi kvadrerer feilen slik at positive og negative verdier ikke vil avbryte hverandre. For modell med en prediktor:

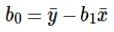

Beregning av avskjæring (b0) i linjen ligningen gjøres ved:

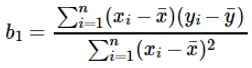

Beregning av koeffisienten for inngangsverdien x gjøres ved:

Forstå koeffisienten b 1 :

- Hvis b 1 > 0, er x (input) og y (output) direkte proporsjonale. Det vil si en økning i x vil øke y slik som høyde øker, vekt øker.

- Hvis b 1 <0, er x (prediktor) og y (mål) omvendt proporsjonal. Det vil si at økningen i x vil redusere y, for eksempel hastigheten på et kjøretøy øke, tiden blir redusert.

Forstå koeffisienten b 0 :

- B 0 tar opp restverdien for modellen og sikrer at prediksjonen ikke er partisk. Hvis vi ikke har B 0- sikt, blir linjeforlikningen (y = B 1 x) tvunget til å passere gjennom opprinnelse, dvs. inngangs- og utgangsverdiene som er lagt inn i modellresultatet i 0. Men dette vil aldri være tilfelle, hvis vi har 0 i inndata, vil B 0 være gjennomsnittet av alle forutsagte verdier når x = 0. Å sette alle prediktorverdiene til 0 i tilfelle x = 0 vil resultere i datatap og er ofte umulig.

Bortsett fra koeffisientene nevnt over, kan denne modellen også beregnes ved å bruke normale ligninger. Jeg vil diskutere videre bruken av normale ligninger og designe en enkel / multilinær regresjonsmodell i min kommende artikkel.

Anbefalte artikler

Dette er en guide til Lineær regresjonsmodellering. Her diskuterer vi definisjonen, typer lineær regresjon som inkluderer enkel og multippel lineær regresjon sammen med noen eksempler. Du kan også se på følgende artikler for å lære mer–

- Lineær regresjon i R

- Lineær regresjon i Excel

- Prediktiv modellering

- Hvordan lage GLM i R?

- Sammenligning av lineær regresjon vs logistisk regresjon