Oversikt over tapsfunksjoner i maskinlæring

Akkurat som lærere veileder oss, enten vi presterer bra eller ikke i våre akademikere, gjør tapfunksjonene det samme arbeidet. Det er en metode for å evaluere hvor godt algoritmen vår modellerer dataene. Tapsfunksjoner er den viktigste kilden til evaluering i moderne maskinlæring. Når du endrer algoritmen din for å forbedre modellen din, vil tapsfunksjonsverdien fortelle deg om du gjør et fremskritt eller ikke. Vårt primære mål bør være å redusere tapsfunksjonen ved å optimalisere. I denne artikkelen skal vi diskutere hvordan tapsfunksjoner fungerer og forskjellige typer tapsfunksjoner.

Hvordan fungerer tapsfunksjoner?

Ordet 'Tap' angir straffen for å ikke oppnå den forventede produksjonen. Hvis avviket i den forutsagte verdien enn forventet verdi av vår modell er stort, gir tapsfunksjonen det høyere antallet som output, og hvis avviket er lite og mye nærmere den forventede verdien, gir den ut mindre antall.

Her er et eksempel når vi prøver å forutsi huset salgspris i metro byer.

| spådde

Salgspris (In lakh) | Faktiske

Salgspris (In lakh) | Avvik (tap) |

| Bangalore: 45 | 0 (Alle spådommer er riktige) | |

| Pune: 35 | ||

| Chennai: 40 | ||

| Bangalore: 40 | Bangalore: 45 | 5 lakh for Bangalore, 2 lakh for Chennai |

| Pune: 35 | Pune: 35 | |

| Chennai: 38 | Chennai: 40 | |

| Bangalore: 43 | 2 lakh for Bangalore, 5 lakh for, Pune2 lakh for Chennai, | |

| Pune: 30 | ||

| Chennai: 45 |

Det er viktig å merke seg at mengden avvik ikke spiller noen rolle, det som betyr noe her, er om verdien som er forutsagt av vår modell er riktig eller feil. Tapfunksjoner er forskjellige basert på problemstillingen din som maskinlæring blir brukt til. Kostnadsfunksjonen er et annet begrep, som brukes om hverandre for tapsfunksjonen, men den har en litt annen betydning. En tapsfunksjon er for et enkelt treningseksempel mens kostnadsfunksjon er det gjennomsnittlige tapet over det komplette togdatasettet.

Typer av tapsfunksjoner i maskinlæring

Nedenfor er de forskjellige typer tapsfunksjon i maskinlæring som er som følger:

1) Funksjoner for regresjonstap:

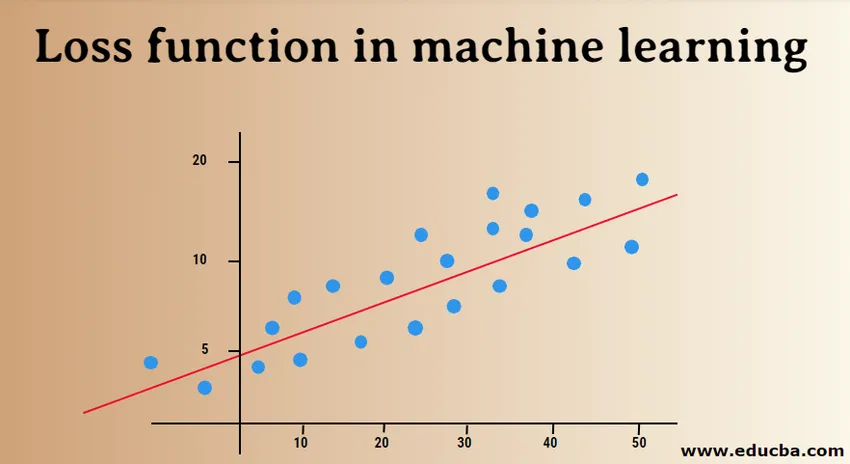

Lineær regresjon er et grunnleggende konsept for denne funksjonen. Regresjonstapfunksjoner etablerer et lineært forhold mellom en avhengig variabel (Y) og uavhengig variabel (X), og derfor prøver vi å passe den beste linjen i rommet på disse variablene.

Y = X0 + X1 + X2 + X3 + X4 …. + Xn

X = Uavhengige variabler

Y = Avhengig variabel

- Gjennomsnittlig firkantet feiltap:

MSE (L2-feil) måler den gjennomsnittlige kvadratforskjellen mellom de faktiske og forutsagte verdiene av modellen. Utgangen er et enkelt tall assosiert med et sett med verdier. Målet vårt er å redusere MSE for å forbedre nøyaktigheten til modellen.

Tenk på den lineære ligningen, y = mx + c, vi kan utlede MSE som:

MSE = 1 / N ∑i = 1 til n (y (i) - (mx (i) + b)) 2

Her er N det totale antall datapunkter, 1 / N ∑i = 1 til n er middelverdi og y (i) er den faktiske verdien og mx (i) + b dens forutsagte verdi.

- Gjennomsnittlig firkantet logaritmisk feiltap (MSLE):

MSLE måler forholdet mellom faktisk og spådd verdi. Det introduserer en asymmetri i feilkurven. MSLE bryr seg bare om prosentvis forskjell av faktiske og forutsagte verdier. Det kan være et godt valg som tapsfunksjon, når vi ønsker å forutsi hussalgspriser, salgssalgspriser for bakerier og dataene er kontinuerlige.

Her kan tapet beregnes som gjennomsnittet av observerte data for de kvadratiske forskjellene mellom de logtransformerte faktiske og forutsagte verdiene, som kan gis som:

L = 1nnΣi = 1 (log (y (i) 1) -log (y (i) 1)) 2

- Gjennomsnittlig absolutt feil (MAE):

MAE beregner summen av absolutte forskjeller mellom faktiske og forutsagte variabler. Det betyr at den måler den gjennomsnittlige størrelsen på feil i et sett med forutsagte verdier. Å bruke den gjennomsnittlige kvadratfeilen er enklere å løse, men å bruke den absolutte feilen er mer robust for utligere. Outliers er disse verdiene, som avviker ekstremt fra andre observerte datapunkter.

MAE kan beregnes som:

L = 1nnΣi = 1||y (i) - y (i) ||

2) Binære klassifiseringstapfunksjoner:

Disse tapsfunksjonene er laget for å måle resultatene til klassifiseringsmodellen. I dette tilordnes datapunkter en av etikettene, dvs. enten 0 eller 1. Videre kan de klassifiseres som:

- Binær krysantropi

Det er en standardtapfunksjon for binære klassifiseringsproblemer. Tverr-entropitap beregner ytelsen til en klassifiseringsmodell som gir en utgang med en sannsynlighetsverdi mellom 0 og 1. Tverr-entropitap øker når den forutsagte sannsynlighetsverdien avviker fra den faktiske etiketten.

- Hengsletap

Hengsletap kan brukes som et alternativ til tverr-entropi, som opprinnelig ble utviklet for bruk med en bærervector-maskinalgoritme. Hengsletap fungerer best med klassifiseringsproblemer fordi målverdiene er i settet (-1, 1). Det gjør det mulig å tilordne mer feil når det er forskjell i tegn mellom faktiske og forutsagte verdier. Dermed resulterer i bedre ytelse enn kryssentropi.

- Squared Hinge tap

En utvidelse av hengsletapet, som ganske enkelt beregner kvadratet for hengsletapet. Det reduserer feilfunksjonen og gjør det numerisk lettere å jobbe med. Den finner klassifiseringsgrensen som spesifiserer maksimalmargin mellom datapunktene til forskjellige klasser. Tapet i hengslet passer perfekt for JA ELLER INGEN slags beslutningsproblemer, der sannsynlighetsavvik ikke er bekymringen.

3) Multiklasse klassifiseringstapfunksjoner:

Multiklasse klassifisering er de prediktive modellene der datapunktene er tildelt til mer enn to klasser. Hver klasse tildeles en unik verdi fra 0 til (Number_of_classes - 1). Det anbefales på det sterkeste for problemer med bilde- eller tekstklassifisering, der enkeltpapir kan ha flere emner.

- Flerklassig kryssantropi

I dette tilfellet er målverdiene i settet 0 til n dvs. (0, 1, 2, 3 … n). Den beregner en poengsum som tar en gjennomsnittlig forskjell mellom faktiske og forutsagte sannsynlighetsverdier, og poengsummen er minimert for å oppnå best mulig nøyaktighet. Multiklasse kryssentropi er standard tapfunksjonen for tekstklassifiseringsproblemer.

- Sparsom multiklasse Cross-Entropy

En varm kodingsprosess gjør multiklasse kryssentropi vanskelig å håndtere et stort antall datapunkter. Sparsom kryssentropi løser dette problemet ved å utføre feilberegningen uten å bruke en varm koding.

- Kullback Leibler Divergens Tap

KL divergenstap beregner divergensen mellom sannsynlighetsfordeling og baselinefordeling og finner ut hvor mye informasjon som går tapt når det gjelder biter. Utgangen er en ikke-negativ verdi som spesifiserer hvor nær to sannsynlighetsfordelinger er. For å beskrive KL-divergens når det gjelder sannsynlighetssyn, brukes sannsynlighetsgraden.

I denne artikkelen forsto vi innledningsvis hvordan tapsfunksjoner fungerer, og så fortsatte vi å utforske en omfattende liste over tapsfunksjoner med brukte caseeksempler. Imidlertid er det mer fordelaktig å forstå det praktisk, så prøv å lese mer og implementere det. Det vil avklare tvilen grundig.

Anbefalte artikler

Dette er en guide til tapfunksjoner i maskinlæring. Her diskuterer vi hvordan fungerer tapsfunksjoner og typene tapsfunksjoner i maskinlæring. Du kan også se på følgende artikler for å lære mer -

- Læringsmetoder for maskiner

- Introduksjon til maskinlæring

- Big Data Technologies

- Big Data Analytics-programvare

- Lær Catogories of Hyperparameter

- Maskinlæring livssyklus | Topp 8 trinn