Introduksjon til Begrenset Boltzmann-maskin

Begrenset Boltzmann-maskin er en metode som automatisk kan finne mønstre i data ved å rekonstruere innspillene våre. Geoff Hinton er grunnleggeren av dyp læring. RBM er et overfladisk to-lags nettverk der det første er det synlige og det neste er det skjulte laget. Hver enkelt node i det synlige laget kobles til hver enkelt node i det skjulte laget. Begrenset Boltzmann-maskin anses som begrenset fordi to noder av samme lag ikke danner en forbindelse. En RBM er den numeriske ekvivalenten til toveisoversetter. I fremadstien mottar en RBM inngangen og konverterer den til et sett med tall som koder inngangen. I baklengs vei tar det dette som et resultat og behandler dette settet med innganger og oversetter dem omvendt for å danne de tilbaketrukne inngangene. Et supertrent nettverk vil kunne utføre denne omvendte overgangen med høy sannhet. I to trinn har vekt og verdier en veldig viktig rolle. De tillater RBM å avkode sammenhengen mellom inngangene og hjelper også RBM med å bestemme hvilke inngangsverdier som er viktigst for å oppdage de riktige utgangene.

Arbeider med begrenset Boltzmann-maskin

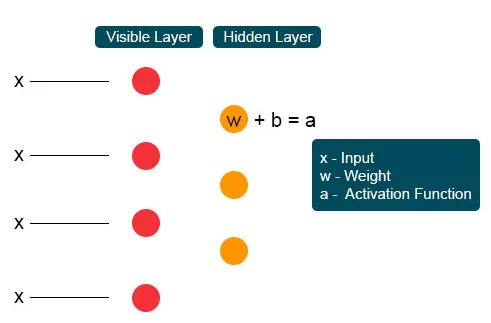

Hver synlige node mottar en lavnivåverdi fra en node i datasettet. Ved den første noden til det usynlige laget dannes X av et produkt av vekt og tilsettes en skjevhet. Utfallet av denne prosessen føres til aktivering som produserer kraften til det gitte inngangssignalet eller nodens utgang.

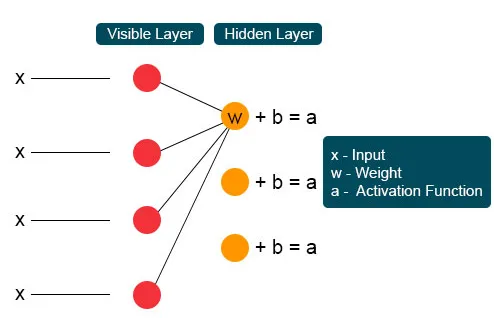

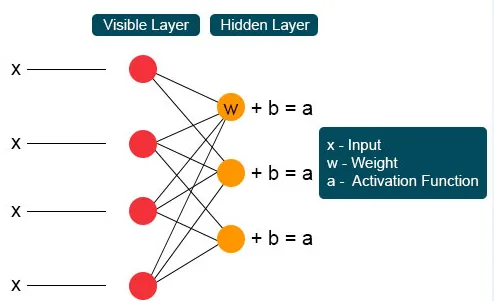

I den neste prosessen ville flere innganger bli med på en enkelt skjult node. Hvert X er kombinert av den individuelle vekten, tilsetningen av produktet blir lagt inn i verdier, og resultatet blir igjen ført gjennom aktivering for å gi noden ytelse. Ved hver usynlig node blir hver inngang X kombinert av individuell vekt W. Inngang X har tre vekter her, og utgjør tolv sammen. Vekten som er dannet mellom laget blir en matrise der rader er nøyaktige for å legge inn noder og kolonnene er fornøyde med utgangsnoder.

Hver usynlige node får fire svar multiplisert med vekten. Tilsetningen av denne effekten blir igjen lagt til verdien. Dette fungerer som en katalysator for at en eller annen aktiveringsprosess kan skje, og resultatet blir igjen matet til aktiveringsalgoritmen som produserer hver eneste utgang for hver eneste usynlige inngang.

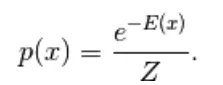

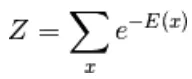

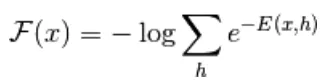

Den første modellen som er avledet her, er den energibaserte modellen. Denne modellen knytter skalærenergi til hver konfigurasjon av variabelen. Denne modellen definerer sannsynlighetsfordelingen gjennom en energifunksjon som følger,

(1)

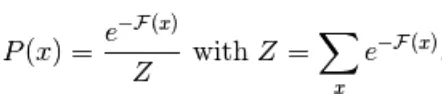

Her er Z den normaliserende faktoren. Det er partisjonsfunksjonen når det gjelder fysiske systemer

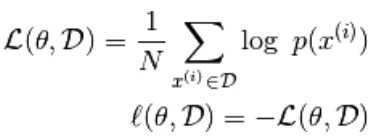

I denne energibaserte funksjonen følger en logistisk regresjon om at det første trinnet vil definere loggen. sannsynlighet og den neste vil definere tapsfunksjon som en negativ sannsynlighet.

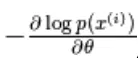

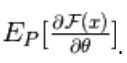

ved hjelp av den stokastiske gradienten,  hvor

hvor  er parametrene,

er parametrene,

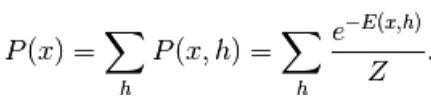

den energibaserte modellen med en skjult enhet er definert som 'h'

Den observerte delen er betegnet som 'x'

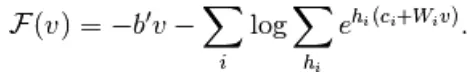

Fra ligning (1) er likningen av fri energi F (x) definert som følger

(2)

(3)

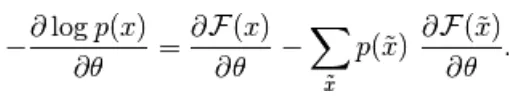

Den negative gradienten har følgende form,

(4)

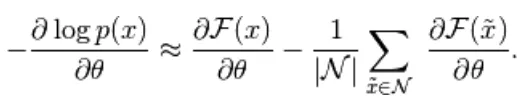

Ligningen ovenfor har to former, den positive og negative formen. Begrepet positiv og negativ er ikke representert av tegn på ligningene. De viser effekten av sannsynlighetstettheten. Den første delen viser sannsynligheten for å redusere den tilsvarende frie energien. Den andre delen viser reduserer sannsynligheten for genererte prøver. Deretter bestemmes gradienten som følger,

(5)

Her er N negative partikler. I denne energibaserte modellen er det vanskelig å identifisere gradienten analytisk, da den inkluderer beregningen av

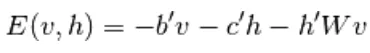

I denne EBM-modellen har vi derfor lineær observasjon som ikke er i stand til å skildre dataene nøyaktig. Så i den neste modellen Restricted Boltzmann Machine, er det skjulte laget mer for å ha høy nøyaktighet og forhindre datatap. RBM-energifunksjonen er definert som,

(6)

Her er W vektforbindelse mellom synlige og skjulte lag. b er forskjøvet av det synlige laget. c er forskjøvet av det skjulte laget. ved å konvertere til fri energi,

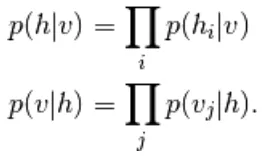

I RBM er enhetene til det synlige og skjulte laget helt uavhengige som kan skrives som følger,

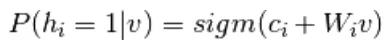

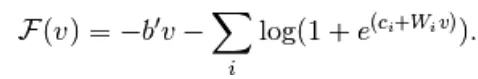

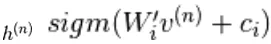

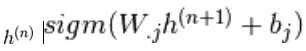

Fra ligning 6 og 2, en sannsynlig versjon av nevronaktiveringsfunksjon,

(7)

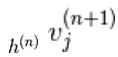

(8)

Det forenkles videre til

(9)

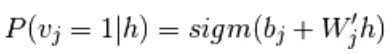

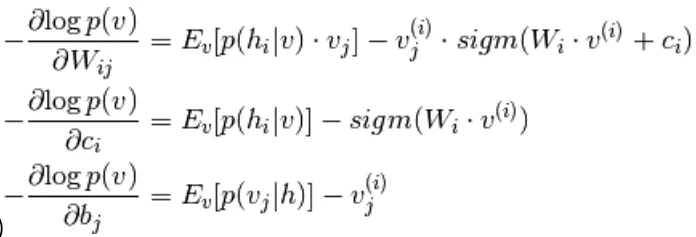

Ved å kombinere ligning 5 og 9,

(10)

Prøvetaking i begrenset Boltzmann-maskin

Gibbs-sampling av leddet av N tilfeldige variabler  gjøres gjennom en sekvens av N-prøvetaking undertrinn på skjemaet

gjøres gjennom en sekvens av N-prøvetaking undertrinn på skjemaet  hvor

hvor

inneholder  de andre tilfeldige variablene i

de andre tilfeldige variablene i  unntatt.

unntatt.

I RBM er S et sett med synlige og skjulte enheter. De to delene er uavhengige som kan utføre eller blokkere Gibbs-prøvetaking. Her utfører synlig enhet sampling og gir fast verdi til skjulte enheter, samtidig skjulte enheter ga faste verdier til den synlige enheten ved sampling

her,  er satt av alle skjulte enheter.

er satt av alle skjulte enheter.  Et eksempel

Et eksempel  er tilfeldig valgt til å være 1 (mot 0) med sannsynlighet,

er tilfeldig valgt til å være 1 (mot 0) med sannsynlighet,  og på samme måte,

og på samme måte,  er tilfeldig valgt til å være 1 (mot 0) med sannsynlighet

er tilfeldig valgt til å være 1 (mot 0) med sannsynlighet

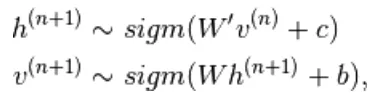

Kontrastiv divergens

Den brukes som katalysator for å fremskynde prøvetakingsprosessen

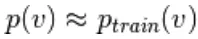

Siden vi forventer å være sanne, forventer vi  fordelingsverdien for å være nær P slik at den danner en konvergens til den endelige fordelingen av P

fordelingsverdien for å være nær P slik at den danner en konvergens til den endelige fordelingen av P

Men kontrastiv avvik venter ikke på at kjeden skal konvergere. Prøve oppnås først etter Gibbs prosess, så vi setter her k = 1 der det fungerer overraskende bra.

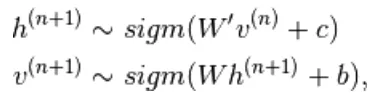

Vedvarende kontrastiv divergens

Dette er en annen metode for tilnærming av prøvetakingsform. Det er en vedvarende tilstand for hver prøvetakingsmetode den henter ut nye prøver ved ganske enkelt å endre parameterne til K.

Lag av begrenset Boltzmann-maskin

Begrenset Boltzmann-maskin har to lag, grunne nevrale nettverk som kombineres for å danne en blokk med dyp tro-nettverk. Det første laget er det synlige laget, og det andre laget er det skjulte laget. Hver enhet refererer til en nevronlignende sirkel kalt en node. Knutepunktene fra det skjulte laget er koblet til noder fra det synlige laget. Men to noder med samme lag er ikke koblet sammen. Her refererer begrepet Begrenset til ingen intralaykommunikasjon. Hver node behandler inngangen og tar den stokastiske avgjørelsen om sendingen skal sendes eller ikke.

eksempler

Den viktige rollen til RBM er en sannsynlighetsfordeling. Språk er unike i bokstavene og lydene. Sannsynlighetsfordelingen av brevet kan være høy eller lav. På engelsk er bokstavene T, E og A mye brukt. Men på islandsk er de vanlige bokstavene A og N. Vi kan ikke prøve å rekonstruere islandsk med en vekt basert på engelsk. Det vil føre til divergens.

Neste eksempel er bilder. Sannsynlighetsfordelingen for deres pikselverdi er forskjellig for hver type bilde. Vi kan vurdere at det er to bilder Elephant and Dog for tow input nodes, fremoverpasset til RBM vil generere spørsmål som skal jeg generere en sterk pikselnode for elefantnode eller hundenode ?. Da vil bakoverpass generere spørsmål som for elefant, hvordan kan jeg forvente en fordeling av piksler? Deretter med leddsannsynlighet og aktivering produsert av noder, vil de konstruere et nettverk med felles forekomst som store ører, grått ikke-lineært rør, floppy ører, rynke er elefanten. Derfor er RBM prosessen med dyp læring og visualisering de danner to store skjevheter og virker på deres aktiverings- og gjenoppbyggingssans.

Fordeler med Begrenset Boltzmann-maskin

- Begrenset Boltzmann-maskin er brukt algoritme som brukes til klassifisering, regresjon, emnemodellering, samarbeidsfiltrering og funksjonslæring.

- Begrenset Boltzmann-maskin brukes til nevroavbildning, sparsom bildekonstruksjon i gruveplanlegging og også til radarmålgjenkjenning

- RBM kan løse ubalansert dataproblem etter SMOTE prosedyre

- RBM finner manglende verdier ved Gibbs sampling som brukes for å dekke de ukjente verdiene

- RBM overvinner problemet med bråkete etiketter ved å korrigere etikettdata og gjenoppbyggingsfeil

- Ustrukturerte data problemet blir utbedret av funksjonsekstraktor som transformerer rå data til skjulte enheter.

Konklusjon

Dyp læring er veldig kraftig som er kunsten å løse komplekse problemer, det er fremdeles et rom for forbedring og komplekst å implementere. Gratis variabler må konfigureres med omhu. Ideene bak det nevrale nettverket var vanskelige tidligere, men i dag er dyp læring foten for maskinlæring og kunstig intelligens. RBM gir derfor et glimt av de enorme dype læringsalgoritmene. Den tar for seg den grunnleggende komposisjonsenheten som gradvis vokste til mange populære arkitekturer og brukes mye i mange store industrier.

Anbefalt artikkel

Dette har vært en guide til den begrensede Boltzmann-maskinen. Her diskuterer vi dets arbeid, prøvetaking, fordeler og lag av begrenset Boltzmann-maskin. Du kan også gå gjennom andre foreslåtte artikler for å lære mer _

- Maskinlæringsalgoritmer

- Maskinlæringsarkitektur

- Typer maskinlæring

- Machine Learning Tools

- Implementering av nevrale nettverk