Introduksjon til autoencodere

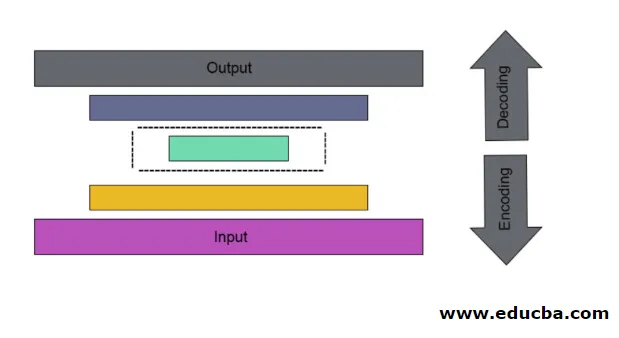

Det er tilfellet med kunstig nevralt nett som brukes til å oppdage effektiv datakoding på en uovervåket måte. Målet med Autoencoder brukes til å lære presentasjon for en gruppe av data spesielt for dimensjonalitet nedtrapping. Autoencodere har en unik funksjon der inndata er lik utgangen ved å danne fremføringsnettverk. Autoencoder forvandler inngangen til komprimerte data for å danne en lav dimensjonal kode og deretter spole inngangen igjen for å danne den ønskede utgangen. Den komprimerte inngangskoden kalles også latent romrepresentasjon. Enkelt sagt er hovedmålet å redusere forvrengning mellom kretsløp.

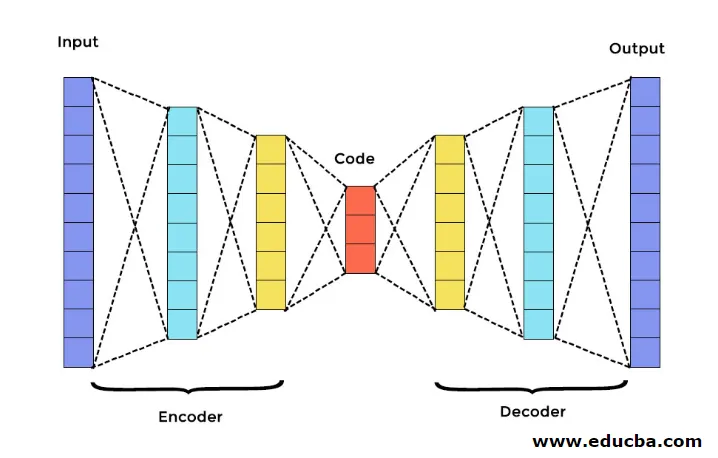

Det er tre hovedkomponenter i Autoencoder. De er kodere, dekoder og kode. Koderen og dekoderen er helt tilkoblet for å danne et fremføringsnett. Koden fungerer som et enkelt lag som fungerer som per egen dimensjon. For å utvikle en Autoencoder, må du angi et hyperparameter, som du må angi antall noder i kjernelaget. På en mer detaljert måte er utgangsnettet til dekoderen et speilbilde av inngangskoderen. Dekoderen produserer ønsket utgang kun ved hjelp av kodelaget.

Forsikre deg om at koderen og dekoderen har samme dimensjonsverdier. Den viktige parameteren for å stille inn autoencoder er kodestørrelse, antall lag og antall noder i hvert lag.

Kodestørrelse er definert av den totale mengden noder som er til stede i mellomlaget. For å få effektiv komprimering er det anbefalt at det lille laget av et midtre lag blir brukt. Antall lag i autoencoder kan være dypt eller grunt som du ønsker. Antall noder i autoencoder skal være det samme i både koderen og dekoderen. Laget av dekoder og koder må være symmetrisk.

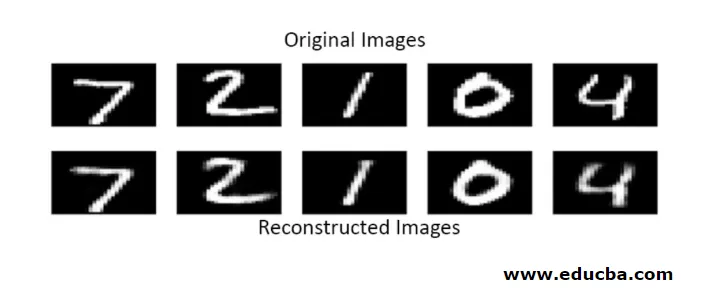

I stablet autoencoder har du ett usynlig lag i både koderen og dekoderen. Det består av håndskrevne bilder i størrelsen 28 * 28. Nå kan du utvikle autoencoder med 128 noder i det usynlige laget med 32 som kodestørrelse. Hvis du vil legge til mange antall lag, bruker du denne funksjonen

model.add(Dense(16, activation='relu'))

model.add(Dense(8, activation='relu'))

for konvertering,

layer_1 = Dense(16, activation='relu')(input)

layer_2 = Dense(8, activation='relu')(layer_1)

Nå blir output fra dette laget lagt til som input til neste lag. dette er det sammenfallbare laget i denne tette metoden. Dekoderen utfører denne funksjonen. Den bruker sigmoid-metoden for å få utdata mellom 0 og 1. Siden inngangen ligger mellom 0 og 1 område

Rekonstruksjon av innspill av en Autoencoder i denne metoden gjøres ved prediksjon. Den individuelle bildetesten utføres, og utdataene er ikke akkurat som inngang, men lik inngang. For å overvinne disse vanskene kan du gjøre autoencoder mer effektiv ved å legge til mange lag og legge til flere noder i lag. Men gjør den kraftigere resulterer det i en kopi av data som ligner på inngangen. Men dette er ikke det forventede resultatet.

Arkitektur av Autoencoder

I denne stablede arkitekturen har kodelaget liten dimensjonsverdi enn inndatainformasjon, der det sies å være under fullstendig autenkoder.

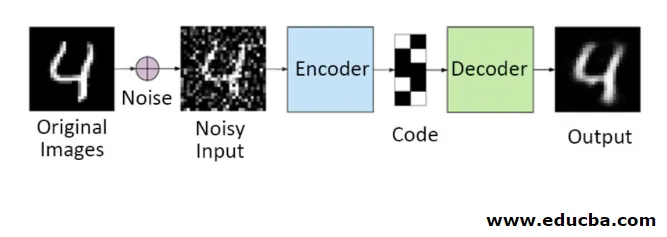

1. Denoising Autoencoders

På denne metoden kan du ikke kopiere inngangssignalet til utgangssignalet for å få det perfekte resultatet. For her inneholder inngangssignalet støy som må trekkes fra før du får resultatet som er de underliggende nødvendige dataene. Denne prosessen kalles som denoising autoencoder. Den første raden inneholder originale bilder. For å gjøre dem støyende inngangssignal legges det til noen støyende data. Nå kan du designe autoencoderen slik at den får en støyfri utgang som følger

autoencoder.fit(x_train, x_train)

En modifisert Autoencoder er som følger,

autoencoder.fit(x_train_noisy, x_train)

Derfor kan du enkelt få støyfri utgang.

Convolution autoencoder brukes til å håndtere komplekse signaler og får også et bedre resultat enn den normale prosessen

2. Sparsomme autokodere

For å bruke autoencodere effektivt, kan du følge to trinn.

Angi en liten kodestørrelse, og den andre benekter autoencoder.

Da er en annen effektiv metode regularisering. For å bruke denne regulariseringen, må du regularisere sparsitetsbegrensningene. For å aktivere noen deler av noder i laget legger du til noen ekstra vilkår til tapsfunksjonen som presser autoencoderen til å lage hver inngang som kombinert mindre noder og det gjør at koderen finner noen unike strukturer i de gitte dataene. Det er også aktuelt for et stort antall data fordi bare en del av noder er aktivert.

Sparsitetsbegrensningsverdien er nærmere null

For å generere et kodelag,

code = Dense(code_size, activation='relu')(input_img)

For å legge til reguleringsverdi,

code = Dense(code_size, activation='relu', activity_regularizer=l1(10e-6))(input_img)

I denne modellen er bare 0, 01 det endelige tapet også på grunn av reguleringsperioden.

I denne sparsomme modellen er en haug med kodeverdier sann til det forventede resultatet. Men det har ganske lave variansverdier.

Regulariserte autokodere har unike egenskaper som robusthet til manglende innganger, sparsom representasjon og nærmeste verdi for derivater i presentasjoner. For å bruke effektivt, hold minimum kodestørrelse og grunne kodere og dekoder. De oppdager en høy kapasitet på innganger og trenger ingen ekstra reguleringsbetegnelser for at koding skal være effektiv. De er opplært til å gi maksimal effekt i stedet for å kopiere og lime inn.

3. Variational Autoencoder

Det brukes i komplekse tilfeller, og det finner sjansene for distribusjon å designe inndataene. Denne variative autoencoderen bruker en samplingsmetode for å få sin effektive effekt. Den følger den samme arkitekturen som regulerte autokodere

Konklusjon

Derfor brukes autoencodere til å lære data og bilder fra den virkelige verden, involvert i binære og multiklasse klassifiseringer. Den enkle prosessen for dimensjonsreduksjon. Den brukes i en Begrenset Boltzmann-maskin og spiller en viktig rolle i den. Det brukes også i biokjemisk industri for å oppdage den uåpnede delen av læring og brukes til å identifisere mønsteret av intelligent atferd. Hver komponent i maskinlæring har en selvorganisert karakter, Autoencoder er en av det som er vellykket læring innen kunstig intelligens

Anbefalte artikler

Dette er en guide til Autoencoders. Her diskuterer vi hovedkomponentene i Autoencoder som er en koder, dekoder og kode og arkitekturen til Autoencoder. Du kan også se på følgende artikler for å lære mer -

- Big Data Architecture

- Koding vs dekoding

- Maskinlæringsarkitektur

- Big Data Technologies