Introduksjon til typer maskinlæringsalgoritmer

Maskinlæringsalgoritmetyper eller AI-beregninger er programmer (matematikk og begrunnelse) som endrer seg for å prestere bedre etter hvert som de blir presentert for mer informasjon. Å "tilpasse" en del av AI innebærer at disse prosjektene endrer hvordan de behandler informasjon etter en tid, omtrent som folk endrer hvordan de behandler informasjon ved å lære. Så en maskinlæring eller AI-beregning er et program med en spesiell metode for å endre sine helt egne parametere, gitt kritikk på tidligere forventninger til utstillingen som gjør et datasett.

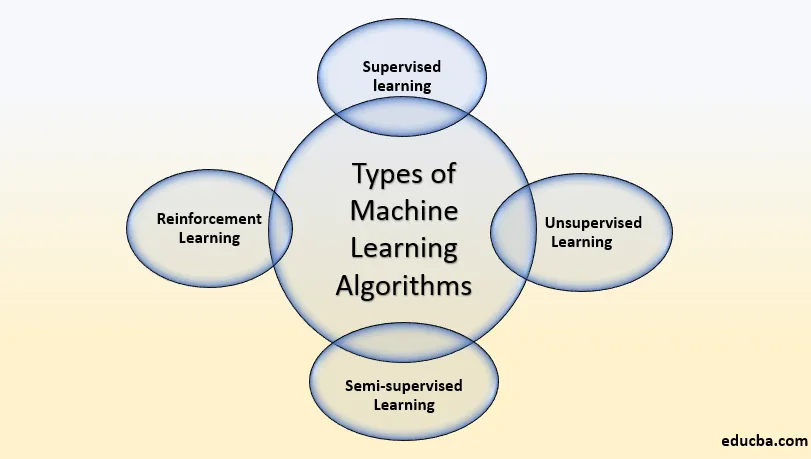

Alle typer maskinlæringsalgoritmer

Deres forskjellige varianter av hvordan man kan karakterisere typene Machine Learning Algorithms-typer, men vanligvis kan de deles inn i klasser i henhold til deres motivasjon og de grunnleggende klassifiseringene er de medfølgende:

- Veiledet læring

- Uovervåket læring

- Semi-veiledet læring

- Forsterkningslæring

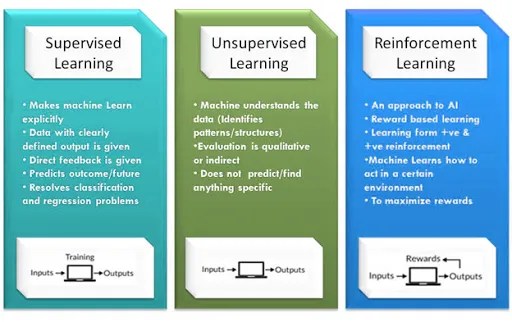

Hva er veiledet læring

Veiledet læring er, hvor du kan vurdere læringen styres av en instruktør. Vi har et datasett som fungerer som pedagog, og det er å forberede modellen eller maskinen. Når modellen blir forberedt, kan den begynne å slå seg til grunn av en forventning eller et valg når ny informasjon blir gitt til den.

Eksempel på veiledet læring:

- Du får mange fotografier med data om hva som er på dem, og etter det trener du en modell for å oppfatte nye fotografier.

- Du har mye data om boligprisene basert på deres størrelse og beliggenhet, og du mater den inn i modellen og trener den, så kan du forutsi prisen på andre hus basert på data du mater.

- Hvis du vil forutsi at meldingen er spam eller ikke er basert på eldre meldinger du har, kan du forutsi at en ny melding er spam eller ikke.

Den veiledte læringsalgoritmen er som følger:

1) Lineær regresjon

lineær regresjon er verdifull for å oppdage sammenhengen mellom to vedvarende faktorer. Den ene er en prediktor eller en autonom variabel, og den andre er en reaksjons- eller avdelingsvariabel. Den søker etter målbare forhold, men ikke et deterministisk forhold. Forbindelsen mellom to faktorer sies å være deterministisk over sjansen for at den ene variabelen kan kommuniseres nøyaktig av den andre. For eksempel ved bruk av temperatur i grad Celsius kan det tenkes å presist forutse Fahrenheit. Faktisk forhold er ikke presist når det gjelder å bestemme en forbindelse mellom to faktorer. For eksempel tilkobling et sted i området høyde og vekt. Den sentrale tanken er å få en linje som passer best til informasjonen. Den beste passformen er den linjen som all-out prognosefeil (all informasjonsfokus) er så lite som kan forventes under omstendighetene. Feilen er skillet mellom punktet til regresjonslinjen.

2) Beslutningstrær

Et beslutnings tre er en beslutningshjelpsmodul som bruker et tre-lignende diagram eller modell av avgjørelser og deres potensielle resultater, inkludert resultater av tilfeldigheter, ressursskostnader og nytteverdi. Utforsk bildet for å få et syn på hva det ligner på.

3) Naive Bayes klassifisering

Naive Bayes klassifiserer en gruppe grunnleggende sannsynlighetsklassifiserere som er avhengige av å anvende Bayes teori med sterk (usofistikert) selvstyre med trekkene Naive Bayes. Denne klassifiseringen Noen av de sertifiserbare modellene er:

For å stemple en e-post som spam eller ikke som spam

Bestill en nyhet om innovasjon, statlige spørsmål eller sport

Sjekk et snev av stoff som gir positive følelser, eller negative følelser?

Brukt for ansiktsgjenkjenningsprogrammering.

4) Logistisk regresjon

Logistisk regresjon er en banebrytende saklig metode for å demonstrere et binomialt resultat med minst en informative faktorer. Den kvantifiserer forbindelsen mellom den absolutte menighetsvariabelen og minst en gratis faktor ved å evaluere sannsynligheter ved å bruke en logistisk kapasitet, som er den kombinerte logistiske bevilgningen.

Normalt kan regresjoner brukes i det virkelige liv som:

Kredittpoeng

Målet på suksessraten til marked eller selskap

For å forutsi inntektene til et selskap eller ethvert produkt

Er det et jordskjelv på en hvilken som helst dag?

5) Vanlig minste kvadratregresjon

Minst firkanter er en strategi for å utføre direkte regresjon. direkte regresjon er forpliktelsen til å passe en linje gjennom mange fokus. Det er forskjellige potensielle prosedyrer for å gjøre dette, og "vanlige minste kvadrater" -system går slik: Du kan tegne en linje, og etter det for alle datasentrene, måle den vertikale løsningen mellom punktet og linjen, og innlemme disse opp; den monterte linjen vil være stedet dette aggregatet av skillevegger er så magert som kunne være normalt i lys av dagens situasjon.

Hva er uovervåket læring?

Modellen lærer gjennom persepsjon og oppdager strukturer i informasjonen. Når modellen får et datasett, oppdager den følgelig eksempler og forbindelser i datasettet ved å lage klaser i den. Det den ikke kan gjøre er å legge til merker i gjengen, på samme måte som den ikke kan angi at det er en samling av epler eller mango, men den vil isolere hvert enkelt av eplene fra mango.

Anta at vi viste bilder av epler, bananer og mango til modellen, så hva den gjør, i lys av visse eksempler og forbindelser, gjør den klaser og partisjonerer datasettet i disse gruppene. For øyeblikket hvis en annen informasjon styrkes til modellen, legger den den til en av de laget gruppene.

Eksempel på uovervåket læring

- Du har mange fotografier av 6 individer ennå uten data om hvem som er på hvilken, og du må isolere dette datasettet i 6 hauger, hver med fotografiene til en person.

- Du har partikler, noen deler av dem er medisiner, og deler er det ikke. Du skjønner ikke hvilket som vil være det, og du trenger beregningen for å finne medisinene.

Den uten tilsyn Læringsalgoritmen er som følger

Gruppering

Clustering er en viktig idé med tanke på uhjelpet læring. Det klarer for det meste å finne en struktur eller eksempel i en samling av ukategorisert informasjon. Clustering-beregninger vil behandle informasjonen din og oppdage karakteristiske klynger (grupper) i tilfelle de eksisterer i informasjonen. Du kan også endre hvilket antall bunter beregningene dine burde skille. Det lar deg endre granulariteten til disse samlingene.

Det er forskjellige typer klynger du kan bruke

- Selektiv (tildeling)

- Modell: K-betyr

- agglomerative

- Modell: Hierarkisk klynging

- dekker

- Modell: Fuzzy C-Means

- sannsynlighets

Clustering algoritm Typer

- Hierarkisk klynging

- K-betyr klynging

- K-NN (k nærmeste naboer)

- Hovedkomponentanalyse

- Solitary Value Decomposition

- Uavhengig komponentanalyse

- Hierarkisk klynging

Hierarkisk klynging

Hierarkisk klynging er en beregning som konstruerer en pecking rekkefølge av grupper. Det starter med all informasjonen som blir dratt ut til sin egen gjeng. Her vil to nære grupper være i en lignende gjeng. Denne beregningen lukkes når det bare er en gruppe igjen.

K-betyr Clustering

K betyr at det er en iterativ klyngeberegning som oppfordrer deg til å finne det mest bemerkelsesverdige incentivet for hver vektlegging. Til å begynne med blir det ideelle antall grupper valgt. I denne klyngeteknikken må du samle informasjonen som fokuserer på k-samlinger. En større k betyr små samlinger med større granularitet på samme måte. En lavere k betyr større sammenkomster med mindre granularitet.

Utbyttet av beregningen er en samling av "navn." Den tillater informasjon som peker til en av k samlingene. I k-betyr klynging er hver samling preget av å lage en centroid for hver samling. Centroids er som kjernen i gjengen, som fanger fokusene nærmest dem og legger dem til gruppen.

K-mean klynging karakteriserer ytterligere to undergrupper

- Agglomerativ gruppering

- dendrogram

Agglomerativ gruppering

Denne typen K-betyr klynging begynner med et fast antall klaser. Den utpeker all informasjon til et nøyaktig antall grupper. Denne grupperingsstrategien krever ikke antall grupper K som info. Agglomerasjonsprosedyre begynner med å forme hvert avfall som en enslig gjeng.

Denne strategien benytter et visst separasjonstiltak, reduserer antall klaser (en i hver vekt) ved å kombinere prosess. Avslutningsvis har vi en hovedgruppe som inneholder hver eneste av artiklene.

dendrogram

I Dendrogram-klyngeteknikken vil hvert nivå snakke med en tenkelig gjeng. Dendrogrammets høyde viser graden av likhet mellom to sammenføyningsbaser. Jo nærmere basen av prosedyren de er gradvis sammenlignbare gjenger som er å finne samlingen fra dendrogram som ikke er karakteristisk og for det meste abstrakt.

K-nærmeste naboer

K-nærmeste nabo er den mest enkle av alle AI-klassifiserere. Det varierer fra andre AI-prosedyrer, ved at den ikke leverer en modell. Det er en grei beregning som lagrer hver eneste tilgjengelige sak og karakteriserer nye eksempler avhengig av et likhetstiltak.

Det fungerer veldig bra når det er skille mellom modeller. Læringsfrekvensen er moderat når forberedelsessettet er enormt, og at separasjonsfiguren ikke er triviell.

Hovedkomponenter analyse

På sjansen for at du trenger et høyere dimensjonalt rom. Du må velge en grunn til den plassen og bare de 200 mest betydningsfulle poengsumene for det forutsetningen. Denne basen er kjent som en hovedkomponent. Undersetet du velger utgjør et annet rom som er lite i størrelse i kontrast til unikt mellomrom. Det holder imidlertid opp om mye av den mangefasetterte informasjonen som forventet.

Hva er forsterkningslæring?

Det er kapasiteten til en spesialist å samarbeide med jorden og oppdage hva som er det beste resultatet. Den forfølger ideen om hit og foreløpig teknikk. Operatøren blir godtgjort eller straffet med et poeng for en rettighet eller en off-base svar, og basert på den positive belønningen er fokusene plukket opp selve togene. Også en gang forberedt den forbereder seg på å forutse den nye informasjonen som ble introdusert for den.

Eksempel på forsterkningslæring

- Å vise annonser, i henhold til brukerne, liker ikke å optimalisere for lang tid

- Kjenn til annonsebudsjett som brukes i sanntid

- omvendt forsterkning som lærer å kjenne kunder som ikke liker bedre

Hva er halvveiledet læring?

Semi-veiledet type læring, beregningen er utarbeidet på en blanding av navngitt og umerket informasjon. Normalt vil denne blandingen inneholde et begrenset antall navngitte opplysninger og mye umerket informasjon. Den grunnleggende metoden som er inkludert er at programvareingeniøren først vil gruppere sammenlignbar informasjon ved å bruke en uassistert læringsberegning og deretter bruke den gjeldende navngitte informasjonen for å navngi resten av den umerkede informasjonen. De vanlige bruksforekomstene av en slik type beregning har en typisk egenskap blant dem. Innhenting av umerket informasjon er generelt beskjedent, mens navnet på nevnte informasjon er over det dyre. Naturligvis kan man se for seg de tre typene læringsberegninger som Supervised innse hvor en understudy er under tilsyn av en instruktør både hjemme og på skolen, Unsupervised innse hvor en understudy trenger å gi mening om en ide selv og Semi-Supervised innse hvor en pedagog viser et par ideer i klassen og gir henvendelser som skolearbeid som er avhengig av sammenlignbare ideer.

Eksempel på Semi-Supervised Learning

Det er enestående at mer informasjon = modeller av bedre kvalitet i dyptgående læring (opp til et bestemt innesperringspunkt tydelig, men oftere enn ikke har vi ikke så mye informasjon.) Det er kostbart å få merket informasjon. I tilfelle du trenger å forberede en modell for å skille bevingede dyr, kan du sette opp mange kameraer for å ta bilder av fugler. Det er generelt beskjedent. Det er kostbart å kontrahere enkeltpersoner for å merke disse bildene. Tenk på muligheten for at du har et enormt antall bilder av bevingede dyr, men bare kontraher enkeltpersoner for å markere en liten undergruppe av bildene. Som det viste seg, i stedet for bare å trene modellene på det markerte undersettet, kan du forhåndstrenere modellen på hele treningssettet, før du finjustere den med det navngitte undergruppen, og du viser tegn til forbedring av utførelsen i disse linjene. Det er halvveiledet læring. Det setter pengene dine til side.

Konklusjon

Det er mange typer maskinlæringsalgoritme der, og basert på forskjellige-forskjellige forhold må vi bruke den best tilpassede algoritmen for best resultat. Det er mange algoritmer som finner best nøyaktighet for hver maskinlæringsalgoritmetyper, og som er den høyeste nøyaktige vi har for å bruke den algoritmen. Vi kan minimere feilen til hver algoritme ved å redusere støy i data. Til slutt vil jeg si at det ikke er en eneste maskinlæringsalgoritme som kan gi deg 100 prosent nøyaktighet, selv ikke den menneskelige hjernen kan gjøre det, så finn den beste granalgoritmen for dataene dine.

Anbefalte artikler

Dette er en guide til typer maskinlæringsalgoritmer. Her diskuterer vi Hva er maskinlæringsalgoritme ?, og dens typer inkluderer Overvåket læring, Uovervåket læring, halvveiledet læring, forsterkningslæring. Du kan også se på følgende artikler for å lære mer -

- Læringsmetoder for maskiner

- Maskinlæringsbiblioteker

- Maskinlæringsmodeller

- Maskiner for læring av maskiner

- Hyperparameter maskinlæring

- Hierarkisk klynging | Agglomerative & Divisive Clustering

- Lag beslutningstreet | Hvordan lage | Fordeler

- Maskinlæring livssyklus | Topp 8 trinn