Introduksjon til Decision Tree in Machine Learning

Decision Tree in Machine Learning har et bredt felt i den moderne verden. Det er mange algoritmer i ML som brukes i vårt daglige liv. En av de viktige algoritmene er Decision Tree som brukes til klassifisering og også en løsning for regresjonsproblemer. Ettersom det er en prediktiv modell, blir Decision Tree Analyse gjort via algoritmisk tilnærming der et datasett er delt opp i delmengder per betingelser. Navnet selv sier at det er en trelignende modell i form av utsagn om ikke-da-ellers. Jo dypere treet er, og flere er nodene, jo bedre er modellen.

Typer av beslutningstreet i maskinlæring

Decision Tree er en trelignende graf der sorteringen starter fra rotnoden til bladnoden til målet er oppnådd. Det er den mest populære for beslutning og klassifisering basert på overvåkte algoritmer. Den er konstruert ved rekursiv partisjonering der hver node fungerer som en test case for noen attributter og hver kant, som stammer fra noden, er et mulig svar i test case. Både rot- og bladnodene er to enheter i algoritmen.

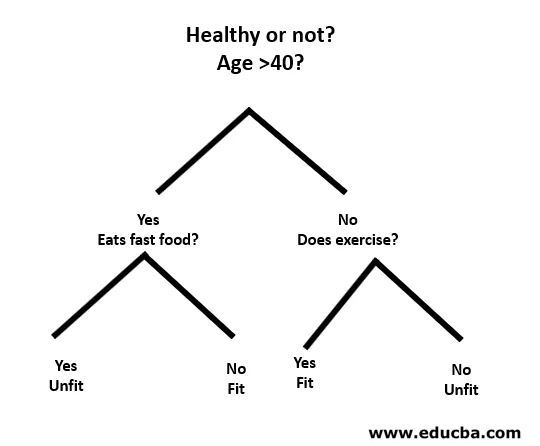

La oss forstå med hjelp av et lite eksempel på følgende måte:

Her er rotnoden om du er under 40 eller ikke. I så fall spiser du hurtigmat? Hvis ja, så er du uegnet, ellers er du i form. Og hvis du er mer enn 40, så trener du? I så fall er du i form, ellers er du uskikket. Dette var i utgangspunktet en binær klassifisering.

Det er to typer avgjørelsestrær:

- Klassifiseringstrær: Eksemplet ovenfor er et kategoribasert klassifiseringstræ.

- Regresjonstrær : I denne typen algoritmer er beslutningen eller resultatet kontinuerlig. Den har en enkelt numerisk utgang med flere innganger eller prediktorer.

I beslutningstreet er den typiske utfordringen å identifisere attributtet ved hver node. Prosessen kalles attributtvalg og har noen tiltak å bruke for å identifisere attributtet.

en. Informasjonsgevinst (IG)

Information Gain måler hvor mye informasjon en individuell funksjon gir om klassen. Det fungerer som hovednøkkelen til å konstruere et beslutningstre. Et attributt med den høyeste informasjonsgevinsten deles først. Så beslutningstreet maksimerer alltid informasjonsgevinsten. Når vi bruker en node til å dele inn forekomstene i mindre undergrupper, endres entropien.

Entropi: Det er målet på usikkerhet eller urenhet i en tilfeldig variabel. Entropy bestemmer hvordan et Decision Tree deler opp dataene i delmengder.

Ligningen for informasjonsgevinst og entropi er som følger:

Informasjonsgevinst = entropi (overordnet) - (vektet gjennomsnitt * entropi (barn))

Entropi: ∑p (X) log p (X)

P (X) her er brøkdelen av eksempler i en gitt klasse.

b. Gini-indeksen

Gini-indeksen er en beregning som bestemmer hvor ofte et tilfeldig valgt element vil bli feil identifisert. Den sier tydelig at attributter med en lav Gini-indeks får første preferanse.

Gini-indeks: 1-∑ p (X) 2

Del opprettelse

- For å lage en splittelse, må vi først beregne Gini-poengsummen.

- Dataene er delt ved å bruke en liste over rader som har en indeks for et attributt og en delt verdi for det attributtet. Etter at høyre og venstre datasett er funnet, kan vi få delt verdien med Gini-poengsummen fra første del. Nå er den delte verdien avgjøreren der attributtet skal ligge.

- Neste del er å evaluere alle delingene. Best mulig verdi beregnes ved å vurdere kostnaden for splittelsen. Den beste delingen brukes som en nod til beslutnings-treet.

Building a Tree - Decision Tree in Machine Learning

Det er to trinn for å bygge et beslutnings tre.

1. Oppretting av terminalnode

Mens vi oppretter terminalnoden, er det viktigste å merke seg om vi trenger å slutte å dyrke trær eller gå videre. Følgende måter kan brukes til dette:

- Maksimal treedybde: Når treet når det maksimale antall noder, stopper utførelsen der.

- Minimum nodeposter: Det kan defineres som et minimum av mønstre som en node krever. Da kan vi slutte å legge til terminalnoder med en gang vi får de minste nodepostene.

2. Rekursiv splitting

Når noden er opprettet, kan vi opprette en barneknute rekursivt ved å dele datasettet og kalle den samme funksjonen flere ganger.

Prediksjon

Etter at et tre er bygd, blir prediksjonen gjort ved hjelp av en rekursiv funksjon. Den samme prediksjonsprosessen følges igjen med venstre eller høyre barneknuter og så videre.

Fordeler og ulemper ved beslutningstreet

Nedenfor er gitt noen fordeler og ulemper:

Fordeler

Avgjørelsestreet har noen fordeler i maskinlæring som følger:

- Omfattende: Den tar hensyn til hvert mulig utfall av en beslutning og sporer hver node til konklusjonen deretter.

- Spesifikt: Beslutningstrær tildeler en spesifikk verdi til hvert problem, beslutning og utfall (er). Det reduserer usikkerhet og tvetydighet og øker også klarheten.

- Enkelhet: Decision Tree er en av de enklere og pålitelige algoritmene, da det ikke har noen komplekse formler eller datastrukturer. Bare enkel statistikk og matematikk kreves for beregning.

- Allsidig: Beslutningstrær kan manuelt konstrueres ved bruk av matematikk og kan også brukes sammen med andre dataprogrammer.

ulemper

Avgjørelsestreet har noen ulemper ved maskinlæring som følger:

- Beslutningstrær er mindre passende for estimering og økonomiske oppgaver der vi trenger en passende verdi (er).

- Det er en feilutsatt klassifiseringsalgoritme sammenlignet med andre beregningsalgoritmer.

- Det er beregningsdyktig. Ved hver node må kandidatsplikten sorteres før den vurderes best. Det er andre alternativer som mange forretningsenheter følger for økonomiske oppgaver ettersom Decision Tree er for dyrt for evaluering.

- Mens du arbeider med kontinuerlige variabler, er Decision Tree ikke egnet som den beste løsningen ettersom det har en tendens til å miste informasjon mens du kategoriserer variabler.

- Noen ganger er det ustabilt da små variasjoner i datasettet kan føre til dannelse av et nytt tre.

Konklusjon - Decision Tree in Machine Learning

Som en av de viktigste og overvåkte algoritmene spiller Decision Tree en viktig rolle i beslutningsanalyser i det virkelige liv. Som en prediktiv modell brukes den på mange områder for sin splittede tilnærming som hjelper med å identifisere løsninger basert på forskjellige forhold ved enten klassifisering eller regresjonsmetode.

Anbefalte artikler

Dette er en guide til Decision Tree in Machine Learning. Her diskuterer vi introduksjonen, Types of Decision Tree in Machine Learning, Split creation and Building a Tree. Du kan også gå gjennom de andre foreslåtte artiklene våre for å lære mer–

- Python datatyper

- Tableau datasett

- Cassandra datamodellering

- Avgjørelse tabell testing

- Topp 8 stadier i maskinlæring livssyklus