Introduksjon til klassifiseringsalgoritmer

Denne artikkelen om klassifiseringsalgoritmer gir en oversikt over forskjellige klassifiseringsmetoder som ofte brukes i data mining-teknikker med forskjellige prinsipper. Klassifisering er en teknikk som kategoriserer data i et bestemt antall klasser og i sin tur tilordnes etikett til hver klasse. Hovedmålet for klassifisering er å identifisere klassen for å lansere nye data ved analyse av opplæringssettet ved å se riktige grenser. På en generell måte kalles klassifisering av å forutsi målklassen og prosessen ovenfor.

For eksempel registrerer sykehusledelsen pasientens navn, adresse, alder, tidligere historie om pasientens helse for å diagnostisere dem, dette er med på å klassifisere pasientene. De kan karakteriseres i to faser: en læringsfase og evalueringsfase. Læringsfasemodeller tilnærmingsbasen gir ikke opplæringsdata, mens evalueringsfasen forutsier resultatet for de gitte dataene. Vi kunne finne applikasjonene deres i e-post spam, prediksjon av banklån, talegjenkjenning, sentimentanalyse. Teknikken inkluderer matematisk funksjon f med inngang X og utgang Y.

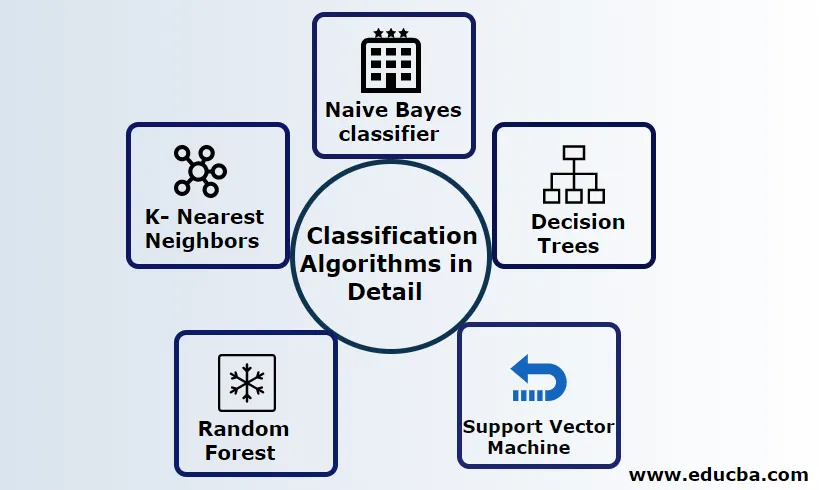

Forklar klassifiseringsalgoritmer i detalj

Klassifisering kan utføres på både strukturerte og ustrukturerte data. Klassifisering kan kategoriseres i

- Naive Bayes klassifiserer

- Beslutningstrær

- Støtt vektormaskin

- Tilfeldig skog

- K- Nærmeste naboer

1) Naive Bayes klassifiserer

Det er en Bayes teorem-baserte algoritme, en av de statistiske klassifiseringene og krever få mengder treningsdata for å estimere parametrene også kjent som probabilistiske klassifisere. Det anses å være den raskeste klassifiseringen, meget skalerbar og håndterer både diskrete og kontinuerlige data. Denne algoritmen brukes til å gjøre en prediksjon i sanntid. Det er forskjellige typer naive klassifiserere, Multinomial Naïve Bayes, Bernoulli Naïve Bayes, Gauss naive.

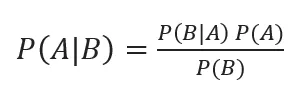

Bayesisk klassifisering med bakre sannsynligheter er gitt av

Hvor A, B er hendelser, P (A | B) - Posterior sannsynligheter.

Hvis to verdier er uavhengige av hverandre,

P (A, B) = P (A) P (B)

Naïve Bayes kan bygges ved hjelp av python-biblioteket. Naives prediktorer er uavhengige, selv om de brukes i anbefalingssystemer. De brukes i mange sanntidsapplikasjoner og velbevisst brukt i dokumentklassifisering.

Fordeler:

Fordelene er at de krever veldig mindre datakraft, antatt i flere klasseforutsigelsesproblemer, og fungerer nøyaktig på store datasett.

Ulempe:

Den største ulempen med denne klassifisereren er at de vil tildele null sannsynlighet. Og de har funksjoner med er uavhengige av hverandre.

2) Avgjørelsestre

Det er en ovenfra og ned tilnærmingsmodell med strukturen til flytskjemaet som håndterer høydimensjonale data. Resultatene er forutsagt basert på den gitte inngangsvariabelen. Avgjørelsestre sammensatt av følgende elementer: En rot, mange noder, grener, blader. Rotknoden gjør partisjonen basert på attributtverdien til klassen, den interne noden tar et attributt for videre klassifisering, grener tar en beslutningsregel om å dele noder i bladnoder, til slutt gir bladnodene oss det endelige utfallet. Tidskompleksiteten til avgjørelsestreet avhenger av antall poster, attributter for treningsdataene. Hvis avgjørelsestreet er for langt, er det vanskelig å få de ønskede resultatene.

Fordel: De blir brukt til prediktiv analyse for å løse problemene og brukes i daglige til daglige aktiviteter for å velge mål basert på beslutningsanalyse. Bygger automatisk en modell basert på kildedataene. Best i å håndtere manglende verdier.

Ulempe: Størrelsen på treet er ukontrollerbar til det har noen stoppkriterier. På grunn av deres hierarkiske struktur er treet ustabilt.

3) Support Vector Machine

Denne algoritmen spiller en viktig rolle i klassifiseringsproblemer, og mest populært er en maskinlæring overvåket algoritmer. Det er et viktig verktøy som brukes av forskeren og dataforskeren. Denne SVM er veldig enkel, og prosessen er å finne et hyperplan i et N-dimensjonalt romdatapunkt. Hyperplaner er beslutningsgrenser som klassifiserer datapunktene. All denne vektoren faller nærmere hyperplanet, maksimerer margen til klassifiseringen. Hvis margen er maksimal, er den laveste generaliseringsfeilen. Implementeringen av dem kan gjøres med kjernen ved å bruke python med noen treningsdatasett. SVMs hovedmål er å trene et objekt inn i en bestemt klassifisering. SVM er ikke begrenset til å bli en lineær klassifiserer. SVM er å foretrekke mer enn noen klassifiseringsmodell på grunn av deres kjernefunksjon som forbedrer beregningseffektiviteten.

Fordel: De er sterkt å foretrekke på grunn av mindre datakraft og effektiv nøyaktighet. Effektiv i høyt dimensjonalt rom, god minneeffektivitet.

Ulempe: Begrensninger i hastighet, kjerne og størrelse

4) Tilfeldig skog

Det er en kraftig maskinlæringsalgoritme basert på læringsmetoden Ensemble. Den grunnleggende byggesteinen til tilfeldig skog er avgjørelsestreet som brukes til å bygge prediktive modeller. Arbeidsdemonstrasjonen inkluderer å lage en skog av tilfeldige beslutnings-trær, og beskjæringsprosessen utføres ved å stille en stopper for å gi et bedre resultat. Tilfeldig skog implementeres ved bruk av en teknikk som kalles bagging for beslutningstaking. Denne bagging forhindrer overmasse av data ved å redusere skjevhet på samme måte som dette tilfeldige kan oppnå bedre nøyaktighet. En endelig prediksjon er tatt av et gjennomsnitt av mange beslutnings-trær, dvs. hyppige prediksjoner. Den tilfeldige skogen inkluderer mange brukssaker som forutsigelser om aksjemarkeder, uredelig oppdagelse, nyhetsspådommer.

Fordeler:

- Krever ikke noen stor behandling for å behandle datasettene og en veldig enkel modell å bygge. Gir større nøyaktighet hjelper deg med å løse prediktive problemer.

- Fungerer godt i håndtering av manglende verdier og oppdager automatisk en utligger.

Ulempe:

- Krever høye beregningskostnader og høyt minne.

- Krever mye mer tidsperiode.

5) K- nærmeste naboer

Her vil vi diskutere K-NN algoritmen med veiledet læring for CART. De benytter seg av K-positivt lite heltall; et objekt blir tildelt klassen basert på naboene, eller vi skal si tilordne en gruppe ved å observere i hvilken gruppe naboen ligger. Dette velges ved avstandsmål Euklidisk avstand og en brute kraft. Verdien av K kan bli funnet ved hjelp av innstillingsprosessen. KNN foretrekker ikke å lære noen modell for å trene et nytt datasett og bruke normalisering for å omskalere data.

Fordel: Gir effektive resultater hvis treningsdataene er enorme.

Ulempe: Det største problemet er at hvis variabelen er liten, fungerer den bra. For det andre å velge K-faktor mens du klassifiserer.

Konklusjon

Avslutningsvis har vi gått gjennom egenskapene til forskjellige klassifiseringsalgoritmer fremdeles fungerer som et kraftig verktøy innen funksjonsteknikk, bildeklassifisering som spiller en stor ressurs for maskinlæring. Klassifiseringsalgoritmer er kraftige algoritmer som løser harde problemer.

Anbefalte artikler

Dette er en guide til klassifiseringsalgoritmer i maskinlæring. Her diskuterer vi at klassifiseringen kan utføres på både strukturerte og ustrukturerte data. Du kan også gå gjennom andre foreslåtte artikler -

- Ruteringsalgoritmer

- Clustering algoritme

- Databehandling

- Maskinlæringsalgoritmer

- Mest brukte teknikker for læring av ensemble

- C ++ algoritme | Eksempler på C ++ algoritme