Introduksjon til maskinlæringsmetoder

Følgende artikkel, Machine Learning Methods, gir en oversikt over de mest brukte metodene i maskinlæring. Maskinlæring er en teknikk som gjør en datamaskin i stand til å 'lære' ting på egen hånd. Algoritmene forbedrer deres ytelse adaptivt når dataene som er tilgjengelige for læring øker. Det er mer data, jo mer nøyaktig vil modellen vår være.

Hvordan lærer maskiner?

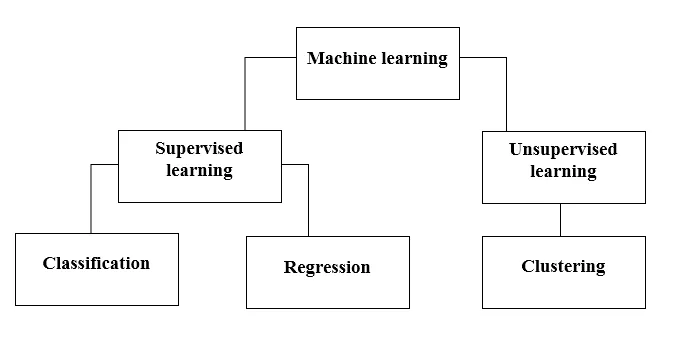

Det er forskjellige metoder for å gjøre det. Hvilken metode du skal følge helt avhenger av problemstillingen. Avhengig av datasettet, og problemet vårt, er det to forskjellige måter å gå dypere på. Den ene er veiledet læring og den andre er uten tilsyn. Følgende diagram forklarer den videre klassifiseringen av maskinlæringsmetoder. Vi vil diskutere dem en etter en.

Ta en titt på følgende diagram!

La oss forstå hva betyr Supervised Learning.

Veiledet læring

Som navnet antyder, kan du tenke deg en lærer eller en veileder som hjelper deg å lære. Det samme gjelder maskiner. Vi trener eller lærer maskinen ved å bruke data som er merket.

Noen av de kuleste lærte applikasjonene under veiledning er:

- Sentimentanalyse (Twitter, Facebook, Netflix, YouTube osv.)

- Natural Language Processing

- Bildeklassifisering

- Prediktiv analyse

- Mønstergjenkjenning

- Spamdeteksjon

- Tale / sekvensbehandling

Nå er veiledet læring videre delt inn i klassifisering og regresjon. La oss forstå dette.

Klassifisering

Klassifisering er prosessen med å finne en modell som hjelper til med å skille dataene i forskjellige kategoriske klasser. I denne prosessen blir data kategorisert under forskjellige etiketter i henhold til noen parametere gitt i inndata, og deretter blir etikettene spådd for dataene. Kategorisk betyr at utgangsvariabelen er en kategori, dvs. rød eller svart, spam eller ikke spam, diabetiker eller ikke-diabetiker, etc.

Klassifiseringsmodeller inkluderer Support vector machine (SVM), K-nærmeste nabo (KNN), Naive Bayes etc.

a) Support Vector machine classifier (SVM)

SVM er en veiledet læringsmetode som ser på dataene og sorterer dem i en av to kategorier. Jeg bruker et hyperplan for å kategorisere dataene. En lineær, diskriminerende klassifiserer prøver å tegne en rett linje som skiller de to datasettene og derved lage en modell for klassifisering. Den prøver ganske enkelt å finne en linje eller kurve (i to dimensjoner) eller et grenrør (i flere dimensjoner) som deler klasser fra hverandre.

Merknad - For multiklasseklassifisering bruker SVM 'en vs hvile', det betyr å beregne forskjellige SVM for hver klasse.

b) K-nærmeste naboklassifiserer (KNN)

- Hvis du leser nøye, antyder selve navnet hva algoritmen gjør. KNN vurderer datapunktene som er nærmere, er mye mer like med tanke på funksjoner og dermed mer sannsynlig å tilhøre samme klasse som naboen. For et hvilket som helst nytt datapunkt beregnes avstanden til alle andre datapunkter og klassen avgjøres basert på K nærmeste naboer. Ja, det kan høres haltende ut, men for noe av klassifiseringen fungerer det som hva som helst.

- Et datapunkt klassifiseres etter det maksimale antallet stemmer for sine naboer, deretter blir datapunktet tildelt klassen nærmest blant sine k-naboer.

- I KNN er det ikke nødvendig med læring av modellen, og alt arbeidet skjer på det tidspunktet det blir bedt om en prediksjon. Derfor blir KNN ofte omtalt som en lat læringsalgoritme.

c) Naïve Bayes klassifiserer

- Naïve Bayes er en maskinlæringsalgoritme som er sterkt anbefalt for tekstklassifiseringsproblemer. Det er basert på Bayes sannsynlighetsteorem. Disse klassifisatorene kalles naive fordi de antar at funksjonsvariabler er uavhengige av hverandre. Det betyr at vi for eksempel har en full setning for innspill, da antar Naïve Bayes at hvert ord i en setning er uavhengig av de andre. Og klassifiser dem deretter. Jeg vet, det ser ganske naivt ut, men det er et godt valg for tekstklassifiseringsproblemer, og det er et populært valg for klassifisering av e-postadresser mot spam.

- Det gir forskjellige typer Naive Bayes-algoritmer som BernoulliNB, GaussianNB, MultinomialNB.

- Den anser alle funksjonene som ikke relatert, så den kan ikke lære forholdet mellom funksjoner. For eksempel, la oss si, Varun liker å spise burgere, han liker også å spise pommes frites med koks. Men han liker ikke å spise en burger og en kombinasjon av pommes frites med koks sammen. Her kan Naïve Bayes ikke lære forholdet mellom to funksjoner, men lærer bare individuell funksjonsvikt.

La oss nå gå videre til den andre siden av vår veiledede læringsmetode, som er en regresjon.

regresjon

Regresjon er prosessen med å finne en modell som hjelper til å differensiere dataene ved bruk av kontinuerlige verdier. I dette ordnes arten av de forutsagte dataene. Noen av de mest brukte regresjonsmodellene inkluderer lineær regresjon, tilfeldig skog (beslutningstrær), nevrale nettverk.

Lineær regresjon

- En av de enkleste tilnærmingene i veiledet læring, som er nyttig for å forutsi den kvantitative responsen.

- Lineær regresjon inkluderer å finne den best tilpassede rette linjen gjennom punktene. Den best passende linjen kalles en regresjonslinje. Den beste passformlinjen passerer ikke akkurat gjennom alle datapunktene, men prøver i stedet det beste for å komme nær dem.

- Det er den mye brukte algoritmen for kontinuerlige data. Den fokuserer imidlertid bare på middelet til den avhengige variabelen og begrenser seg til et lineært forhold.

- Lineær regresjon kan brukes til tidsserier, trendprognoser. Det kan forutsi fremtidig salg, basert på tidligere data.

Uovervåket læring

- Uovervåket læring er basert på tilnærmingen som kan tenkes å være fravær av lærer og derfor absolutte feiltiltak. Det er nyttig når det kreves for å lære gruppering eller gruppering av elementer. Elementer kan grupperes (grupperes) i henhold til deres likhet.

- I uovervåket læring er data umerket, ikke kategorisert og systemets algoritmer virker på dataene uten forutgående opplæring. Uovervåkte læringsalgoritmer kan utføre mer komplekse oppgaver enn veiledte læringsalgoritmer.

- Uovervåket læring inkluderer gruppering som kan gjøres ved å bruke K betyr klynging, hierarkisk, gaussisk blanding, skjult Markov-modell.

Uovervåkte læringsapplikasjoner er:

- Likhetsdeteksjon

- Automatisk merking

- Objektsegmentering (for eksempel person, dyr, filmer)

Gruppering

- Clustering er en uovervåket læringsteknikk som brukes til dataanalyse på mange felt. Klyngealgoritmen kommer godt med når vi ønsker å få detaljert innsikt om dataene våre.

- Et ekte eksempel på gruppering ville være Netflixs sjangerklynger, som er delt for forskjellige målkunder inkludert interesser, demografi, livsstil osv. Nå kan du tenke på hvor nyttig klynging er når bedrifter ønsker å forstå kundebasen og målrette et nytt potensial kunder.

a) K betyr Clustering

- K betyr at grupperingsalgoritmen prøver å dele opp de gitte ukjente dataene i klynger. Den velger tilfeldig 'k' klynger centroid, beregner avstanden mellom datapunkter og klynger centroid og tildeler til slutt datapunktet til klynge centroid hvis avstand er minimum av alle klyngesenterroider.

- I k-betyr er grupper definert av den nærmeste centroid for hver gruppe. Denne centroid fungerer som 'hjerne' av algoritmen, de tilegner seg datapunktene som er nærmest dem og legger dem deretter til klyngene.

b) Hierarkisk klynging

Hierarkisk klynging er nesten lik den ved vanlig klynging med mindre du vil bygge et hierarki av klynger. Dette kan komme til nytte når du vil bestemme antall klynger. Anta for eksempel at du oppretter grupper med forskjellige varer i den elektroniske dagligvarebutikken. På forsiden vil du ha noen få brede elementer, og når du først klikker på et av elementene, vil spesifikke kategorier, det vil si mer spesifikke klynger, åpne seg.

Dimensjonsreduksjon

Dimensjonsreduksjon kan betraktes som komprimering av en fil. Det betyr å ta ut informasjonen som ikke er relevant. Det reduserer kompleksiteten i data og prøver å beholde de meningsfylte dataene. Ved bildekomprimering reduserer vi for eksempel dimensjonaliteten til rommet der bildet holder seg som det er uten å ødelegge for mye av det meningsfylte innholdet i bildet.

PCA for datavisualisering

Principal component analysis (PCA) er en dimensjonsreduksjonsmetode som kan være nyttig for å visualisere dataene dine. PCA brukes til å komprimere data med høyere dimensjoner til lavere dimensjonale data, det vil si at vi kan bruke PCA for å redusere en fire-dimensjonal data til tre eller to dimensjoner, slik at vi kan visualisere og få en bedre forståelse av dataene.

Anbefalte artikler

Dette er en guide til Machine Learning Methods. Her har vi diskutert en introduksjon, Hvordan lærer maskiner? klassifiseringer av maskinlæring og et flytskjema sammen med en detaljforklaring. Du kan også gå gjennom andre foreslåtte artikler for å lære mer -

- Maskinlæringsarkitektur

- Maskiner for læring av maskiner

- Machine Learning Tools

- Maskinlæringsteknikker

- Hyperparameter maskinlæring

- Hierarkisk Clustering Algorithm

- Hierarkisk klynging | Agglomerative & Divisive Clustering