Forskjellen mellom Hadoop og SQL

De enorme dataene som genereres hvert sekund via sosiale medier som Facebook, Twitter, Instagram har banet vei for utviklingen av Hadoop / Big Data Ecosystem. Begrepet “3V” som refererer til Volum, hastighet og Veracity definerer viktigheten av Hadoop for å håndtere streaming-dataene. I dag genereres data fra flere kilder som er nødvendige for å bli integrert for forskjellige formål som rapportering, dataanalyse og forskning og for sentralisert lagring av data. Når vi gjør det, oppstår det mange problemer med tradisjonelle tilnærminger som rom, tilgang, integritet, struktur og båndbredde. For å håndtere alle disse problemene gir Hadoop et rammeverk som gjør det mulig å behandle dataene med enorm størrelse, for å gi enkel tilgang, høy tilgjengelighet og å laste inn data dynamisk. Den har et distribuert filsystemrammeverk (HDFS) for lagring av data og innebygd spørringsprosessor kalt “Map Reduce” for analyse og prosessering av data som er lagret i HDFS.

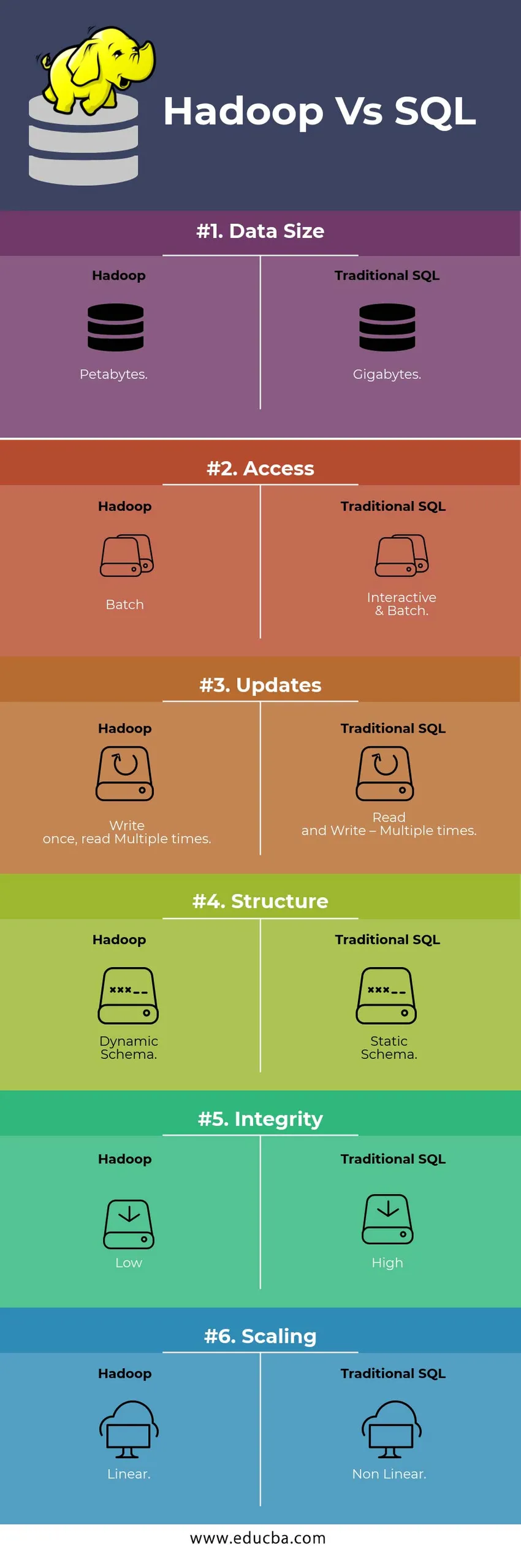

HEAD TO HEAD Sammenligning mellom Hadoop Vs SQL

Nedenfor er Topp 6-forskjellen mellom Hadoop Vs SQL

Viktige forskjeller mellom Hadoop Vs SQL

Nedenfor er forskjellen mellom Hadoop og SQL er som følger

- Skjema på SKRIV VS LES

Generelt i en tradisjonell database, under datalast / migrering fra en database til en annen, følger det skjemaet for Skriv tilnærming. Dette gjør datalastprosessen for å bli opphisset / avbrutt og resulterer i avvisning av poster på grunn av en forskjell i strukturen til kildetabellen og måltabellene. Mens Hadoop-systemet er alle data lagret i HDFS og dataene er sentraliserte.

Hadoop-rammeverket brukes hovedsakelig for Data Analytics-prosessen. Dermed støtter den alle tre kategoriene av data, dvs. strukturerte, semistrukturerte og ustrukturerte data, og det muliggjør skjema på lesing.

- Strukturerte data har et bestemt format. g .: XML-fil.

- Semi Structures-data er løsere; Det kan ha / ikke ha et skjema. g .: Regneark

- Ustrukturerte data har ikke en spesifikk struktur eller et skjema. F.eks .: Vanlig tekst eller bilde.

Hadoop jobber effektivt med ustrukturerte data da det har muligheten til å tolke dataene under behandlingstiden.

| Nærme seg | Fordel | Dis Advantage |

| Skjema på Skriv | · Forhåndsdefinerte strukturer

· Raskere lesing. F.eks: tradisjonell RDBMS. | Sakte datalaster

Høy latens |

| Skjema på Les | · Dynamisk struktur

· Rask og lese. F.eks: Hadoop | Rask datalast

Lav latens |

Tabell : Schema on WRITE VS Schema on READ.

- SCALABILITY & KOSTNADER

Hadoop Framework er designet for å behandle et stort datamengde. Når datastørrelsen øker, kan et antall ekstra ressurser som datanode veldig enkelt legges til klyngen enn den tradisjonelle tilnærmingen til statisk minnetildeling. Tid og budsjett er relativt lite for å implementere dem, og Hadoop gir også datalokalitet der dataene blir gjort tilgjengelig i noden som utførte jobben.

- FEILTOLERANSE

I den tradisjonelle RDBMS, når data går tapt på grunn av korrupsjon eller et nettverksproblem, tar det mer tid, kostnader og ressurs å få tilbake de tapte dataene. Men Hadoop har en mekanisme der dataene har minimum tre nivåer av replikasjonsfaktor for dataene som er lagret i HDFS. Hvis en av dataknodene som holder data blir mislykket, kan data enkelt trekkes fra andre dataknuter med høy tilgjengelighet av data. Derfor gjør dataene lett tilgjengelig for brukeren uavhengig av feil.

- FUNKSJONELL PROGRAMMERING

Hadoop støtter å skrive funksjonell programmering på språk som java, scala og python. For alle applikasjoner som krever ytterligere funksjonalitet kan implementeres ved å registrere UDF – Brukerdefinerte funksjoner i HDFS. I RDBMS er det ingen mulighet for å skrive UDF, og dette øker kompleksiteten ved å skrive SQL. Videre kan dataene som er lagret i HDFS nås av alle økosystemene i Hadoop som Hive, Pig, Sqoop og HBase. Så hvis UDF er skrevet, kan den brukes av hvilken som helst av de ovennevnte applikasjonene. Det øker ytelsen og støttbarheten til systemet.

- Optimalisering

Hadoop lagrer data i HDFS og Process om Map Reduce med enorme optimaliseringsteknikker. De mest populære teknikkene som brukes for å håndtere data bruker partisjonering og bucketing av lagrede data. Partisjonering er en tilnærming for lagring av dataene i HDFS ved å dele dataene basert på kolonnen som er nevnt for partisjonering. Når dataene blir injisert eller lastet inn i HDFS, identifiserer de partisjonskolonnen og skyver dataene inn i den aktuelle partisjonskatalogen. Så spørringen henter resultatsettet ved å hente dataene direkte fra den partisjonerte katalogen. Dette reduserer hele tabellskanningen, forbedrer responstiden og unngår latens.

En annen tilnærming kalles Bucketing of the data. Dette gjør det mulig for analytikeren å enkelt distribuere dataene mellom dataknodene. Alle nodene vil ha et like stort antall data distribuert. Bøttekolonnen er valgt på en slik måte at den har minst antall kardinalitet.

Disse tilnærmingene er ikke tilgjengelige i tradisjonell metode for SQL.

- DATA-TYPE

I en tradisjonell tilnærming er datatypen som støttes svært begrenset. Den støtter bare strukturerte data. Det vil ta mer tid å rengjøre og formatere skjemaet for seg selv. Men Hadoop støtter kompleks datatype som Array, Struct og Map. Dette oppfordrer til å bruke de forskjellige typene av et datasett som skal brukes til datalast. For Eks: XML-data kan lastes ved å definere dataene med XML-elementer som inneholder kompleks datatype.

- DATAKOMPRESJON

Det er veldig mindre innebygde komprimeringsteknikker tilgjengelig for det tradisjonelle databasesystemet. Men for Hadoop-rammeverket er det mange komprimeringsteknikker som gzib, bzip2, LZO og snappy. Standard komprimeringsmodus er LZ4. Til og med bordene kan komprimeres ved hjelp av komprimeringsteknikker som Parquet, ORC. Komprimeringsteknikker er med på å gjøre tabellene til å ta mindre plass og øke gjennomstrømningen og raskere utførelse av spørring.

Hadoop Vs SQL Comparision Table

| Kjennetegn | Tradisjonell SQL | Hadoop |

| Datastørrelse | gigabyte | petabyte |

| Adgang | Interaktiv og batch | Parti |

| oppdateringer | Les og skriv - Flere ganger | Skriv en gang, les flere ganger |

| Struktur | Statisk skjema | Dynamisk skjema |

| Integritet | Høy | Lav |

| skalering | Ikke-lineær | lineær |

Tabell : Sammenligning mellom tradisjonell Hadoop og SQL Framework.

Konklusjon - Hadoop Vs SQL

Totalt sett trer Hadoop foran den tradisjonelle SQL når det gjelder kostnader, tid, ytelse, pålitelighet, støttebarhet og tilgjengelighet av data for den veldig store brukergruppen. For å kunne håndtere den enorme mengden data som genereres hver dag, hjelper Hadoop-rammeverket med å innhente, lagre, behandle, filtrere og til slutt lagre dem på et sentralt sted i tide.

Anbefalt artikkel

- Hadoop vs Hive - Finn ut de beste forskjellene

- Lær den 10 nyttige forskjellen mellom Hadoop vs Redshift

- HADOOP vs RDBMS | Vet de 12 nyttige forskjellene

- Apache Hadoop vs Apache Spark | Topp 10 sammenligninger du må vite!

- Hadoop vs Spark: Funksjoner