Hvordan installere bikube?

Apache Hadoop er en samling av rammene som gjør det mulig å behandle big data distribuert over klyngen. I henhold til Apache Hive er et datavarehus-programvareprosjekt bygget på toppen av Apache Hadoop for å levere datasøk og analyse. Apache hive gir SQL-lignende grensesnitt til spørring og prosessering av en stor datamengde kalt HQL (Hive-spørringsspråk). Apache-bikube kjører på toppen av Hadoop-økosystemet, og dataene som er lagret i form av fil betyr Hadoop distribuert filsystem (HDFS). Apache Hive gir et flott grensesnitt for brukeren å få tilgang til og utføre en operasjon på dataene i form av en tabell. Den gir god optimaliseringsteknikk for å gjøre ytelsen bedre. Det er veldig utfordrende å gjøre spørringen raskere med big data og tro meg, det betyr noe i et produksjonsmiljø.

I backend konverterer kompilator HQL-spørring til kart redusere jobber og sendes deretter til Hadoop rammeverk for henrettelser.

Forskjell mellom Hive og SQL

Apache Hive ligner veldig på SQL, men som vi vet hive går på toppen av Hadoop-økosystemet og internt konverterer jobber til MR (Map Reduce jobs), utgjør det en viss forskjell mellom Hive og SQL.

Hive ville ikke være den beste tilnærmingen for de applikasjonene der det kreves veldig rask respons, og det er veldig viktig å forstå at Hive er bedre egnet for batchbehandling over veldig store sett med uforanderlig data, og vi bør merke oss at Hive er en vanlig RDBMS og sist men ikke minst er apachehive skjema på lesemidlene (mens du setter inn data i bikubetabellen vil den ikke bry seg om datatypefeil, men mens du leser data vil den vise null verdi hvis datatypen ikke stemmer overens med datatypen til den spesifikke kolonnen).

Forutgående krav til installasjon av bikube

Som jeg sa tidligere er det veldig viktig å forstå Apache-bikubeløp på toppen av Hadoop Ecosystem og Hadoop burde være i gang med alle demoner.

Noen av de grunnleggende Hadoop-demonene er som følger:

- Navnknute

- Datanode

- Ressurssjef

- Knutepunktleder

For å sjekke Hadoop-versjonen nedenfor er kommandoen:

Skriv → Hadoop-versjon i ledeteksten, den vil gi deg versjonen av Hadoop.

Slik sjekker du utløser Hadoop-klyngerapporten under kommandoen:

Skriv → Hadoop dfsadmin - Rapporter i ledeteksten, det vil gi deg hele klyngerapporten hvis serveren din kjører.

Hvis Hadoop ikke er installert på maskinen din som ber deg om å følge apache-instruksjonene for å installere Hadoop på systemet ditt.

Jeg håper at java allerede er installert på systemet ditt. for å sjekke java-versjonen, vennligst se skjermbildet nedenfor.

Trinn for å installere Hive på Ubuntu

Nedenfor er trinnene for å installere Hive på Ubuntu:

Trinn 1 : Hive-tjære kan vi laste ned ved å bruke kommandoen nedenfor i terminalen vi også kan laste ned direkte fra terminalen.

Kommando: vi får http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz

Trinn 2 : Pakk ut tarfilen ved å bruke kommandoen nedenfor i terminalen. Vi kan trekke ut tjæren over nedlastede tjærefilmfil direkte.

Kommando: tar -xzf apache-hive-2.1.0-bin.tar.gz

Jeg vil foreslå at du bekrefter med kommando om utvunnet bikupefil.

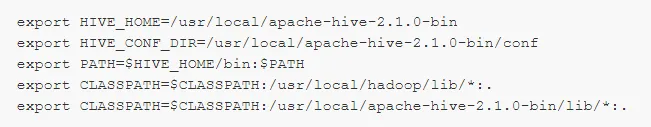

Trinn 3: Rediger “ .bashrc ” -filen for å oppdatere miljøvariablene for brukeren.

Kommando: sudo .bashrc

Legg til følgende på slutten av filen:

# Angi HIVE_HOME

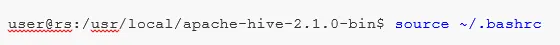

Utfør kommandoen nedenfor for å fullføre endringsarbeidet i den nåværende terminalen.

Kommando: kilde .bashrc

Trinn 5 : Vi må opprette Hive-kataloger innen HDFS-plassering, og i dette kataloget 'lager', vil det være stedet å lagre metadata-relatert informasjon om bikubben og data relatert til Hive.

Kommando :

- hdfs dfs -mkdir -p / bruker / bikube / lager

- hdfs dfs -mkdir / tmp

Trinn 6 : For å angi lese- og skrivetillatelse for bikubetabellen utføres kommandoen nedenfor.

Kommando:

I kommandoen nedenfor gir du skrivetillatelse til brukergruppen:

- hdfs dfs -chmod g + m / bruker / bikube / lager

- hdfs dfs -chmod g + m / tmp

Konfigurere Hive: Det er veldig viktig å peke på installere hive for å konfigurere med Hadoop. Vi må redigere hive-env.sh, en fil som er plassert i katalogen $ HIVE_HOME / conf. Følgende kommandoer omdirigerer til Hive conf-mappen og kopierer malfilen:

Trinn 7 : Sett en Hadoop- sti i hive-env.sh

Rediger filen hive-env.sh ved å legge til følgende linje:

Nå med denne prosessen er vi nesten ferdige, og installasjonen av bikuben er fullført vellykket, det er viktig å konfigurere Metastore med den eksterne databaseserveren, og som standard bruker Apache Hive framework Derby-databasen. Ved å bruke kommandoen nedenfor initialisere Derby-databasen.

Kommando: bin / schematool -initSchema -dbType derby

Trinn 8 : Start Hive .

Kommando: bikube (skriv bikube i terminalen i den andre bikupeterminalen vil åpne.)

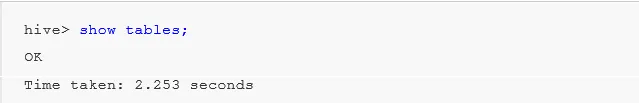

Arbeid med Hive: Nå får vi se noen av operasjonene i bikuben for å se hvor mange tabeller vi har i standard databasebruk, se under skjermbilder i skjermbildene nedenfor, det viser ikke noen tabeller betyr at vi ikke har noen tabeller i standarddatabasen .

For å lage en tabell i bikuben er det veldig viktig å henvise til den nødvendige databasen, ellers vil alle tabeller opprettes under standarddatabasen.

Viktige kommandoer i Hive

1: vis databaser (den vil vise alle databaser som er opprettet til ennå).

2: opprett databasen hvis ikke eksisterer mydb (denne kommandoen vil opprette en database med navnet ' mydb' hvis ' mydb' ikke eksisterer og hvis ' mydb allerede eksisterer vil den ikke gi noen feil i tillegg')

3: bruk databasen når vi må bruke noen DDl-kommando i den spesifikke databasen. Vi bør bruke kommandoen “bruk database” i vårt tilfelle vi allerede har opprettet “mydb” showkommando ville bli brukt mydb.

Viktig Hive DDL-kommando

SKAP, DROP, TRUNCATE, SHOW, DESCRIBE .

- Lag : - Lag en uttalelse som brukes til å opprette en database eller opprette en tabell i bikuben.

Eksempel: bikube> opprette database Company; (database opprette)

Hive> bruk Company;

Hive> lage bordansatt (id int, navn String, lønn String); (dette vil opprette tabellansatt under database Company fordi vi allerede har utført kommandoen Use database.)

- Beskriv gir informasjon om skjemaet i tabellen.

Hive> beskrive ansatt; (dette vil gi detaljert informasjon om skjemaet til ansattes tabell)

- TRUNCATE vil slette dataene i tabellen.

Hive> avkort bordansatt;

Vi kan installere Hive i et vindu også, men for beste praksis vil jeg foretrekke Ubuntu å bruke, det vil gi et bedre syn på produksjonsmiljøet og dataene dine vil øke i fremtiden vil det være lett å administrere.

Anbefalte artikler

Dette har vært en guide til Install Hive. Her har vi diskutert de forskjellige trinnene for å installere Hive, DDL-kommando osv. Du kan også se på følgende artikler for å lære mer:

- Slik installerer du SQL Server

- Slik installerer du MATLAB

- Hive-kommandoer og funksjon

- Grunnleggende spørsmål om Hive-intervju

- Hive Arkitektur | Arbeidsflyt

- Bruke ORDER BY-funksjon i Hive

- Installasjon av bikube