Oversikt over Install Hadoop

Følgende artikkel, Install Hadoop, gir en oversikt over de vanligste Hadoop-rammeverkets nøkkelmoduler og trinnvis installasjon for Hadoop. Apache Hadoop er en samling programvare som muliggjør behandling av store datasett og distribuert lagring over en klynge av forskjellige typer datasystem. For øyeblikket er Hadoop fortsatt den mest brukte analyseplattformen for store data ("Sanchita Lobo, forfatter på Analytics Training Blog, ").

Hadoop Framework

Apache Hadoop-rammeverket består av følgende nøkkelmoduler.

- Apache Hadoop Common.

- Apache Hadoop Distribuert filsystem (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (Nok en ressurssjef).

Apache Hadoop Common

Apache Hadoop Common-modulen består av delte biblioteker som forbrukes på tvers av alle andre moduler, inkludert nøkkelhåndtering, generiske I / O-pakker, biblioteker for metrisk samling og verktøy for register, sikkerhet og streaming.

HDFS

HDFS er basert på Google-filsystemet og er strukturert for å kjøre på maskinvare til lav pris. HDFS er tolerant for feil og er designet for applikasjoner som har store datasett.

Kart reduksjon

MapReduce er en iboende parallell programmeringsmodell for databehandling og Hadoop kan kjøre MapReduce-programmer skrevet på forskjellige språk som Java. MapReduce fungerer ved å dele opp behandlingen i kartfasen og redusere fasen.

Apache Hadoop YARN

Apache Hadoop YARN er en kjernekomponent og er ressursstyring og jobbplanleggingsteknologi i Hadoop distribuerte prosesseringsrammer.

I denne artikkelen skal vi diskutere installasjonen og konfigurasjonen av Hadoop 2.7.4 på en enkelt nodeklynge og teste konfigurasjonen ved å kjøre MapReduce-programmet kalt wordcount for å telle antall ord i filen. Vi vil videre se på noen viktige Hadoop File System-kommandoer.

Trinn for å installere Hadoop

Følgende er et sammendrag av oppgavene som er involvert i konfigurasjonen av Apache Hadoop.

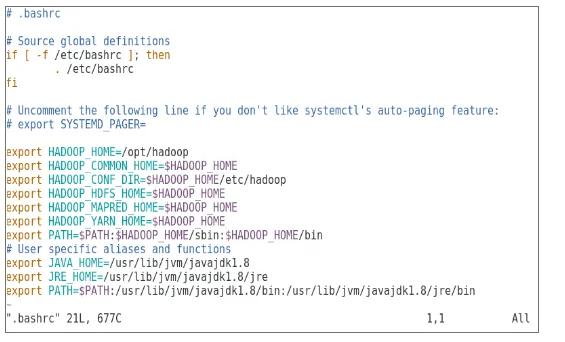

Oppgave 1: Den første oppgaven i Hadoop-installasjonen inkluderte å sette opp en virtuell maskinmal som ble konfigurert med Cent OS7. Pakker som Java SDK 1.8 og Runtime Systems som kreves for å kjøre Hadoop ble lastet ned og Java-miljøvariabelen for Hadoop ble konfigurert ved redigering av bash_rc.

Oppgave 2: pakken Hadoop Release 2.7.4 ble lastet ned fra nettstedet apache og ble trukket ut i opt-mappen. Som deretter ble omdøpt til Hadoop for enkel tilgang.

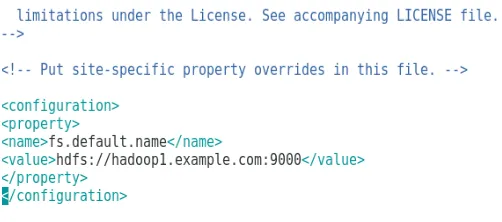

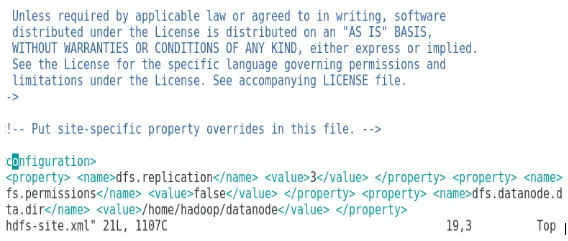

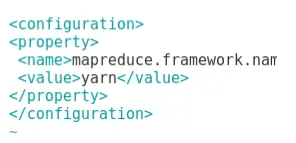

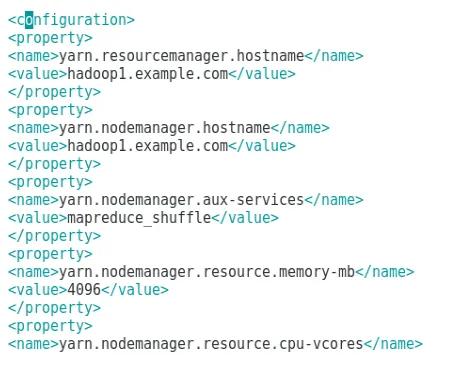

Oppgave 3: Når Hadoop-pakkene ble trukket ut, inkluderte neste trinn konfigurering av miljøvariabelen for Hadoop-bruker etterfulgt av konfigurering av Hadoop node XML-filer. I dette trinnet ble NameNode konfigurert i core-site.xml og DataNode ble konfigurert i hdfs-site.xml. Ressursbehandling og nodehåndtering ble konfigurert innenfor garn-site.xml.

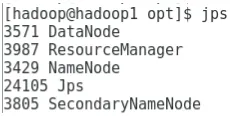

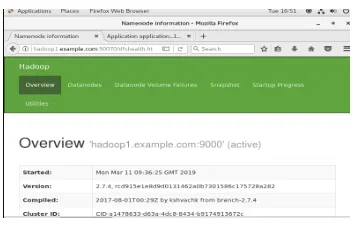

Oppgave 4: Brannmuren ble deaktivert for å starte YARN og DFS. JPS-kommando ble brukt til å bekrefte om relevante demoner kjører i bakgrunnen. Portnummeret for å få tilgang til Hadoop ble konfigurert til http: // localhost: 50070 /

Oppgave 5: De neste trinnene ble brukt til å verifisere og teste Hadoop. For dette har vi laget en midlertidig testfil i inputkatalogen for WordCount-programmet. Kartreduserende program Hadoop-MapReduce-eksempler2.7.4.jar ble brukt til å telle antall ord i filen. Resultatene ble evaluert på localhost og logger for den innsendte søknaden ble analysert. Alle MapReduce-søknader som sendes inn, kan vises på det elektroniske grensesnittet. Standard portnummer er 8088.

Oppgave 6: I den endelige oppgaven vil vi introdusere noen grunnleggende Hadoop File System-kommandoer og sjekke bruken av dem. Vi vil se hvordan en katalog kan opprettes i Hadoop-filsystemet, for å liste opp innholdet i en katalog, størrelsen i byte. Vi vil videre se hvordan du sletter en bestemt katalog og fil.

Resultater i Hadoop Installasjon

Følgende viser resultatene av hver av oppgavene ovenfor:

Resultat av oppgave 1

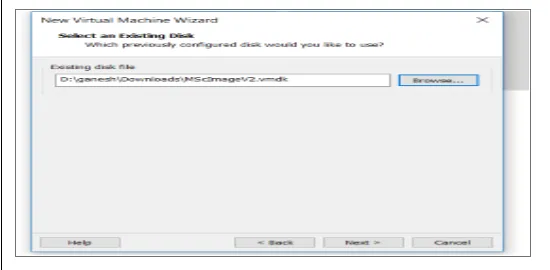

En ny virtuell maskin med et cenOS7-bilde er konfigurert til å kjøre Apache Hadoop. Figur 1 viser hvordan CenOS 7-bildet ble konfigurert i den virtuelle maskinen. Figur 1.2 viser konfigurasjonen av JAVA-miljøvariabelen innen .bash_rc.

Figur 1: Konfigurasjon av virtuell maskin

Figur 1.2: Java-miljøvariabelkonfigurasjon

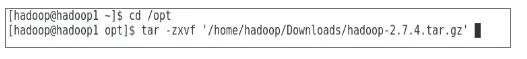

Resultat av oppgave 2

Figur 2 viser oppgaven som er utført for å trekke ut Hadoop 2.7.4-pakken i for å velge mappe.

Figur 2: Utvinning av Hadoop 2.7.4-pakken

Resultat av oppgave 3

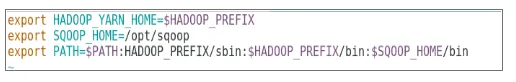

Figur 3 viser konfigurasjonen for miljøvariabelen for Hadoop-bruker, Figur 3.1 til 3.4 viser konfigurasjonen for XML-filer som er nødvendige for Hadoop-konfigurasjonen.

Figur 3: Konfigurere miljøvariabelen for Hadoop-bruker

Figur 3.1: Konfigurasjon av core-site.xml

Figur 3.2: Konfigurasjon av hdfs-site.xml

Figur 3.3: Konfigurasjon av mapred-site.xml-fil

Figur 3.4: Konfigurasjon av fil garn-site.xml

Resultat av oppgave 4

Figur 4 viser bruken av jps-kommandoen for å sjekke relevante demoner som kjører i bakgrunnen, og den følgende figuren viser Hadoops online brukergrensesnitt.

Figur 4: jps-kommando for å bekrefte kjøringer av demoner.

Figur 4.1: Få tilgang til Hadoop online grensesnitt på port http://hadoop1.example.com:50070/

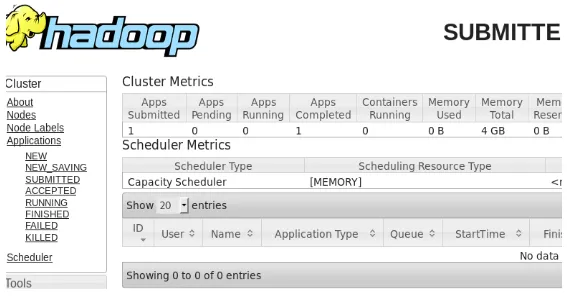

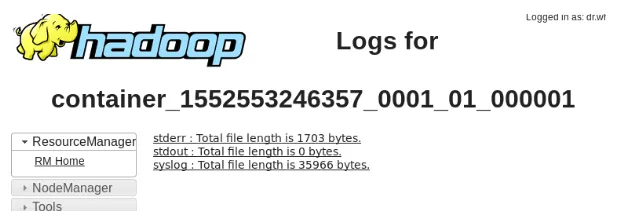

Resultat av oppgave 5

Figur 5 viser resultatet for MapReduce-programmet kalt wordcount som teller antall ord i filen. De neste par figurene viser YARN-ressurssjefens online brukergrensesnitt for den innsendte oppgaven.

Figur 5: MapReduce programresultater

Figur 5.1: Sendt kartreduserende applikasjon.

Figur 5.2: Logger for innsendt MapReduce-søknad.

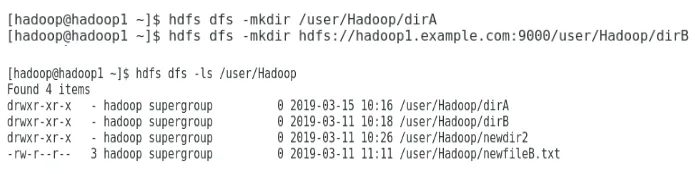

Resultat av oppgave 6

Figur 6 viser hvordan du oppretter en katalog i Hadoop-filsystemet og utfører en liste over hdfs-katalogen.

Figur 6: Opprette en katalog i Hadoop-filsystemet

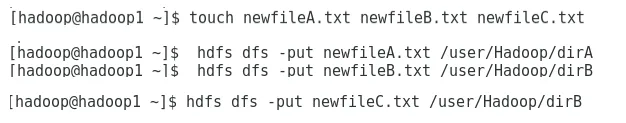

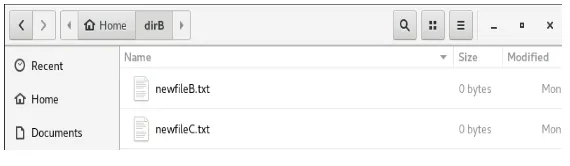

Figur 6.1 viser hvordan du legger en fil på Hadoop distribuerte filsystem, og figur 6.2 viser den opprettede filen i dirB-katalogen.

Figur 6.1: Opprette en fil i HDFS.

Figur 6.2: Ny fil opprettet.

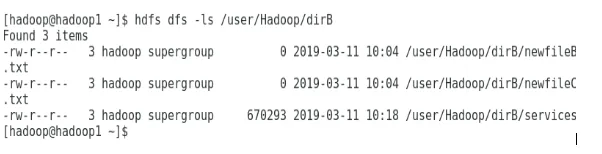

De neste figurene viser hvordan du viser innholdet i bestemte kataloger:

Figur 6.3: Innhold i dirA

Figur 6.4: Innhold av dirB

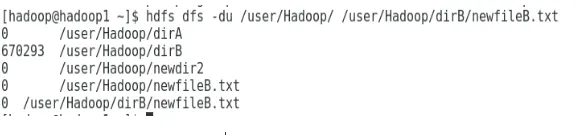

Den neste figuren viser hvordan fil- og katalogstørrelse kan vises:

Figur 6.5: Vis en fil- og katalogstørrelse.

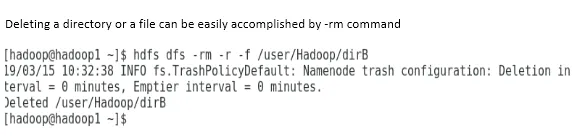

Slette en katalog eller en fil kan enkelt utføres med kommandoen -rm.

Figur 6.6: For å slette en fil.

Konklusjon

Big Data har spilt en veldig viktig rolle i utformingen av dagens verdensmarked. Hadoop-rammeverket gjør dataanalytiker livet enkelt mens du jobber med store datasett. Konfigurasjonen av Apache Hadoop var ganske enkel, og det elektroniske brukergrensesnittet ga brukeren flere alternativer for å stille inn og administrere applikasjonen. Hadoop har blitt brukt massivt i organisasjoner for datalagring, maskinlæreanalyse og sikkerhetskopiering av data. Det har vært ganske nyttig å administrere en stor mengde data på grunn av Hadoop distribuerte miljø og MapReduce. Hadoop-utvikling var ganske fantastisk sammenlignet med relasjonsdatabaser da de mangler innstillinger for tuning og ytelse. Apache Hadoop er en brukervennlig og rimelig løsning for å administrere og lagre store data effektivt. HDFS går også langt med å hjelpe til med lagring av data.

Anbefalte artikler

Dette er en guide for å installere Hadoop. Her diskuterer vi introduksjonen til Instal Hadoop, trinnvis installasjon av Hadoop sammen med resultatene av Hadoop Installation. Du kan også gå gjennom andre foreslåtte artikler for å lære mer -

- Introduksjon til Hadoop Streaming

- Hva er Hadoop Cluster, og hvordan fungerer det?

- Apache Hadoop økosystem og dets komponenter

- Hva er Hadoop-alternativene?