Introduksjon til Hadoop fs Commands

I denne artikkelen vil vi gå gjennom filhåndteringskommandoene til HADOOP, som brukes til å administrere filene gjennom konsollen.

Du trenger et Linux-system og den nyeste Hadoop-versjonen. For å skrive ut Hadoop-versjonen, for å vite av hvem utgivelsen ble bygget, kontrollsumverdi trenger vi bare å utføre kommandoen nedenfor etter innlogging på Hadoop-plattformen.

Kommando: Hadoop-versjon

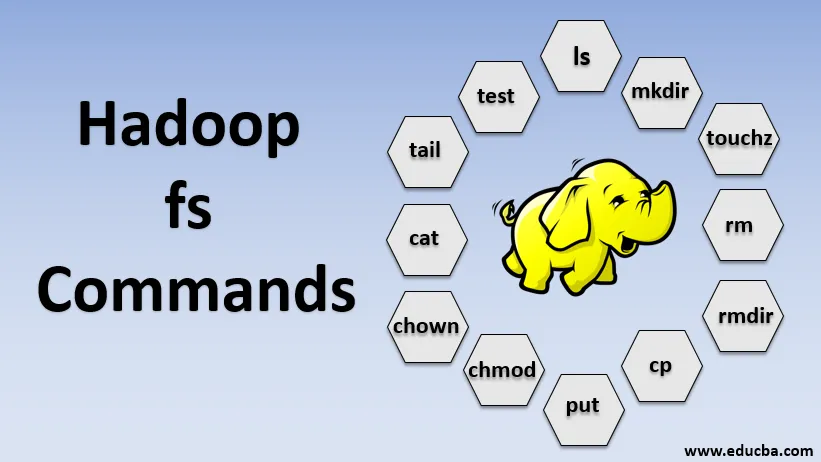

Kommandoer fra Hadoop fs

La oss nå lære hvordan du bruker HADOOP fs-kommandoer.

Vi begynner med det grunnleggende. Bare skriv disse kommandoene i PUTTY eller en hvilken som helst konsoll du er komfortabel med.

1. hadoop fs -ls

For en katalog returnerer den listen over filer og kataloger, mens den for statistikken returnerer statistikken for filen.

hadoop fs -lsr: dette er for rekursivt å liste opp kataloger og filer under spesifikke mapper.

- Eksempel : hadoop fs -ls / eller hadoop fs -lsr

- -d: Dette brukes til å liste katalogene som vanlige filer.

- -h: Dette brukes til å formatere størrelsene på filer på en menneskelig lesbar måte enn bare antall byte.

- -R: Dette brukes til å rekursivt liste innholdet i kataloger.

2. hadoop fs -mkdir

Denne kommandoen tar banen som et argument og oppretter kataloger i hdfs.

- Eksempel : hadoop fs -mkdir / bruker / datahub1 / data

3. hadoop fs -ouchouch

Den lager en tom fil og bruker ingen plass

- Eksempel: hadoop fs -ouchouch URI

4. hadoop fs -rm

Slett filer som er spesifisert som argument. Vi må spesifisere alternativet -r for å slette hele katalogen. Hvis alternativet -skipTrash er spesifisert, vil det hoppe over søppel, og filen blir slettet umiddelbart.

- Eksempel : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Den fjerner filer og tillatelser til kataloger og underkataloger. I utgangspunktet er det den utvidede versjonen av Hadoop fs-rm.

6. hadoop fs-cp

Den kopierer filen fra ett sted til et annet

- Eksempel : hadoop fs -cp /user/data/abc.csv / bruker / datahub

7. hadoop fs -copyFromLocal

Den kopierer filen fra edgenode til HDFS.

8. hadoop fs -put

Den kopierer filen fra edgenode til HDFS, den ligner den forrige kommandoen, men putter også leser innspill fra standard input stdin og skriver til HDFS

- Eksempel : hadoop fs -put abc.csv / bruker / data

hadoop fs -put -p: Flagget bevarer tilgang, endringstid, eierskap og modus.

hadoop fs -put -f: Denne kommandoen overskriver destinasjonen hvis filen allerede eksisterer før kopien.

9. hadoop fs -moveFromLocal

Det ligner på kopi fra lokalt bortsett fra at kildefilen blir slettet fra lokal edgenode etter at den er kopiert til HDFS

- Eksempel : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Den kopierer filen fra HDFS til edgenode.

- Eksempel : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Denne kommandoen hjelper oss med å endre tilgangen til en fil eller katalog

- Eksempel : hadoop fs -chmod (-R) (bane)

12. hadoop fs-chown

Denne kommandoen hjelper oss med å endre eierskapet til en fil eller katalog

- Eksempel : hadoop fs -chown (-R) (EIER) (:( GROUP)) PATH

13. hadoop fs -katt

Den skriver ut innholdet i en HDFS-fil på terminalen

- Eksempel : hadoop fs -cat /user/data/abc.csv

14. hadoop fs-tail

Den viser siste KB av HDFS-filen til stdout

- Eksempel : hadoop fs-tail / in / xyzfile

15. hadoop fs-test

Denne kommandoen brukes til HDFS-filtestoperasjoner, den returnerer 0 hvis sant.

- - e: sjekker om filen eksisterer.

- -z: sjekker om filen har null lengde

- -d / -f: sjekker om banen er henholdsvis katalog / fil

Her diskuterer vi et eksempel i detalj

- Eksempel : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Viser størrelser på filer og kataloger i den gitte katalogen eller lengden på en fil i tilfelle det er en fil

17. hadoop fs -df

Den viser ledig plass

18. hadoop fs-sjekk

Returnerer sjekkesuminformasjonen til en fil

19. hadoop fs -getfacl

Den viser tilgangskontrollisten (ACL-er) for den aktuelle filen eller katalogen

20. hadoop fs-antall

Den teller antall kataloger, filer og byte under banen som samsvarer med det spesifiserte filmønsteret.

21. hadoop fs -setrep

Endrer replikeringsfaktoren til en fil. Og hvis banen er en katalog, endrer kommandoen replikasjonsfaktoren for alle filene under katalogen.

- Eksempel : hadoop fs -setrep -R / bruker / datahub: den brukes til å godta bakoverfunksjonen og har ingen effekt.

hadoop fs - setrep -w / bruker / datahub : venter på at replikasjonen er fullført

22. hadoop fs -getmerge

Den sammenkoble HDFS-filer i kilden til den lokale destinasjonsfilen

- Eksempel : hadoop fs -getmerge / bruker / datahub

23. hadoop fs -appendToFile

Legger til en enkelt kilde eller flere kilder fra det lokale filsystemet til destinasjonen.

- Eksempel : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Den skriver ut statistikken om filen eller katalogen.

- Eksempel : hadoop fs -stat (format)

Konklusjon - Hadoop fs Kommandoer

Så vi har gått gjennom nesten alle kommandoene som er nødvendige for filhåndtering og se dataene i filene. Du kan endre filene dine og innta data i Hadoop-plattformen nå.

Anbefalte artikler

Dette er en guide til Hadoop fs kommandoer. Her diskuterer vi introduksjonen til Hadoop fs-kommandoer sammen med eksemplet i detalj. Du kan også se på følgende artikler for å lære mer-

- Installer Hadoop

- Hadoop Tools

- Hadoop Arkitektur

- Hadoop-komponenter

- Hadoop fs Kommandoer