Hva er gris?

Pig er en open source-motor, som er en del av Hadoop-økosystemteknologiene. Gris er flink til å jobbe med data som er utenfor tradisjonelle databaser eller datavarehus. Dette kan håndtere manglende, ufullstendige eller inkonsekvente data, som ikke har noe skjema. The Pig har sitt eget språk for å uttrykke datamanipulasjoner, som er Pig Latin.

Forstå Gris

Pig er en teknologi som lar deg skrive et høyt nivå, men ekstremt kornete skript, som lar deg jobbe med data der skjemaet enten er ukjent eller inkonsekvent. Pig er en åpen kildekode-teknologi som kjører på toppen av Hadoop og er en del av det ekstremt livlige og populære Hadoop-økosystemet.

Gris fungerer bra med ustrukturerte og ufullstendige data, slik at du ikke trenger å ha den tradisjonelle utformingen av regler og kolonner for alt.

Det er veldefinert, og det kan direkte fungere på filer i HDFS (Hadoop Distribuert filsystem).

The Pig vil være din valgte teknologi når du vil hente data fra kilden til et datavarehus.

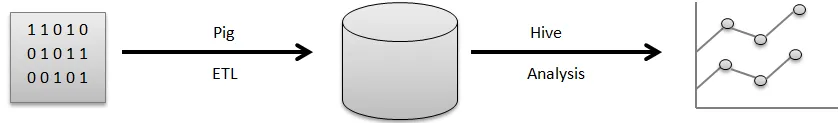

For eksempel en visuell rørledning om hvordan data vanligvis flyter før du kan bruke dem til å generere de fine diagrammer du bruker for å ta forretningsbeslutninger.

Rå data kommer fra en rekke kilder, for eksempel sensorer, mobiltelefoner osv. Du vil da bruke Pig til å utføre en ETL-operasjon. ETL står for å trekke ut, transformere og laste, når disse operasjonene er utført, lagres de rensede dataene i en annen database. Et eksempel på en slik database er HDFS, som er en del av Hadoop. Hive er et datavarehus som vil fungere på toppen av et filsystem som dette. Hive er det du vil bruke til analyse, for å generere rapportene og hente ut innsikt.

ETL er et veldig viktig trinn i databehandlingen for å få rene dataene ryddet opp og i riktig form som skal lagres i en database. Uttrekk refererer til driften av å trekke ustrukturerte, inkonsekvente data med manglende felt og verdier fra den opprinnelige kilden. Transform står for den operasjonsserien du bruker på dataene for å rydde opp eller få den.

Forberegning av nyttig samlet informasjon, behandling av felt for å matche et bestemt format, alt dette er en del av dataopprydding av transformasjonsfeltene.

Til slutt utfører Pig lastoperasjonen der disse rene dataene er lagret i en database der de kan analyseres ytterligere. Et eksempel på en standardoperasjon som Pig utfører er å rydde opp i loggfiler.

Forklar svinearkitektur

Det er mange svinedeler i arkitekturen, foretrekker:

- Parser : Parser tar for seg Pig Scripts så vel som, sjekker at syntaks av skriptet, vil skrive kontroll og forskjellige assorterte sjekker. I tillegg kan resultatet være en DAG (Directed Acyclic Graph) som vanligvis betegner Pig Latin-påstandene sammen med logiske operatører.

De logiske operatørene med skriptet vil også bli vist som noder, så vel som dataflyter blir vist siden kanter gjennom DAG.

- Optimizer: Senere overskrides den logiske planen (DAG) vanligvis mot den logiske optimalisatoren. Den utfører de logiske optimaliseringene i tillegg inkludert projeksjon og fremmer lav

- Compiler: I tillegg kompilerer kompilatoren den forbedrede logiske planen i en gruppe MapReduce-arbeider.

- Utførelsesmotor: Til syvende og sist vil alle MapReduce-verker bli lagt ut til Hadoop innen en sortert sekvens. Etter hvert genererer dette de nødvendige resultatene, selv om disse MapReduce-arbeidene vil bli utført med Hadoop.

- MapReduce: MapReduce ble opprinnelig designet i Google som en måte å behandle websider for å gi Google-søk. MapReduce distribuerer databehandling på flere maskiner i klyngen. MapReduce drar fordel av den iboende parallellen i databehandlingen. Moderne systemer, for eksempel sensorer, eller til og med Facebook-statusoppdateringer genererer millioner av poster med rå data.

En aktivitet med dette nivået kan utarbeides i to faser:

- Kart

- Redusere

Du bestemmer hvilken logikk du vil implementere i disse fasene for å behandle dataene dine.

- HDFS (Hadoop Distribuert filsystem): Hadoop gir mulighet for en eksplosjon av datalagring og analyse i en skala i en ubegrenset kapasitet. Utviklere bruker en applikasjon som Pig, Hive, HBase og Spark for å hente data fra HDFS.

Funksjoner

Apache Pig kommer med forskjellige funksjoner:

- Simplicity of Programming: Pig Latin er sammenlignbar med SQL, og derfor er det ganske enkelt for utviklere å lage et Pig-script. I tilfelle du har forståelse av SQL-språk, er det utrolig enkelt å lære gris-latin-språk, siden det er akkurat som SQL-språk.

- Rik sett med operatører: Pig inneholder en rekke rik sett med operatører for å kunne utføre prosedyrer akkurat som sammenføyning, filer, sortering og mye mer.

- Optimaliseringsmuligheter: Utførelsen med oppgaven i Apache Pig kan øyeblikkelig forbedres av selve oppgaven; derfor må utviklerne bare konsentrere seg om semantikken i dette språket.

- Utvidbarhet: Bruker tilgjengelige operatører, kan brukerne ganske enkelt utvikle funksjonene sine for å lese, behandle og skrive data.

- User Define Functions (UDF's): Ved å bruke tjenesten gitt av Pig for å lage UDF-er, kunne vi produsere User Defined Functions på antall utviklingsspråk, inkludert Java, samt påkalle eller legge inn dem alle i grisskripter.

Hva er gris nyttig for?

Det brukes til å undersøke og utføre ansvar inkludert ad-hoc-håndtering. Apache Pig kan brukes beregnet på:

Analyse med enorme rå datasamlinger foretrekker databehandling for å få søkenettsteder. Slik som Yahoo, fordeler Google Apache Pig for å evaluere data samlet inn via Google så vel som Yahoo-søkemotorer. Håndtere store datasamlinger akkurat som nettrekorder, streaming online info og så videre. Til og med Facebooks statusoppdateringer genererer millioner av poster med rå data.

Hvordan hjelper denne teknologien deg med å vokse i karrieren din?

Mange organisasjoner implementerer Apache Pig utrolig raskt. Dette betyr at yrker i gris og svinekarriere løfter hver dag. Det har vært enorm fremgang i utviklingen av Apache Hadoop i løpet av de siste par årene. Hadoop-elementer akkurat som Hive, Pig, HDFS, HBase, MapReduce, og så videre.

Selv om Hadoop-tilbudene kom inn i det andre tiåret på dette tidspunktet, har de imidlertid eksplodert i anerkjennelse gjennom de foregående tre til fire årene. Et stort antall programvareselskaper bruker Hadoop-klynger utrolig ofte. Dette kan definitivt være den beste delen av big data. Målet eksperter kan bli erfarne i denne utmerkede teknologien.

Konklusjon

Apache Pig Expertise er i stort krav i markedet og kan fortsette å være for utvidet. Ved å bare forstå konseptene så vel som å få erfaring med de beste Apache Pig i Hadoop ferdighetene, kan ekspertene engasjere seg perfekt i Apache Pig yrket.

Anbefalt artikkel

Dette har vært en guide til Hva er gris? Her diskuterte vi begreper, definisjon og arkitektur med funksjonene til gris. Du kan også gå gjennom andre foreslåtte artikler for å lære mer -

- Slik installerer du Apache

- Apache PIG intervjuspørsmål

- Hva er ASP.Net Web Services?

- Hva er Blockchain-teknologi?